Gli appassionati di intelligenza artificiale preferiscono lavorare con strumenti open source rispetto a quelli commerciali proprietari, secondo un sondaggio in corso su oltre 100.000 intervistati.

La comparsa di Mixtral 8x7B di Mistral AI, un modello open-source, ha avuto un impatto significativo nello spazio dell’intelligenza artificiale. Leggero e potente, TCN lo ha inserito tra i migliori LLM del 2023. Mixtral ha guadagnato molta attenzione per le sue notevoli prestazioni in vari test di benchmark, in particolare Chatbot Arena, che offre un approccio unico incentrato sull’uomo per valutare i LLM.

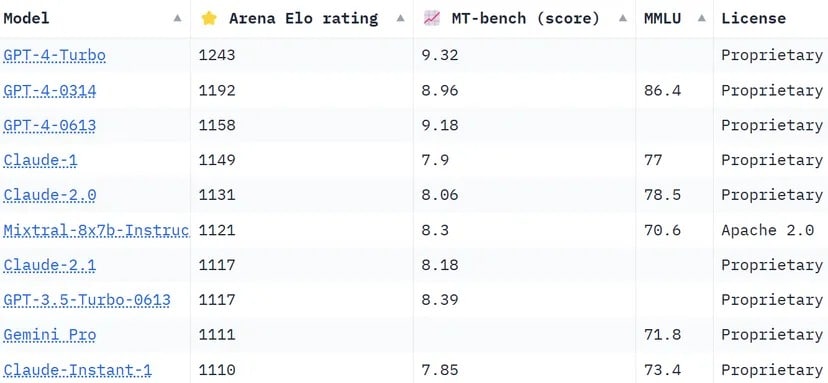

Le classifiche di Chatbot Arena, un elenco di crowdsourcing, sfruttano oltre 130.000 voti degli utenti per calcolare le valutazioni Elo dei modelli di intelligenza artificiale. Rispetto ad altri metodi che cercano di standardizzare i risultati per renderli più oggettivi, l’arena opta per un approccio più “umano”, chiedendo alle persone di scegliere tra due risposte fornite da LLM non identificati, alla cieca. Queste risposte possono apparire non convenzionali secondo certi standard, ma possono essere valutate intuitivamente da utenti umani reali.

Mixtral ha una posizione impressionante, superando giganti del settore come Claude 2.1 di Anthropíc, GPT-3.5 di OpenAI, che alimenta la versione gratuita di ChatGPT e Gemini di Google, un LLM multimodale che è stato venduto come il chatbot più potente per sfidare il dominio di GPT-4.

La classifica della Chatbot Arena. LLM di Mistral AI è al sesto posto della classifica. Immagine: Huggingface

Uno dei punti di forza di Mixtral è il fatto di essere l’unico LLM open-source nella top 10 della Chatbot Arena. Questa distinzione non è solo una questione di classifica, ma rappresenta un cambiamento significativo nel settore dell’IA verso modelli più accessibili e guidati dalla comunità. Come riportato da TCN, Mistral AI ha dichiarato che il suo modello “supera LlaMA 2 70B nella maggior parte dei benchmark con un’inferenza 6 volte più veloce e corrisponde o supera GPT 3.5 nella maggior parte dei benchmark standard” come MMLU, Arc-C o GSM.

Il segreto del successo di Mixtral sta nella sua architettura “Mixture of Experts” (MoE). Questa tecnica impiega più modelli di esperti virtuali, ciascuno specializzato in un argomento o campo distinto. Di fronte a un problema, Mixtral seleziona gli esperti più rilevanti dal suo pool, ottenendo risultati più accurati ed efficienti.

“A ogni livello, per ogni token, una rete di router sceglie due di questi gruppi (gli ‘esperti’) per elaborare il token e combinare i loro risultati in modo additivo”, spiega Mistral nel documento pubblicato di recente dal LLM. “Questa tecnica aumenta il numero di parametri di un modello, controllando al contempo i costi e la latenza, in quanto il modello utilizza solo una frazione del set totale di parametri per ogni token”.

Inoltre, Mixtral si distingue per la sua competenza multilingue. Il modello eccelle in lingue come il francese, il tedesco, lo spagnolo, l’italiano e l’inglese, dimostrando la sua versatilità e il suo ampio potenziale. La sua natura open-source, sotto licenza Apache 2.0, consente agli sviluppatori di esplorare, modificare e migliorare liberamente il modello, favorendo un ambiente collaborativo e innovativo.

Il successo di Mixtral non è chiaramente solo una questione di prodezza tecnologica; segna una piccola ma importante vittoria per la comunità dell’intelligenza artificiale open-source. Forse, in un futuro non troppo lontano, non ci si chiederà più quale modello sia nato per primo, o quale abbia più parametri o capacità di contesto, ma quale risuoni veramente con le persone.