Podle průběžného průzkumu mezi více než 100 000 respondenty dávají nadšenci do umělé inteligence přednost práci s open-source nástroji před proprietárními komerčními.

Výrazný vliv na oblast umělé inteligence měl vznik open-source modelu Mixtral 8x7B společnosti Mistral AI. Je lehký a výkonný, TCN jej zařadil mezi nejlepší LLM roku 2023. Mixtral si získal velkou pozornost díky svým pozoruhodným výkonům v různých srovnávacích testech, zejména v Chatbot Areně, která nabízí jedinečný přístup k hodnocení LLM zaměřený na člověka.

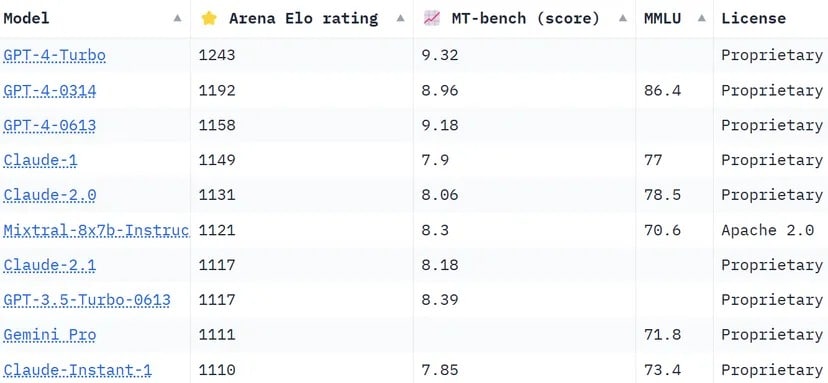

Žebříček Chatbot Arena, který je crowdsourcingovým seznamem, využívá více než 130 000 uživatelských hlasů k výpočtu hodnocení Elo pro modely AI. Oproti jiným metodám, které se snaží výsledky standardizovat, aby byly objektivnější, volí aréna „lidštější“ přístup a žádá lidi, aby si naslepo vybrali mezi dvěma odpověďmi poskytnutými neidentifikovanými LLMS. Tyto odpovědi se mohou podle určitých měřítek jevit jako nekonvenční, ale skuteční lidští uživatelé je mohou intuitivně vyhodnotit.

Mixtral má impozantní postavení a překonává takové giganty v oboru, jako je Claude 2.1 od Anthropíc, GPT-3.5 od OpenAI, který pohání bezplatnou verzi ChatGPT, a Gemini od Googlu, multimodální LLM, který byl prodáván jako nejvýkonnější chatbot, jenž má zpochybnit dominanci GPT-4.

Žebříček Chatbot Arena. Mistral AI LLM se v seznamu umístil na 6. místě. Obrázek: Huggingface

Jedním z pozoruhodných odlišení společnosti Mixtral je, že je jediným open-source LLM v první desítce Chatbot Areny. Toto ocenění není jen otázkou pořadí, ale představuje významný posun v odvětví umělé inteligence směrem k přístupnějším a komunitou řízeným modelům. Jak uvádí TCN, Mistral AI uvedl, že jeho model „překonává LlaMA 2 70B na většině benchmarků s 6x rychlejší inferencí a vyrovnává se nebo překonává GPT 3.5 na většině standardních benchmarků.“ jako MMLU, Arc-C nebo GSM.

Tajemství úspěchu systému Mixtral spočívá v jeho architektuře „Mixture of Experts“ (MoE). Tato technika využívá více virtuálních expertních modelů, z nichž každý se specializuje na určité téma nebo oblast. Při řešení problému vybere Mixtral ze svého souboru nejvhodnější experty, což vede k přesnějším a efektivnějším výstupům.

„Na každé vrstvě vybere směrovačová síť pro každý token dvě z těchto skupin („expertů“), které token zpracují a aditivně zkombinují své výstupy,“ vysvětlil Mistral v nedávno publikovaném článku LLM. „Tato technika zvyšuje počet parametrů modelu a zároveň kontroluje náklady a latenci, protože model využívá pouze zlomek celkové sady parametrů na jeden token.“

Mixtral navíc vyniká svou vícejazyčnou zběhlostí. Model vyniká v jazycích, jako je francouzština, němčina, španělština, italština a angličtina, což ukazuje jeho všestrannost a široký potenciál. Jeho open-source charakter pod licencí Apache 2.0 umožňuje vývojářům model volně zkoumat, upravovat a vylepšovat, což podporuje spolupráci a inovativní prostředí.

Úspěch modelu Mixtral zjevně není jen o technologické zdatnosti; znamená malé, ale důležité vítězství komunity open-source AI. Možná, že v nepříliš vzdálené budoucnosti se nebude řešit otázka, který model byl první nebo který má více parametrů či kontextových možností, ale který z nich skutečně rezonuje s lidmi.