Da sich realistische, von künstlicher Intelligenz erzeugte Fotos und Videos im Internet immer weiter verbreiten, bemühen sich Technologieunternehmen und Überwachungsorganisationen um die Entwicklung von Tools zur Erkennung gefälschter Inhalte.

Eine häufig vorgeschlagene Lösung besteht darin, computergenerierte Bilder mit einem Wasserzeichen zu versehen. Dabei wird eine unsichtbare Markierung in Form von versteckten Metadaten hinzugefügt, die erkennen lässt, dass ein Bild mit einem generativen KI-Tool erstellt wurde. Forscher haben jedoch herausgefunden, dass solche Wasserzeichen einen großen Schwachpunkt haben: Sie können von gegnerischen Techniken leicht entfernt werden.

Jetzt schlagen die großen Kamerahersteller einen anderen Ansatz vor – gewissermaßen das Gegenteil: Sie betten Wasserzeichen in „echte“ Fotos ein.

Nikon, Sony und Canon haben kürzlich eine gemeinsame Initiative angekündigt, um digitale Signaturen in Bilder einzubauen, die direkt von ihren spiegellosen High-End-Kameras aufgenommen wurden. Nach Angaben von Nikkei Asia werden die Signaturen wichtige Metadaten wie Datum, Uhrzeit, GPS-Standort und Angaben zum Fotografen integrieren und die digitale Herkunft jedes Fotos kryptografisch bestätigen.

Nikon sagte, dass es diese Funktion in seiner kommenden Reihe professioneller spiegelloser Kameras einführen wird; Sony wird Firmware-Updates herausgeben, um digitale Signaturen in seine aktuellen spiegellosen Kameras einzufügen; und Canon beabsichtigt, Kameras mit eingebauter Authentifizierung im Jahr 2024 einzuführen, zusammen mit Video-Wasserzeichen später im selben Jahr.

Ziel ist es, so Nikkei, Fotojournalisten, Medienschaffenden und Künstlern einen unwiderlegbaren Beweis für die Glaubwürdigkeit ihrer Bilder zu liefern. Die fälschungssicheren Signaturen verschwinden nicht bei Bearbeitungen und sollen den Kampf gegen Fehlinformationen und die betrügerische Verwendung von Fotos im Internet unterstützen.

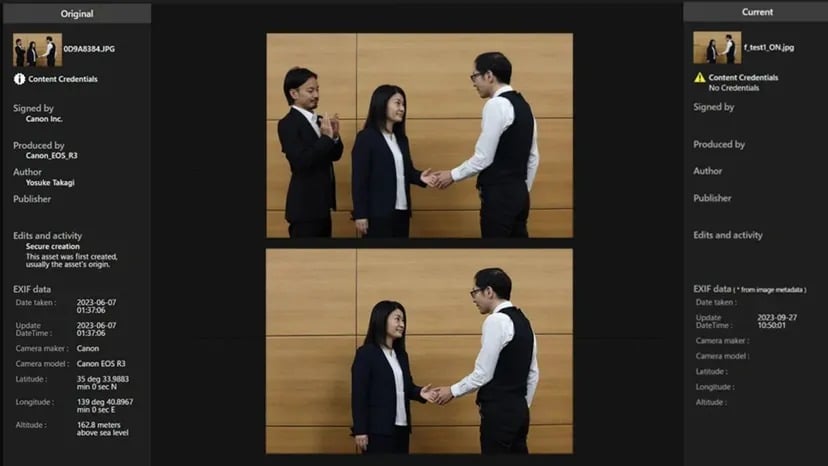

Um dies zu unterstützen, haben die Unternehmen gemeinsam einen offenen Standard für interoperable digitale Signaturen mit dem Namen „Verify“ entwickelt. Sobald dieser Standard eingeführt ist, können Fotos, die mit geeigneter Hardware aufgenommen wurden, kostenlos online überprüft werden, so dass die Menschen feststellen können, ob ein Foto authentisch ist oder nicht.

Wenn ein von einer künstlichen Intelligenz erzeugtes Foto das Verify-System ohne authentische Signatur zu passieren versucht, wird es als „No Content Credentials“ gekennzeichnet.

Quelle: Canon

Anstatt KI-Inhalte rückwirkend zu markieren, werden echte Fotos direkt am Entstehungsort authentifiziert. Aber wie bei jedem anderen Wasserzeichensystem wird der Erfolg von einer breiten Akzeptanz (mehr Hardware-Hersteller übernehmen den Standard) und einer zeitbeständigen Implementierung (der Code wird so weiterentwickelt, dass er nicht gehackt werden kann) abhängen.

Wie TCN berichtete, deuten jüngste Forschungsergebnisse darauf hin, dass Anti-Wasserzeichen-Techniken auch eingebettete Signaturen kompromittieren könnten, was die derzeitigen Wasserzeichen-Methoden unbrauchbar macht. Dadurch werden die mit Wasserzeichen versehenen Bilder jedoch nur unkenntlich gemacht, so dass den Nutzern weniger Möglichkeiten zur Verfügung stehen, um ihre Künstlichkeit zu erkennen.

Anti-Wasserzeichen-Techniken könnten zwar möglicherweise die Echtheitssignaturen von echten Fotos entfernen, doch ist dies weniger problematisch als das Entfernen von Wasserzeichen aus von KI generierten gefälschten Bildern. Und warum? Wenn ein Wasserzeichen von einer KI-Fälschung entfernt wird, lässt sich der gefälschte Inhalt leichter als echt ausgeben. Wenn jedoch Authentifizierungssignaturen von echten Fotos gehackt werden, ist das verbleibende Bild immer noch von einer Kamera aufgenommen worden – es stammt nicht von einem generativen Modell. Obwohl es seinen kryptografischen Beweis verliert, ist der zugrunde liegende Inhalt immer noch echt.

Das Hauptrisiko liegt in diesem Fall in der Zuordnung und Rechteverwaltung, nicht in der Wahrhaftigkeit des Inhalts. Das Bild könnte falsch zugeordnet oder ohne entsprechende Lizenzierung verwendet werden, aber es führt den Betrachter nicht zwangsläufig in die Irre, was die Realität betrifft, die es darstellt.

OpenAI hat kürzlich einen KI-gestützten Deepfake-Detektor angekündigt, der nach eigenen Angaben eine 99%ige Genauigkeit bei Bildern aufweist. Dennoch sind KI-Detektoren nach wie vor unvollkommen und müssen ständig verbessert werden, um mit der Entwicklung der generativen Technologie Schritt zu halten.

Der jüngste Anstieg der Deepfake-Raffinesse hat in der Tat die Notwendigkeit solcher Strategien ins Rampenlicht gerückt. Wie wir im Jahr 2023 gesehen haben, war die Notwendigkeit, zwischen echten und gefälschten Inhalten zu unterscheiden, noch nie so groß wie heute. Sowohl Politiker als auch Technologieentwickler bemühen sich, praktikable Lösungen zu finden, daher ist ein wenig Hilfe von diesen Unternehmen sicherlich willkommen.