Ponieważ realistyczne zdjęcia i filmy generowane przez sztuczną inteligencję rozprzestrzeniają się w Internecie, firmy technologiczne i grupy nadzorujące ścigają się w opracowywaniu narzędzi do identyfikacji fałszywych treści.

Powszechnie proponowanym rozwiązaniem jest znak wodny generowany komputerowo, dodający niewidoczną flagę w postaci ukrytych metadanych, które pomagają ujawnić, że obraz został utworzony przy użyciu generatywnego narzędzia sztucznej inteligencji. Naukowcy odkryli jednak, że taki znak wodny ma jedną poważną wadę: techniki adwersarskie mogą go łatwo usunąć.

Teraz główni producenci aparatów proponują inne podejście – w pewnym sensie odwrotne: zamiast tego osadzają znaki wodne na „prawdziwych” zdjęciach.

Firmy Nikon, Sony i Canon ogłosiły niedawno wspólną inicjatywę mającą na celu umieszczenie podpisów cyfrowych na zdjęciach wykonanych bezpośrednio z ich wysokiej klasy aparatów bezlusterkowych. Według Nikkei Asia, podpisy będą integrować kluczowe metadane, takie jak data, godzina, lokalizacja GPS i dane fotografa, kryptograficznie poświadczając cyfrowe pochodzenie każdego zdjęcia.

Nikon zapowiedział, że uruchomi tę funkcję w swojej nadchodzącej linii profesjonalnych aparatów bezlusterkowych; Sony wyda aktualizacje oprogramowania układowego, aby wstawić podpisy cyfrowe do swoich obecnych aparatów bezlusterkowych; a Canon zamierza zadebiutować aparatami z wbudowanym uwierzytelnianiem w 2024 roku, wraz z wideo znakami wodnymi jeszcze w tym samym roku.

Jak donosi Nikkei, celem jest zapewnienie fotoreporterom, pracownikom mediów i artystom niepodważalnego dowodu wiarygodności ich zdjęć. Odporne na manipulacje podpisy nie znikną z edycji i powinny pomóc w walce z dezinformacją i nieuczciwym wykorzystaniem zdjęć online.

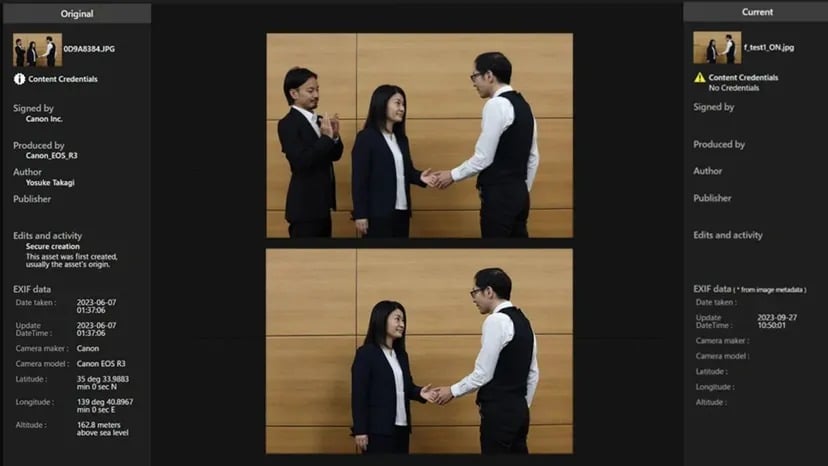

W tym celu firmy współpracowały nad otwartym standardem interoperacyjnych podpisów cyfrowych o nazwie „Verify”. Po jego wdrożeniu zdjęcia wykonane przy użyciu odpowiedniego sprzętu będą mogły być bezpłatnie sprawdzane online, aby ludzie mogli określić, czy zdjęcie jest autentyczne, czy nie.

Jeśli zdjęcie wygenerowane przez sztuczną inteligencję spróbuje przejść przez system Verify bez autentycznego podpisu, zostanie oznaczone jako „Brak poświadczeń treści”.

Źródło: Canon

Zamiast wstecznego oznaczania treści AI, plan bezpośrednio uwierzytelnia prawdziwe zdjęcia w momencie ich powstania. Ale jak każdy inny system znakowania wodnego, jego sukces będzie zależał od powszechnego przyjęcia (więcej producentów sprzętu wdroży standard) i odpornej na czas implementacji (kod ewoluuje, aby pozostać niemożliwym do zhakowania).

Jak donosi TCN, ostatnie badania wskazują, że techniki anty-znakowania wodnego mogą również naruszać wbudowane podpisy, czyniąc obecne metody znakowania wodnego bezużytecznymi. Sprawia to jednak, że obrazy ze znakami wodnymi nie są znakami wodnymi, więc ludzie mają mniej narzędzi do wykrywania ich sztuczności.

Podczas gdy techniki anty-znakowania wodnego mogą potencjalnie usuwać podpisy autentyczności z prawdziwych zdjęć, jest to mniej problematyczne niż usuwanie znaków wodnych z fałszywych obrazów generowanych przez sztuczną inteligencję. Dlaczego? Jeśli znak wodny zostanie usunięty z deepfake’u sztucznej inteligencji, umożliwi to łatwiejsze uznanie sfałszowanej treści za prawdziwą. Jeśli jednak podpisy uwierzytelniające zostaną usunięte z prawdziwych zdjęć, pozostały obraz jest nadal przechwytywany przez kamerę – nie pochodzi z modelu generatywnego. Chociaż traci swój dowód kryptograficzny, podstawowa treść jest nadal autentyczna.

Główne ryzyko w tym przypadku związane jest z przypisywaniem i zarządzaniem prawami, a nie z prawdziwością treści. Obraz może być błędnie przypisany lub wykorzystany bez odpowiedniej licencji, ale z natury nie wprowadza widzów w błąd co do rzeczywistości, którą reprezentuje

OpenAI ogłosiło niedawno oparty na sztucznej inteligencji wykrywacz deepfake’ów, który, jak twierdzi, ma 99% dokładności na obrazach. Jednak detektory AI pozostają niedoskonałe i muszą być stale ulepszane, aby wyprzedzić ewolucję technologii generatywnej.

Niedawny wzrost wyrafinowania deepfake rzeczywiście zwrócił uwagę na konieczność takich strategii. Jak widzieliśmy w 2023 r., potrzeba rozróżnienia między treściami prawdziwymi a sfabrykowanymi nigdy nie była bardziej dotkliwa. Zarówno politycy, jak i twórcy technologii starają się znaleźć realne rozwiązania, więc niewielka pomoc ze strony tych firm z pewnością zostanie doceniona.