A comunidade de inteligência artificial tem um novo trunfo no seu chapéu com o lançamento do Falcon 180B, um modelo de grande linguagem (LLM) de código aberto com 180 mil milhões de parâmetros treinados numa montanha de dados. Este poderoso recém-chegado ultrapassou os anteriores LLMs de código aberto em várias frentes.

Anunciado num blogue da comunidade Hugging Face AI, o Falcon 180B foi lançado no Hugging Face Hub. A arquitetura do modelo mais recente baseia-se na série Falcon anterior de LLMs de código aberto, aproveitando inovações como a atenção multiquery para escalar até 180 mil milhões de parâmetros treinados em 3,5 triliões de tokens.

Isso representa o mais longo pré-treinamento de uma única época para um modelo de código aberto até hoje. Para atingir essas marcas, 4.096 GPUs foram usadas simultaneamente por cerca de 7 milhões de horas de GPU, usando o Amazon SageMaker para treinamento e refinamento.

Para colocar o tamanho do Falcon 180B em perspetiva, os seus parâmetros são 2,5 vezes maiores do que o modelo LLaMA 2 da Meta. O LLaMA 2 foi anteriormente considerado o LLM de código aberto mais capaz após seu lançamento no início deste ano, ostentando 70 bilhões de parâmetros treinados em 2 trilhões de tokens.

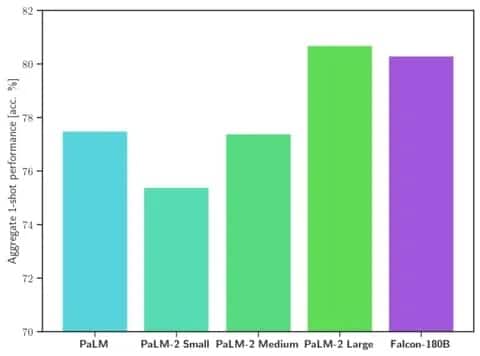

O Falcon 180B ultrapassa o LLaMA 2 e outros modelos, tanto em termos de escala como de desempenho de referência, numa série de tarefas de processamento de linguagem natural (PNL). Está classificado na tabela de classificação para modelos de acesso aberto com 68,74 pontos e alcança quase a paridade com modelos comerciais como o PaLM-2 da Google em avaliações como o benchmark HellaSwag.

Imagem: Cara de abraço

Especificamente, o Falcon 180B iguala ou excede o PaLM-2 Medium em benchmarks normalmente utilizados, incluindo HellaSwag, LAMBADA, WebQuestions, Winogrande e outros. Está basicamente a par do PaLM-2 Large da Google. Isto representa um desempenho extremamente forte para um modelo de código aberto, mesmo quando comparado com soluções desenvolvidas por gigantes do sector.

Quando comparado com o ChatGPT, o modelo é mais potente do que a versão gratuita, mas um pouco menos capaz do que o serviço pago “plus”.

“O Falcon 180B normalmente fica entre o GPT 3.5 e o GPT4, dependendo do benchmark de avaliação, e será muito interessante acompanhar o ajuste fino da comunidade agora que ele foi lançado abertamente”, diz o blog.

O lançamento do Falcon 180B representa o último salto em frente no rápido progresso que tem sido feito recentemente com os LLMs. Além de apenas aumentar os parâmetros, técnicas como LoRAs, randomização de peso e Perfusão da Nvidia permitiram um treinamento dramaticamente mais eficiente de grandes modelos de IA.

Com o Falcon 180B agora disponível gratuitamente no Hugging Face, os investigadores prevêem que o modelo irá registar ganhos adicionais com outras melhorias desenvolvidas pela comunidade. No entanto, a sua demonstração de capacidades avançadas de linguagem natural logo à partida marca um desenvolvimento empolgante para a IA de código aberto.