La comunidad de inteligencia artificial tiene una nueva pluma en su gorra con el lanzamiento de Falcon 180B, un gran modelo lingüístico (LLM) de código abierto que cuenta con 180.000 millones de parámetros entrenados en una montaña de datos. Este potente recién llegado ha superado a los anteriores LLM de código abierto en varios frentes.

Falcon 180B se ha publicado en Hugging Face Hub, un blog de la comunidad de IA Hugging Face. La arquitectura del último modelo se basa en la anterior serie Falcon de LLM de código abierto, aprovechando innovaciones como la atención multiconsulta para escalar hasta 180.000 millones de parámetros entrenados en 3,5 billones de tokens.

Esto representa el preentrenamiento de una sola etapa más largo para un modelo de código abierto hasta la fecha. Para alcanzar tales marcas, se utilizaron simultáneamente 4.096 GPU durante unos 7 millones de horas de GPU, utilizando Amazon SageMaker para el entrenamiento y el refinamiento.

Para poner el tamaño del Falcon 180B en perspectiva, sus parámetros miden 2,5 veces más que el modelo LLaMA 2 de Meta. LLaMA 2 fue considerado anteriormente el LLM de código abierto más capaz tras su lanzamiento a principios de este año, con 70.000 millones de parámetros entrenados en 2 billones de tokens.

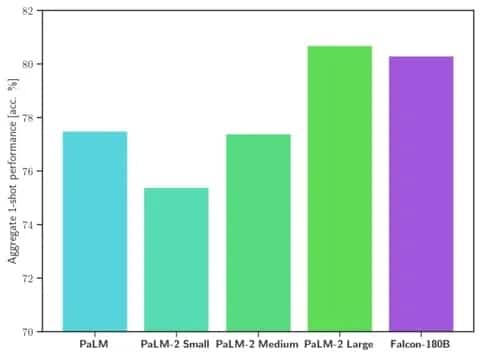

Falcon 180B supera a LLaMA 2 y a otros modelos tanto en escala como en rendimiento en una serie de tareas de procesamiento del lenguaje natural (PLN). Se sitúa a la cabeza de los modelos de acceso abierto con 68,74 puntos y alcanza casi la paridad con modelos comerciales como PaLM-2 de Google en evaluaciones como la de HellaSwag.

Imagen: Cara abrazada

En concreto, Falcon 180B iguala o supera a PaLM-2 Medium en las pruebas de rendimiento más utilizadas, como HellaSwag, LAMBADA, WebQuestions y Winogrande, entre otras. Básicamente, está a la altura del PaLM-2 Large de Google. Esto representa un rendimiento extremadamente bueno para un modelo de código abierto, incluso cuando se compara con soluciones desarrolladas por gigantes del sector.

Si se compara con ChatGPT, el modelo es más potente que la versión gratuita, pero un poco menos capaz que el servicio «plus» de pago.

«Falcon 180B se sitúa típicamente entre GPT 3.5 y GPT4 dependiendo del benchmark de evaluación, y será muy interesante seguir los ajustes de la comunidad ahora que se ha liberado abiertamente», dice el blog.

El lanzamiento de Falcon 180B representa el último salto adelante en el rápido progreso que se ha realizado recientemente con los LLM. Más allá del simple escalado de parámetros, técnicas como los LoRA, la aleatorización de pesos y la Perfusión de Nvidia han permitido un entrenamiento mucho más eficiente de grandes modelos de IA.

Ahora que Falcon 180B está disponible gratuitamente en Hugging Face, los investigadores prevén que el modelo obtendrá beneficios adicionales con las mejoras desarrolladas por la comunidad. Sin embargo, su demostración de capacidades avanzadas de lenguaje natural desde el primer momento supone un avance apasionante para la IA de código abierto.