Общността на изкуствения интелект има ново перо в шапката си с пускането на Falcon 180B – голям езиков модел (LLM) с отворен код, който може да се похвали със 180 милиарда параметри, обучени на планина от данни. Този мощен новак надминава предишните LLM с отворен код на няколко фронта.

Обявен в публикация в блога на общността за изкуствен интелект Hugging Face, Falcon 180B е публикуван в Hugging Face Hub. Архитектурата на най-новия модел надгражда предишната серия LLM с отворен код Falcon, като използва нововъведения като внимание към многозапитните, за да се мащабира до 180 милиарда параметъра, обучени върху 3,5 трилиона токена.

Това представлява най-продължителното предварително обучение с една точка за модел с отворен код до момента. За да се постигнат такива резултати, бяха използвани едновременно 4096 графични процесора за около 7 милиона GPU часа, като за обучението и усъвършенстването се използваше Amazon SageMaker.

За да се представи размерът на Falcon 180B в перспектива, неговите параметри са 2,5 пъти по-големи от модела LLaMA 2 на Meta. LLaMA 2 преди това беше считан за най-способния LLM с отворен код след пускането му в експлоатация по-рано тази година, като можеше да се похвали със 70 милиарда параметри, обучени върху 2 трилиона токена.

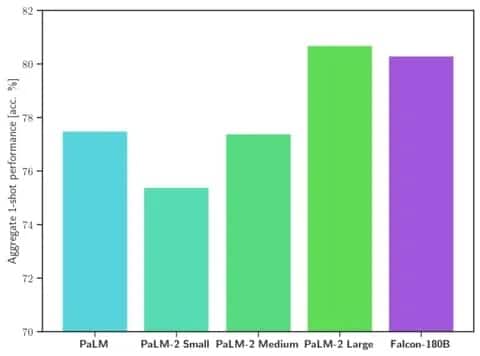

Falcon 180B превъзхожда LLaMA 2 и други модели както по мащаб, така и по бенчмарк производителност в редица задачи за обработка на естествен език (NLP). Той се нарежда в класацията на моделите със свободен достъп с 68,74 точки и достига почти равенство с комерсиални модели като PaLM-2 на Google при оценки като бенчмарка HellaSwag.

Изображение: Прегръщащо лице

По-специално, Falcon 180B съвпада или надхвърля PaLM-2 Medium при често използвани бенчмаркове, включително HellaSwag, LAMBADA, WebQuestions, Winogrande и др. По същество той е равностоен на PaLM-2 Large на Google. Това представлява изключително висока производителност за модел с отворен код, дори когато се сравнява с решения, разработени от гиганти в бранша.

Когато се сравнява с ChatGPT, моделът е по-мощен от безплатната версия, но малко по-малко способен от платената услуга „плюс“.

„Falcon 180B обикновено се намира някъде между GPT 3,5 и GPT4 в зависимост от оценъчния бенчмарк, а по-нататъшните доработки от страна на общността ще бъдат много интересни за проследяване сега, когато е отворен“, се казва в блога.

Пускането на Falcon 180B представлява последният скок напред в бързия напредък, който бе постигнат напоследък с LLM. Освен простото мащабиране на параметрите, техники като LoRAs, рандомизация на теглото и Perfusion на Nvidia позволиха драстично по-ефективно обучение на големи модели на изкуствен интелект.

След като Falcon 180B вече е свободно достъпен в Hugging Face, изследователите очакват, че моделът ще отбележи допълнителни постижения с по-нататъшни подобрения, разработени от общността. Демонстрацията на разширени възможности за работа с естествен език още от самото начало обаче бележи вълнуващо развитие на ИИ с отворен код.