La comunità dell’intelligenza artificiale ha un nuovo fiore all’occhiello con il rilascio di Falcon 180B, un modello linguistico di grandi dimensioni (LLM) open-source che vanta 180 miliardi di parametri addestrati su una montagna di dati. Questo potente nuovo arrivato ha superato i precedenti LLM open-source su diversi fronti.

Annunciato in un post sul blog della comunità Hugging Face AI, Falcon 180B è stato rilasciato su Hugging Face Hub. L’architettura dell’ultimo modello si basa sulla precedente serie di LLM open source Falcon, sfruttando innovazioni come l’attenzione multiquery per scalare fino a 180 miliardi di parametri addestrati su 3,5 trilioni di token.

Questo rappresenta il più lungo preaddestramento su un singolo peoch per un modello open source fino ad oggi. Per raggiungere questi risultati, sono state utilizzate simultaneamente 4.096 GPU per circa 7 milioni di ore GPU, utilizzando Amazon SageMaker per l’addestramento e l’affinamento.

Per mettere in prospettiva le dimensioni di Falcon 180B, i suoi parametri sono 2,5 volte più grandi del modello LLaMA 2 di Meta. LLaMA 2, dopo il lancio all’inizio di quest’anno, era considerato il modello LLM open-source più capace, con 70 miliardi di parametri addestrati su 2.000 miliardi di token.

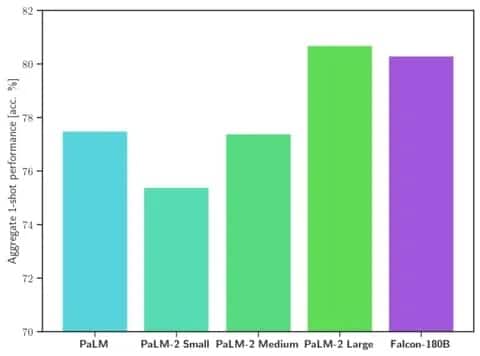

Falcon 180B supera LLaMA 2 e altri modelli sia in termini di scala che di prestazioni di benchmark in una serie di compiti di elaborazione del linguaggio naturale (NLP). Si posiziona nella classifica dei modelli open access con 68,74 punti e raggiunge quasi la parità con modelli commerciali come PaLM-2 di Google su valutazioni come il benchmark HellaSwag.

Immagine: Hugging Face

Specificamente, Falcon 180B eguaglia o supera PaLM-2 Medium su benchmark comunemente utilizzati, tra cui HellaSwag, LAMBADA, WebQuestions, Winogrande e altri. È praticamente alla pari con il PaLM-2 Large di Google. Si tratta di prestazioni estremamente elevate per un modello open-source, anche se confrontate con soluzioni sviluppate da giganti del settore.

Se confrontato con ChatGPT, il modello è più potente della versione gratuita ma un po’ meno capace del servizio “plus” a pagamento.

“Falcon 180B si colloca tipicamente tra GPT 3.5 e GPT4, a seconda del benchmark di valutazione, e sarà molto interessante seguire l’ulteriore messa a punto da parte della comunità ora che è stato rilasciato”, si legge nel blog.

Il rilascio di Falcon 180B rappresenta l’ultimo balzo in avanti nei rapidi progressi compiuti di recente con gli LLM. Al di là del semplice aumento dei parametri, tecniche come i LoRA, la randomizzazione dei pesi e Perfusion di Nvidia hanno permesso un addestramento molto più efficiente di modelli AI di grandi dimensioni.

Con Falcon 180B ora disponibile gratuitamente su Hugging Face, i ricercatori prevedono che il modello otterrà ulteriori guadagni con ulteriori miglioramenti sviluppati dalla comunità. Tuttavia, la sua dimostrazione di capacità avanzate di linguaggio naturale fin dall’inizio segna uno sviluppo entusiasmante per l’IA open-source.