La communauté de l’intelligence artificielle s’est enrichie d’une nouvelle plume avec la publication de Falcon 180B, un grand modèle de langage (LLM) open-source doté de 180 milliards de paramètres entraînés sur une montagne de données. Ce puissant nouveau venu a surpassé les précédents LLM open-source sur plusieurs fronts.

Annoncé dans un billet de blog par la communauté Hugging Face AI, Falcon 180B a été publié sur Hugging Face Hub. L’architecture du dernier modèle s’appuie sur la série précédente de LLM open source Falcon, en tirant parti d’innovations telles que l’attention multi-requête pour passer à 180 milliards de paramètres formés sur 3,5 trillions de jetons.

Il s’agit de la plus longue période de pré-entraînement d’un seul épochage pour un modèle open source à ce jour. Pour atteindre de telles marques, 4 096 GPU ont été utilisés simultanément pendant environ 7 millions d’heures de GPU, en utilisant Amazon SageMaker pour l’entraînement et l’affinage.

Pour mettre en perspective la taille du Falcon 180B, ses paramètres sont 2,5 fois plus grands que le modèle LLaMA 2 de Meta. LLaMA 2 était auparavant considéré comme le LLM open-source le plus performant après son lancement en début d’année, avec 70 milliards de paramètres entraînés sur 2 billions de jetons.

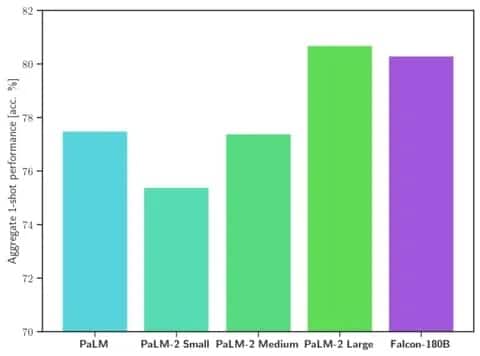

Falcon 180B surpasse LLaMA 2 et d’autres modèles à la fois en termes d’échelle et de performances dans toute une série de tâches de traitement du langage naturel (NLP). Il se classe au premier rang des modèles en libre accès avec 68,74 points et atteint une quasi-parité avec les modèles commerciaux tels que le PaLM-2 de Google sur des évaluations telles que le benchmark HellaSwag.

Image : Hugging Face

Spécifiquement, le Falcon 180B égale ou dépasse le PaLM-2 Medium sur des critères de référence couramment utilisés, notamment HellaSwag, LAMBADA, WebQuestions, Winogrande, et bien d’autres encore. Il est pratiquement au même niveau que le PaLM-2 Large de Google. Cela représente une performance extrêmement forte pour un modèle open-source, même lorsqu’il est comparé à des solutions développées par des géants de l’industrie.

Par rapport à ChatGPT, le modèle est plus puissant que la version gratuite, mais un peu moins performant que le service payant « plus ».

« Falcon 180B se situe généralement entre GPT 3.5 et GPT4 en fonction du benchmark d’évaluation, et il sera très intéressant de suivre les améliorations apportées par la communauté maintenant qu’il est ouvertement disponible », peut-on lire sur le blog.

La sortie du Falcon 180B représente la dernière avancée dans les progrès rapides qui ont été réalisés récemment avec les LLM. Au-delà de la simple mise à l’échelle des paramètres, des techniques telles que LoRA, la randomisation des poids et Perfusion de Nvidia ont permis d’améliorer considérablement l’efficacité de l’entraînement des grands modèles d’IA.

Le modèle Falcon 180B étant désormais disponible gratuitement sur Hugging Face, les chercheurs s’attendent à ce qu’il bénéficie d’améliorations supplémentaires développées par la communauté. Cependant, la démonstration de capacités avancées de langage naturel dès le départ marque un développement passionnant pour l’IA open-source.