De kunstmatige intelligentie gemeenschap heeft een nieuwe veer op haar hoed met de release van Falcon 180B, een open-source groot taalmodel (LLM) met 180 miljard parameters getraind op een berg data. Deze krachtige nieuwkomer heeft eerdere open-source LLM’s op verschillende fronten overtroffen.

Aangekondigd in een blog post door de Hugging Face AI gemeenschap, is Falcon 180B vrijgegeven op Hugging Face Hub. De nieuwste modelarchitectuur bouwt voort op de vorige Falcon-serie van open-source LLM’s en maakt gebruik van innovaties zoals multiquery-aandacht om op te schalen tot 180 miljard parameters getraind op 3,5 biljoen tokens.

Dit is de langste single-epoch pretraining voor een open source model tot nu toe. Om dit te bereiken werden 4.096 GPU’s tegelijkertijd gebruikt voor ongeveer 7 miljoen GPU-uren, waarbij Amazon SageMaker werd gebruikt voor training en verfijning.

Om de grootte van Falcon 180B in perspectief te plaatsen: de parameters zijn 2,5 keer groter dan het LLaMA 2-model van Meta. LLaMA 2 werd eerder beschouwd als de meest capabele open-source LLM na de lancering eerder dit jaar, met 70 miljard parameters getraind op 2 biljoen tokens.

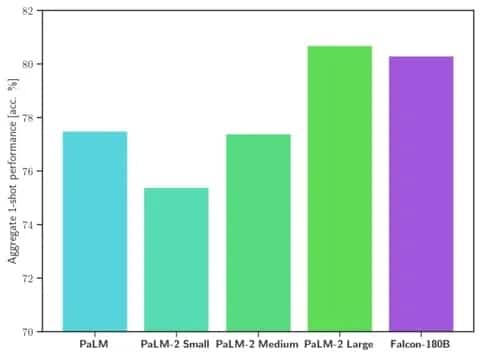

Falcon 180B overtreft LLaMA 2 en andere modellen in zowel schaal als benchmarkprestaties in een reeks van natuurlijke taalverwerkingstaken (NLP). Het staat op de ranglijst voor open access modellen met 68,74 punten en komt dicht in de buurt van commerciële modellen zoals Google’s PaLM-2 op evaluaties zoals de HellaSwag benchmark.

Afbeelding: Hugging Face

Specifiek, Falcon 180B evenaart of overtreft PaLM-2 Medium op veelgebruikte benchmarks, inclusief HellaSwag, LAMBADA, WebQuestions, Winogrande en meer. De prestaties zijn in principe vergelijkbaar met die van Google’s PaLM-2 Large. Dit betekent extreem sterke prestaties voor een open-source model, zelfs wanneer het wordt vergeleken met oplossingen die zijn ontwikkeld door giganten in de industrie.

In vergelijking met ChatGPT is het model krachtiger dan de gratis versie, maar iets minder capabel dan de betaalde “plus”-dienst.

“Falcon 180B zit ergens tussen GPT 3.5 en GPT4, afhankelijk van de evaluatie benchmark, en verdere finetuning door de community zal zeer interessant zijn om te volgen nu het openlijk is vrijgegeven”, aldus de blog.

De vrijgave van Falcon 180B vertegenwoordigt de laatste sprong voorwaarts in de snelle vooruitgang die recentelijk is geboekt met LLM’s. Naast het opschalen van parameters, hebben technieken zoals LoRA’s, gewicht randomisatie en Nvidia’s Perfusion het mogelijk gemaakt om grote AI modellen veel efficiënter te trainen.

Nu Falcon 180B vrij beschikbaar is op Hugging Face, verwachten onderzoekers dat het model nog meer vooruitgang zal boeken met verdere verbeteringen die door de community zijn ontwikkeld. De demonstratie van geavanceerde natuurlijke taalcapaciteiten direct vanaf het begin markeert echter een opwindende ontwikkeling voor open-source AI.