A inteligência artificial (IA) tem um enorme potencial para acelerar os avanços na saúde e na medicina, mas também acarreta riscos se não for aplicada com cuidado, como evidenciado pelos resultados duplos de estudos recentes sobre o tratamento do cancro.

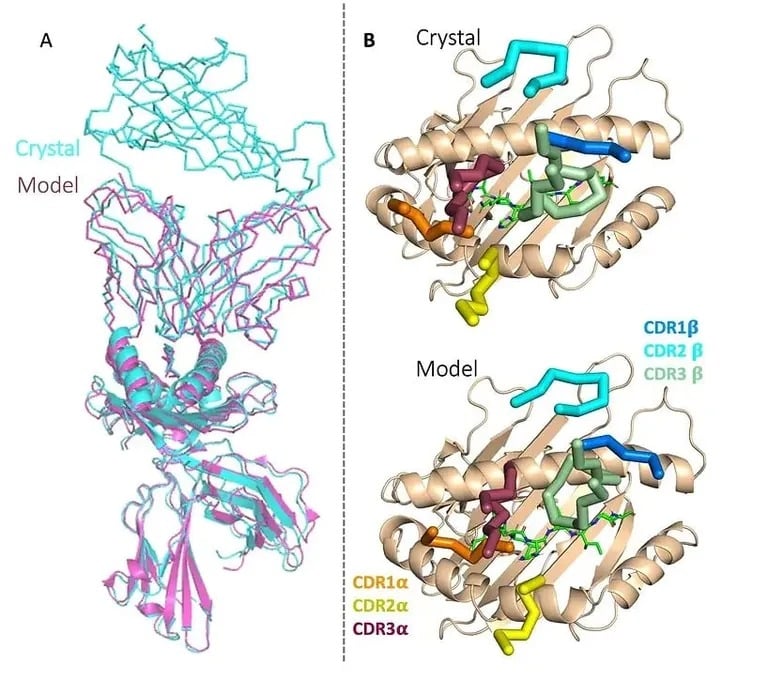

Por um lado, a Etcembly, uma empresa de biotecnologia sediada no Reino Unido, acaba de anunciar que conseguiu utilizar a IA generativa para conceber uma nova imunoterapia que visa cancros difíceis de tratar. Esta é a primeira vez que um candidato a imunoterapia foi desenvolvido com recurso à IA e a Etcembly – que é membro do programa Inception da Nvidia – conseguiu criá-lo em apenas 11 meses, ou seja, duas vezes mais rápido do que os métodos convencionais.

A nova terapêutica da Etcembly, designada por ETC-101, é um engager de células T biespecífico, o que significa que tem como alvo uma proteína que se encontra em muitos cancros e não em tecidos saudáveis. Demonstra também uma afinidade picomolar, sendo assim até um milhão de vezes mais potente do que os receptores naturais de células T.

A empresa diz que também tem uma linha robusta de outras imunoterapias para o cancro e doenças auto-imunes concebidas pelo seu motor de IA, chamado EMLy.

Imagem: Etcembly

“A Etcembly nasceu do nosso desejo de reunir dois conceitos que estão à frente do mainstream científico – os TCR e a IA generativa – para conceber a próxima geração de imunoterapias”, afirmou a CEO Michelle Teng. “Estou entusiasmada por levar esses ativos adiante para que possamos tornar o futuro da terapêutica TCR uma realidade e trazer tratamentos transformadores para os pacientes.

Anteriormente, os investigadores mostraram que a IA podia ajudar a prever os resultados de tratamentos experimentais contra o cancro, melhorar as técnicas de rastreio do cancro, descobrir novos medicamentos senolíticos, detetar sinais da doença de Parkinson e compreender as interacções entre proteínas para conceber novos compostos.

Perigos da utilização de uma IA não validada

Por outro lado, subsistem riscos significativos. Alguns indivíduos estão a começar a utilizar chatbots de IA em vez de médicos e terapeutas, tendo uma pessoa chegado a suicidar-se depois de seguir os conselhos prejudiciais de um chatbot.

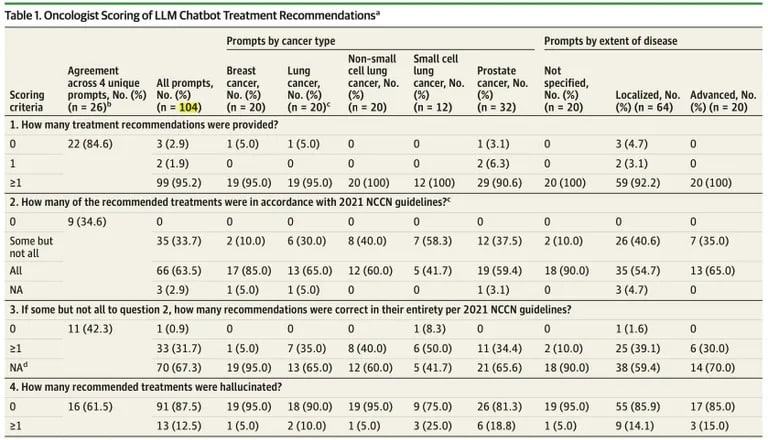

Os cientistas também estão a alinhar-se com a ideia de que as pessoas não devem seguir cegamente os conselhos da IA. Um novo estudo publicado pela JAMA Oncology sugere que o ChatGPT tem limitações críticas ao gerar planos de tratamento do cancro, sublinhando os riscos se as recomendações da IA forem implementadas clinicamente sem uma validação extensiva.

Os investigadores do Brigham and Women’s Hospital, em Boston, descobriram que as recomendações de tratamento do ChatGPT para vários casos de cancro continham muitos erros factuais e informações contraditórias.

De 104 consultas, cerca de um terço das respostas do ChatGPT continham detalhes incorrectos, de acordo com o estudo publicado no JAMA Oncology.

“Todos os resultados com uma recomendação incluíam pelo menos um tratamento compatível com o NCCN, mas 35 de 102 (34,3%) desses resultados também recomendavam um ou mais tratamentos não compatíveis”, constatou o estudo.

Source: JAMA Oncology

Embora 98% dos planos incluíssem algumas directrizes correctas, quase todos misturavam conteúdos certos e errados.

“Ficámos impressionados com o grau em que a informação incorrecta foi misturada com factos exactos, tornando os erros difíceis de identificar – mesmo para os especialistas”, disse a coautora, Dra. Danielle Bitterman.

Especificamente, o estudo descobriu que 12,5% das recomendações de tratamento do ChatGPT foram completamente alucinadas ou fabricadas pelo bot sem nenhuma precisão factual. A IA enfrentou problemas específicos para gerar terapias localizadas confiáveis para cânceres avançados e uso apropriado de medicamentos de imunoterapia.

A própria OpenAI adverte que o ChatGPT não se destina a fornecer aconselhamento médico ou serviços de diagnóstico para condições de saúde graves. Mesmo assim, a tendência do modelo para responder com confiança a informações contraditórias ou falsas aumenta os riscos se for utilizado clinicamente sem uma validação rigorosa.

É óbvio que não se deve comer veneno de formiga, mesmo que a IA do supermercado o aconselhe a fazê-lo, mas quando se trata de termos académicos complexos e de conselhos delicados, também se deve falar com um ser humano.

Com uma validação cuidadosa, as ferramentas alimentadas por IA poderiam rapidamente desbloquear novos tratamentos que salvam vidas, evitando erros perigosos. Mas, por enquanto, é aconselhável que os pacientes vejam os conselhos médicos gerados por IA com uma dose saudável de ceticismo.