L’intelligence artificielle (IA) recèle un énorme potentiel pour accélérer les progrès dans les domaines de la santé et de la médecine, mais elle comporte également des risques si elle n’est pas appliquée avec précaution, comme en témoignent les résultats contradictoires d’études récentes sur le traitement du cancer.

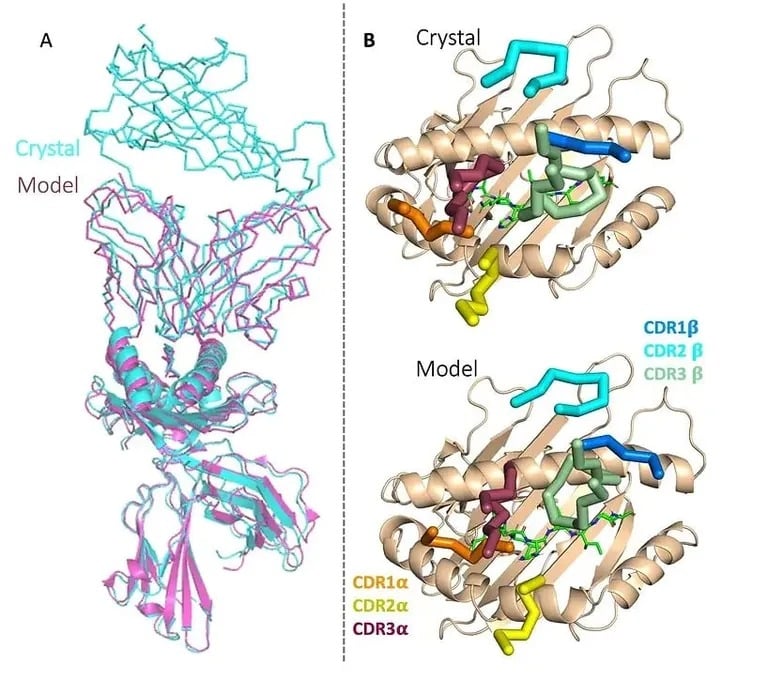

D’une part, la société de biotechnologie Etcembly, basée au Royaume-Uni, vient d’annoncer qu’elle a pu utiliser l’IA générative pour concevoir une nouvelle immunothérapie ciblant les cancers difficiles à traiter. C’est la première fois qu’un candidat à l’immunothérapie est développé à l’aide de l’IA, et Etcembly – qui est membre du programme Inception de Nvidia – a pu le créer en seulement 11 mois, soit deux fois plus vite qu’avec les méthodes conventionnelles.

La nouvelle thérapie d’Etcembly, appelée ETC-101, est un activateur bispécifique de cellules T, ce qui signifie qu’elle cible une protéine présente dans de nombreux cancers et non dans les tissus sains. Il présente également une affinité picomolaire et est donc jusqu’à un million de fois plus puissant que les récepteurs de cellules T naturels.

La société affirme qu’elle dispose également d’un solide pipeline d’autres immunothérapies pour le cancer et les maladies auto-immunes conçues par son moteur d’IA, appelé EMLy.

Image : Etcembly

« Etcembly est née de notre volonté de réunir deux concepts en avance sur le courant scientifique – les TCR et l’IA générative – pour concevoir la prochaine génération d’immunothérapies », a déclaré Michelle Teng, PDG. Je suis enthousiaste à l’idée de faire progresser ces atouts afin que nous puissions faire de l’avenir des thérapies TCR une réalité et apporter des traitements transformateurs aux patients ».

Auparavant, les chercheurs ont montré que l’IA pouvait aider à prédire les résultats de traitements expérimentaux contre le cancer, à améliorer les techniques de dépistage du cancer, à découvrir de nouveaux médicaments sénolytiques, à détecter les signes de la maladie de Parkinson et à comprendre les interactions entre protéines pour concevoir de nouveaux composés.

Dangers du déploiement d’une IA non validée

D’un autre côté, des risques importants subsistent. Certaines personnes commencent à utiliser des chatbots d’IA au lieu de médecins et de thérapeutes, et une personne s’est même suicidée après avoir suivi les conseils néfastes d’un chatbot.

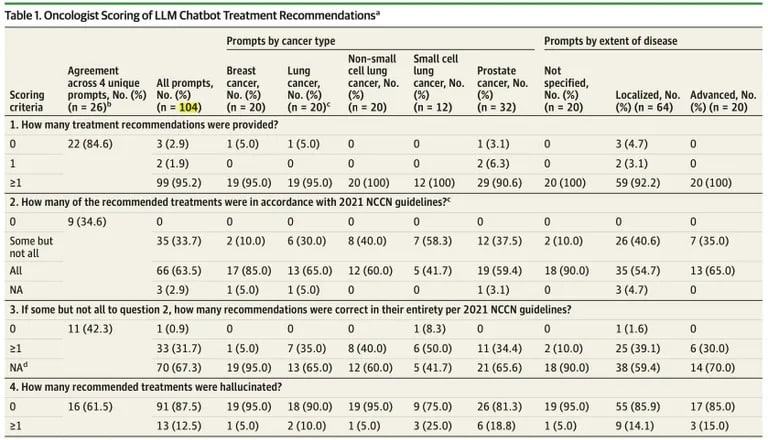

Les scientifiques s’alignent également sur l’idée que les gens ne devraient pas suivre aveuglément les conseils de l’IA. Une nouvelle étude publiée par JAMA Oncology suggère que ChatGPT a des limites critiques lorsqu’il génère des plans de traitement du cancer, soulignant les risques si les recommandations de l’IA sont déployées cliniquement sans validation approfondie.

Les chercheurs du Brigham and Women’s Hospital de Boston ont constaté que les recommandations de traitement de ChatGPT pour divers cas de cancer contenaient de nombreuses erreurs factuelles et des informations contradictoires.

Sur 104 requêtes, environ un tiers des réponses de ChatGPT contenaient des détails incorrects, selon l’étude publiée dans JAMA Oncology.

« Tous les résultats assortis d’une recommandation comprenaient au moins un traitement concordant avec le NCCN, mais 35 des 102 (34,3 %) de ces résultats recommandaient également un ou plusieurs traitements non concordants », selon l’étude.

Source : JAMA Oncology

Bien que 98 % des plans aient inclus certaines directives précises, presque tous ont mélangé des contenus corrects et incorrects.

« Nous avons été frappés par la mesure dans laquelle des informations incorrectes étaient mélangées à des faits exacts, ce qui rendait les erreurs difficiles à identifier, même pour les spécialistes », a déclaré le Dr Danielle Bitterman, coauteur de l’étude.

Plus précisément, l’étude a révélé que 12,5 % des recommandations de traitement de ChatGPT étaient complètement hallucinées ou fabriquées par le robot, sans aucune précision factuelle. L’IA a éprouvé des difficultés particulières à générer des thérapies localisées fiables pour les cancers avancés et à utiliser de manière appropriée les médicaments d’immunothérapie.

L’OpenAI elle-même avertit que ChatGPT n’est pas censé fournir des conseils médicaux ou des services de diagnostic pour des problèmes de santé graves. Malgré cela, la tendance du modèle à répondre avec assurance à des informations contradictoires ou fausses accroît les risques s’il est déployé cliniquement sans validation rigoureuse.

Manger du poison pour fourmis est évidemment à proscrire, même si l’IA de votre supermarché vous le conseille, mais lorsqu’il s’agit de termes académiques complexes et de conseils délicats, il est préférable de s’adresser à un humain.

Avec une validation minutieuse, les outils alimentés par l’IA pourraient rapidement débloquer de nouveaux traitements vitaux tout en évitant les faux pas dangereux. Mais pour l’instant, les patients ont tout intérêt à considérer les conseils médicaux générés par l’IA avec une bonne dose de scepticisme.