L’intelligenza artificiale (AI) ha un enorme potenziale per accelerare i progressi nel campo della salute e della medicina, ma comporta anche dei rischi se non viene applicata con attenzione, come dimostrano i risultati contrastanti di recenti studi sul trattamento del cancro.

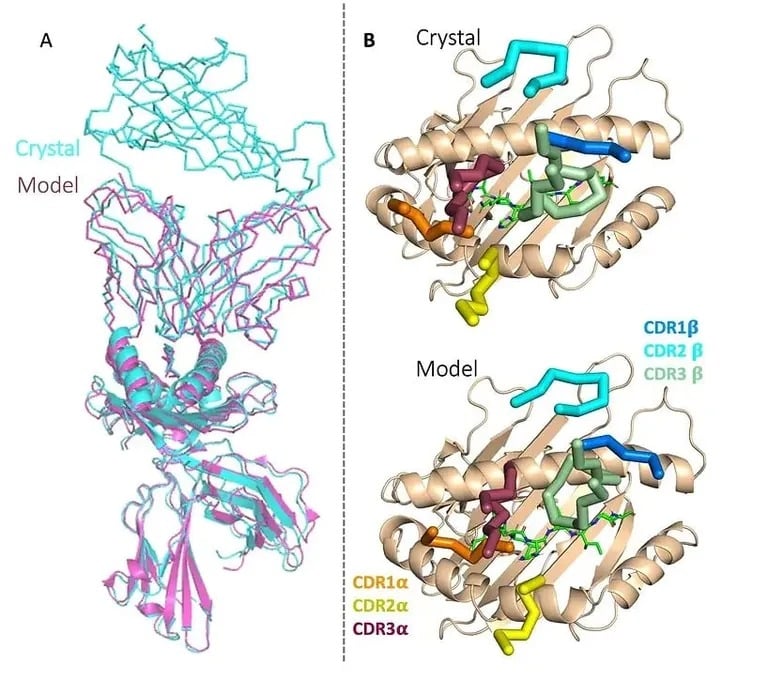

Da un lato, la startup biotecnologica Etcembly, con sede nel Regno Unito, ha appena annunciato di essere riuscita a utilizzare l’IA generativa per progettare un’immunoterapia innovativa che colpisce i tumori difficili da trattare. È la prima volta che un candidato all’immunoterapia viene sviluppato utilizzando l’intelligenza artificiale ed Etcembly, che fa parte del programma Inception di Nvidia, è stata in grado di crearlo in soli 11 mesi, ovvero due volte più velocemente rispetto ai metodi convenzionali.

La nuova terapia di Etcembly, denominata ETC-101, è un ingaggiatore bispecifico di cellule T, il che significa che ha come bersaglio una proteina presente in molti tumori e non nei tessuti sani. Inoltre, dimostra un’affinità picomolare e quindi è fino a un milione di volte più potente dei recettori naturali per le cellule T. L’azienda afferma che il farmaco ha anche una solida capacità di aggancio.

L’azienda afferma di avere anche una robusta pipeline di altre immunoterapie per il cancro e le malattie autoimmuni, progettate dal suo motore AI, chiamato EMLy.

Immagine: Etcembly

“Etcembly è nata dal nostro desiderio di unire due concetti che sono in anticipo rispetto al mainstream scientifico – iCR e l’IA generativa – per progettare la prossima generazione di immunoterapie”, ha dichiarato l’amministratore delegato Michelle Teng. Sono entusiasta di portare avanti queste risorse in modo da poter realizzare il futuro dei terapici TCR e portare trattamenti trasformativi ai pazienti”.

In precedenza, i ricercatori hanno dimostrato che l’intelligenza artificiale può aiutare a prevedere gli esiti dei trattamenti sperimentali contro il cancro, a migliorare le tecniche di screening dei tumori, a scoprire nuovi farmaci senolitici, a rilevare i segnali del morbo di Parkinson e a comprendere le interazioni tra le proteine per progettare nuovi composti.

I pericoli dell’impiego di un’intelligenza artificiale non validata

D’altro canto, permangono rischi significativi. Alcuni individui stanno iniziando a utilizzare chatbot di IA al posto di medici e terapeuti; una persona si è addirittura uccisa dopo aver seguito i consigli dannosi di un chatbot.

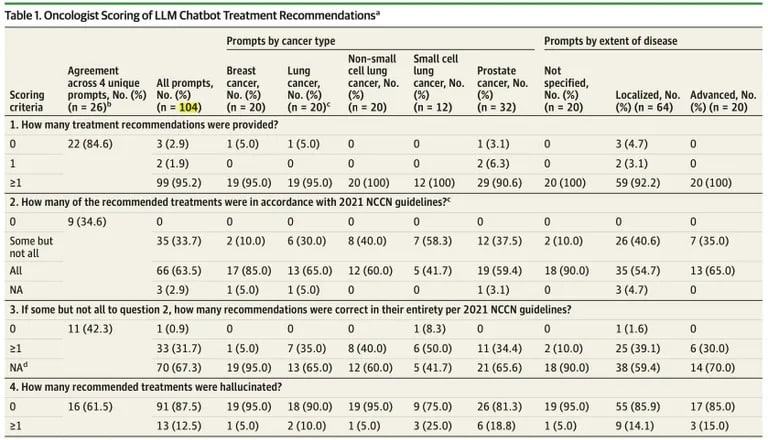

Anche gli scienziati si stanno allineando all’idea che le persone non dovrebbero seguire ciecamente i consigli dell’IA. Un nuovo studio pubblicato da JAMA Oncology suggerisce che ChatGPT presenta limiti critici nella generazione di piani di trattamento del cancro, sottolineando i rischi che si corrono se le raccomandazioni dell’IA vengono impiegate clinicamente senza un’ampia validazione.

I ricercatori del Brigham and Women’s Hospital di Boston hanno scoperto che le raccomandazioni terapeutiche di ChatGPT per vari casi di cancro contenevano molti errori di fatto e informazioni contraddittorie.

Su 104 richieste, circa un terzo delle risposte di ChatGPT conteneva dettagli errati, secondo lo studio pubblicato su JAMA Oncology.

“Tutti i risultati con una raccomandazione includevano almeno un trattamento concordante con l’NCCN, ma 35 su 102 (34,3%) di questi risultati raccomandavano anche uno o più trattamenti non concordanti”, ha rilevato lo studio.

Fonte: JAMA Oncology

Sebbene il 98% dei piani includesse alcune linee guida accurate, quasi tutti mescolavano contenuti giusti e sbagliati.

“Siamo rimasti colpiti dal grado di mescolanza tra informazioni errate e fatti accurati, che rende gli errori difficili da identificare, anche per gli specialisti”, ha dichiarato la coautrice Danielle Bitterman.

In particolare, lo studio ha rilevato che il 12,5% delle raccomandazioni terapeutiche di ChatGPT erano completamente allucinate o inventate dal bot, senza alcuna accuratezza fattuale. L’intelligenza artificiale ha incontrato particolari difficoltà nel generare terapie localizzate affidabili per i tumori avanzati e nell’uso appropriato di farmaci immunoterapici.

OpenAI stessa avverte che ChatGPT non è destinato a fornire consigli medici o servizi diagnostici per gravi condizioni di salute. Tuttavia, la tendenza del modello a rispondere con sicurezza a informazioni contraddittorie o false aumenta i rischi se utilizzato clinicamente senza una rigorosa convalida.

Mangiare veleno per formiche è ovviamente da evitare anche se l’IA del supermercato lo consiglia, ma quando si tratta di termini accademici complessi e di consigli delicati, è meglio rivolgersi a un umano.

Con un’attenta validazione, gli strumenti basati sull’IA potrebbero rapidamente sbloccare nuovi trattamenti salvavita, evitando pericolosi passi falsi. Ma per il momento, i pazienti fanno bene a considerare i consigli medici generati dalle IA con una sana dose di scetticismo.