Sztuczna inteligencja (AI) ma ogromny potencjał do przyspieszenia postępów w dziedzinie zdrowia i medycyny, ale wiąże się również z ryzykiem, jeśli nie jest stosowana ostrożnie, o czym świadczą sprzeczne wyniki ostatnich badań nad leczeniem raka.

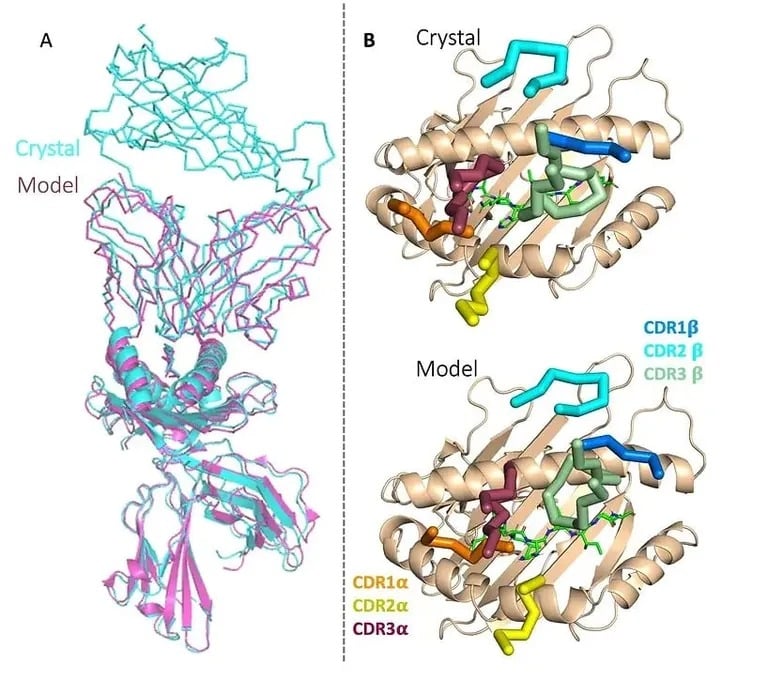

Z jednej strony, brytyjski startup biotechnologiczny Etcembly ogłosił właśnie, że był w stanie wykorzystać generatywną sztuczną inteligencję do zaprojektowania nowej immunoterapii, która jest ukierunkowana na trudne do leczenia nowotwory. Jest to pierwszy przypadek, gdy kandydat na immunoterapię został opracowany przy użyciu sztucznej inteligencji, a Etcembly – który jest członkiem programu Inception firmy Nvidia – był w stanie stworzyć go w zaledwie 11 miesięcy, czyli dwa razy szybciej niż konwencjonalnymi metodami.

Nowa terapia Etcembly, zwana ETC-101, jest bispecyficznym inhibitorem limfocytów T, co oznacza, że celuje w białko występujące w wielu nowotworach, a nie w zdrowej tkance. Wykazuje również pikomolarne powinowactwo, a zatem jest do miliona razy silniejszy niż naturalne receptory komórek T.

Firma twierdzi, że ma również solidny pipeline innych immunoterapii raka i chorób autoimmunologicznych zaprojektowanych przez jej silnik AI, zwany EMLy.

Image: Etcembly

„Etcembly narodziło się z naszego pragnienia połączenia dwóch koncepcji, które wyprzedzają główny nurt naukowy – TCR i generatywnej sztucznej inteligencji – w celu zaprojektowania nowej generacji immunoterapii” – powiedziała CEO Michelle Teng. „Cieszę się, że możemy wykorzystać te zasoby, aby urzeczywistnić przyszłość terapii TCR i zapewnić pacjentom przełomowe metody leczenia”.

Wcześniej naukowcy wykazali, że sztuczna inteligencja może pomóc w przewidywaniu wyników eksperymentalnego leczenia raka, ulepszaniu technik badań przesiewowych w kierunku raka, odkrywaniu nowych leków senolitycznych, wykrywaniu objawów choroby Parkinsona i zrozumieniu interakcji białek w celu projektowania nowych związków.

Zagrożenia związane z wdrożeniem niezwalidowanej sztucznej inteligencji

Z drugiej strony, nadal istnieje znaczące ryzyko. Niektóre osoby zaczynają korzystać z chatbotów AI zamiast lekarzy i terapeutów, a jedna osoba nawet zabiła się po zastosowaniu się do szkodliwej porady chatbota.

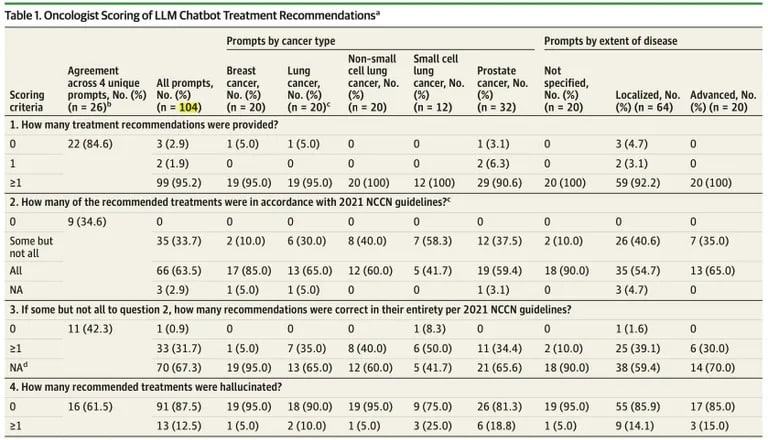

Naukowcy również zgadzają się z ideą, że ludzie nie powinni ślepo podążać za radami AI. Nowe badanie opublikowane przez JAMA Oncology sugeruje, że ChatGPT ma krytyczne ograniczenia podczas generowania planów leczenia raka, podkreślając ryzyko, jeśli zalecenia AI zostaną wdrożone klinicznie bez szeroko zakrojonej walidacji.

Naukowcy z Brigham and Women’s Hospital w Bostonie odkryli, że zalecenia ChatGPT dotyczące leczenia różnych przypadków raka zawierały wiele błędów merytorycznych i sprzecznych informacji.

Z 104 zapytań, około jedna trzecia odpowiedzi ChatGPT zawierała nieprawidłowe szczegóły, zgodnie z badaniem opublikowanym w JAMA Oncology.

„Wszystkie wyniki z zaleceniami zawierały co najmniej 1 leczenie zgodne z NCCN, ale 35 ze 102 (34,3%) tych wyników zalecało również 1 lub więcej niezgodnych terapii” – stwierdzono w badaniu.

Źródło: JAMA Oncology

Chociaż 98% planów zawierało pewne dokładne wytyczne, prawie wszystkie mieszały prawidłowe i nieprawidłowe treści.

„Uderzył nas stopień, w jakim nieprawidłowe informacje mieszały się z dokładnymi faktami, przez co błędy były trudne do zidentyfikowania – nawet dla specjalistów” – powiedziała współautorka dr Danielle Bitterman.

W szczególności badanie wykazało, że 12,5% zaleceń dotyczących leczenia ChatGPT było całkowicie halucynowanych lub sfabrykowanych przez bota bez faktycznej dokładności. Sztuczna inteligencja miała szczególne trudności z generowaniem wiarygodnych zlokalizowanych terapii dla zaawansowanych nowotworów i odpowiednim stosowaniem leków immunoterapeutycznych.

Sama OpenAI ostrzega, że ChatGPT nie ma na celu udzielania porad medycznych ani usług diagnostycznych dotyczących poważnych schorzeń. Mimo to, tendencja modelu do pewnego reagowania na sprzeczne lub fałszywe informacje zwiększa ryzyko, jeśli zostanie zastosowany klinicznie bez rygorystycznej walidacji.

Zjedzenie trutki na mrówki jest oczywistym zakazem, nawet jeśli sztuczna inteligencja w supermarkecie ci to doradzi, ale jeśli chodzi o złożone terminy akademickie i delikatne porady, powinieneś również porozmawiać z człowiekiem.

Dzięki starannej walidacji narzędzia oparte na sztucznej inteligencji mogą szybko odblokować nowe metody leczenia ratujące życie, unikając jednocześnie niebezpiecznych błędów. Na razie jednak pacjenci powinni podchodzić do porad medycznych generowanych przez SI ze zdrową dozą sceptycyzmu.