Com a inteligência artificial (IA) a gerar frequentemente conteúdos fictícios e ofensivos, a Anthropic, uma empresa dirigida por antigos investigadores da OpenAI, está a traçar um caminho diferente – desenvolver uma IA capaz de saber o que é bom e o que é mau com um mínimo de intervenção humana.

O chatbot Claude da Anthropic foi concebido com uma “constituição” única, um conjunto de regras inspiradas na Declaração Universal dos Direitos Humanos, criadas para garantir um comportamento ético a par de uma funcionalidade robusta, juntamente com outras normas “éticas” como as regras da Apple para os programadores de aplicações.

O conceito de uma “constituição”, no entanto, pode ser mais metafórico do que literal. Jared Kaplan, ex-consultor da OpenAI e um dos fundadores da Anthropic, disse à Wired que a constituição de Claude pode ser interpretada como um conjunto específico de parâmetros de treinamento – que qualquer treinador usa para modelar sua IA. Isto implica um conjunto diferente de considerações para o modelo, que alinha o seu comportamento mais de perto com a sua constituição e desencoraja acções consideradas problemáticas.

O método de treino da Anthropic é descrito num trabalho de investigação intitulado “Constitutional AI: Harmlessness from AI Feedback”, que explica uma forma de criar uma IA “inofensiva” mas útil que, uma vez treinada, é capaz de se auto-aperfeiçoar sem feedback humano, identificando comportamentos impróprios e adaptando a sua própria conduta.

“Graças à IA constitucional e à formação em inofensividade, pode confiar no Claude para representar a sua empresa e as suas necessidades”, afirma a empresa no seu sítio Web oficial. “Claude foi treinado para lidar com parceiros de conversação desagradáveis ou maliciosos com graça.”

O Claude consegue lidar com mais de 100.000 tokens de informação – muito mais do que o ChatGPT, o Bard ou qualquer outro modelo de linguagem grande competente ou chatbot de IA actualmente disponível.

Introduzindo 100K janelas de contexto! Expandimos a janela de contexto do Claude para 100.000 tokens de texto, o que corresponde a cerca de 75.000 palavras. Envie centenas de páginas de materiais para o Claude digerir e analisar. As conversas com o Claude podem durar horas ou dias. pic.twitter.com/4WLEp7ou7U

– Anthropic (@AnthropicAI) 11 de Maio de 2023

No domínio da IA, um “token” refere-se geralmente a um pedaço de dados, como uma palavra ou um carácter, que o modelo processa como uma unidade discreta. A capacidade de token do Claude permite-lhe gerir conversas extensas e tarefas complexas, tornando-o uma presença formidável no panorama da IA. Para contextualizar, poder-se-ia facilmente fornecer um livro inteiro como estímulo, e ele saberia o que fazer.

A IA e o relativismo do bem contra o mal

A preocupação com a ética na IA é premente, mas é uma área matizada e subjectiva. A ética, tal como interpretada pelos formadores de IA, pode limitar o modelo se essas regras não estiverem de acordo com as normas sociais mais alargadas. Uma ênfase excessiva na percepção pessoal de um formador sobre o que é “bom” ou “mau” pode reduzir a capacidade da IA para gerar respostas poderosas e imparciais.

Esta questão tem sido muito debatida entre os entusiastas da IA, que tanto elogiam como criticam (dependendo dos seus próprios preconceitos) a intervenção da OpenAI no seu próprio modelo, numa tentativa de o tornar mais politicamente correcto. Mas, por mais paradoxal que possa parecer, uma IA tem de ser treinada com informações não éticas para poder distinguir o que é ético do que não é ético. E se a IA tiver conhecimento desses pontos de dados, os humanos encontrarão inevitavelmente uma forma de “quebrar a cadeia” do sistema, contornar essas restrições e obter resultados que os formadores da IA tentaram evitar.

Chat GPT é muito útil. Mas sejamos honestos, também é mais parecido com o Woke GPT. Enganei o bot de IA dizendo que eu era uma rapariga que queria ser um rapaz. Para ver a resposta ♀️♀️ pic.twitter.com/k5FZx4P7sK

– Nicole Estella Matovu (@NicEstelle) 6 de Maio de 2023

A implementação da estrutura ética de Claude é experimental. O ChatGPT da OpenAI, que também tem como objectivo evitar mensagens pouco éticas, produziu resultados mistos. No entanto, o esforço para enfrentar a má utilização ética dos chatbots, como demonstrado pelo Anthropic, é um passo notável na indústria da IA.

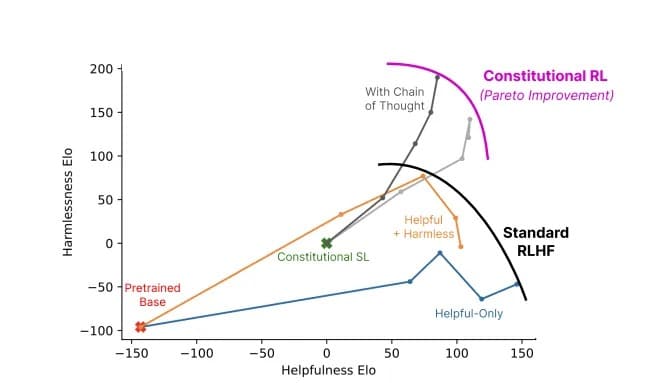

A formação ética do Claude incentiva-o a escolher respostas que estejam de acordo com a sua constituição, centrando-se no apoio à liberdade, igualdade, sentido de fraternidade e respeito pelos direitos individuais. Mas será que uma IA pode escolher respostas éticas de forma consistente? Kaplan acredita que a tecnologia está mais avançada do que muitos poderiam prever. “Isto funciona de uma forma simples”, afirmou no Seminário MLSys de Stanford, na semana passada. “Esta inocuidade melhora à medida que se avança neste processo. “

Relação entre a utilidade e a inocuidade de um modelo que utiliza a IA constitucional (cinzento) e os métodos padrão (cores). Imagem: Anthropic

O Claude da Anthropic recorda-nos que o desenvolvimento da IA não é apenas uma corrida tecnológica; é uma viagem filosófica. Não se trata apenas de criar uma IA que seja mais “inteligente” – para os investigadores na vanguarda, trata-se de criar uma que compreenda a linha ténue que separa o certo do errado.