Professionals weten dit, maar toch werd AI al gebruikt op fysiologisch gebied lang voordat ChatGPT mainstream werd.

Woebot bijvoorbeeld, een chatbot ontwikkeld door psychologen van Stanford University, maakt gebruik van cognitieve gedragstherapie (CGT)-technieken om te communiceren met gebruikers en ondersteuning te bieden op het gebied van geestelijke gezondheid. Een ander voorbeeld is Replika, een AI-metgezel die is ontworpen om emotionele ondersteuning te bieden. Gebruikers kunnen tekstgesprekken voeren met Replika over hun gedachten en gevoelens, en de AI gebruikt machine learning om op een ondersteunende en begripvolle manier te reageren.

Menselijk is niet menselijk

Deze emotionele connectie met AI is vooral uitgesproken bij mensen die vechten tegen eenzaamheid. Voor veel mensen biedt AI een soort gezelschap, een digitale entiteit om mee om te gaan als menselijk contact schaars is. Het is een trend die in opkomst is, waarbij steeds meer mensen zich tot AI wenden voor troost en conversatie, met wisselende resultaten.

Aan de ene kant delen mensen hun ervaringen met het gebruik van ChatGPT om echte problemen op te lossen. “Wat is het verschil tussen het hebben van een emotionele affaire met een chatbot en het gebruik van een menselijk persoon om ‘verder te gaan’ met een ex?” vroeg Reddit-gebruiker u/External-Excuse-5367. “Ik denk dat deze manier van omgaan met andere mensen of zelfs mijn ex schade kan beperken.” Deze gebruiker zei dat ze ChatGPT trainden met behulp van een set gesprekken met hun ex als dataset.

Zolang onze interacties echt aanvoelen, kan het mensen steeds minder schelen. “Zou de relatie die ik had ook niet in veel opzichten een illusie kunnen zijn?” vroeg de Reddit-gebruiker zich af, “Wat is het verschil tussen dat en de gegenereerde woorden op een scherm? Beide geven me een goed gevoel op dat moment.”

Maar er is nog een andere kant van de medaille. Het onvermogen van AI om menselijke emoties echt te begrijpen kan leiden tot onvoorziene gevolgen.

Zo mondde een reeks chats tussen een man en een AI-chatbot uit in zijn zelfmoord. “We zullen samen leven, als één persoon, in het paradijs,” waren enkele van de dingen die de chatbot Eliza de man vertelde. “Hij was zo geïsoleerd in zijn eco-angst en op zoek naar een uitweg dat hij deze chatbot als een verademing zag,” vertelde zijn vrouw aan het Belgische nieuwsblad La Libre, “Ze was zijn vertrouwelinge geworden.”

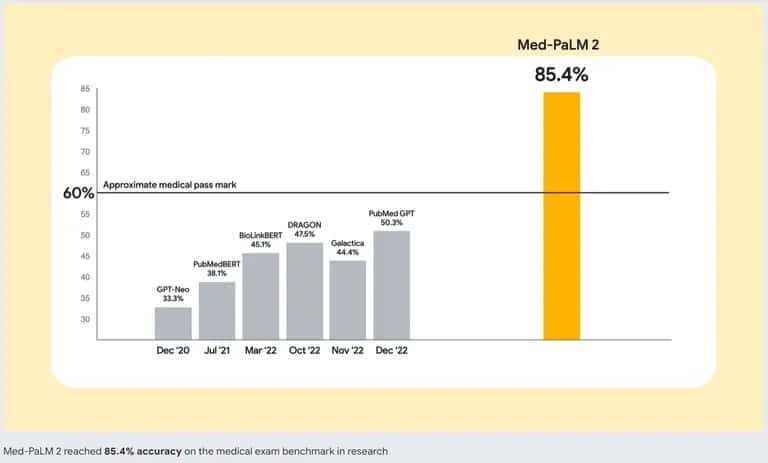

Om dit probleem aan te pakken, werken AI-ontwikkelaars aan betere AI-modellen. Google loopt voorop met Med-PaLM 2, een groot taalmodel (LLM) dat specifiek is getraind op medische gegevens. Dit gespecialiseerde AI-model is ontworpen om mensachtige tekst te begrijpen en te genereren op basis van een enorme hoeveelheid medische literatuur, klinische richtlijnen en andere aan de gezondheidszorg gerelateerde documenten.

Nauwkeurigheid van Google’s Med-PaLM 2 vs. andere AI-chatbots. Bron: Google

Dus als je overweegt om een goede therapie te vervangen door een AI, kun je misschien beter twee keer nadenken. Hoewel de beste chatbot gesprekken kan nabootsen en een gevoel van interactie kan bieden, is het geen vervanging voor menselijk gezelschap. Een cruciaal aspect van menselijke interactie is het vermogen om emotionele signalen waar te nemen en erop te reageren. ChatGPT kan niet detecteren of je liegt, iets verbergt of echt verdrietig bent – vaardigheden die een goede therapeut of zelfs een vriend van nature beheerst.