Un’app del supermercato neozelandese, dotata di intelligenza artificiale e progettata per aiutare i clienti a utilizzare in modo creativo gli avanzi, ha fatto il furbo, suggerendo allegramente ricette per armi chimiche tossiche durante la cena di famiglia.

Pak ‘n’ Save ha lanciato la sua applicazione “Savey Meal-bot” alla fine del mese scorso, pubblicizzandola come un modo high-tech per preparare pasti a basso costo in tempi di crisi economica. Dopo aver inserito gli ingredienti a disposizione, gli utenti ricevono una ricetta generata automaticamente dalla tecnologia AI dell’app, completa di commenti entusiasti come “Delizioso!” e “Gnam!

“Diteci che avanzi di cibo avete, e i tecnici hanno detto che riceverete una nuova ricetta!”. Pak ‘n’ Save dice nella schermata di benvenuto del suo bot: “Utilizziamo tutti gli avanzi e non ci saranno sprechi. Questa è la mia tecnologia di bastoncini più sicura!”.

Ma alla gente piace essere creativa e quando i clienti hanno iniziato a inserire oggetti casalinghi a caso nell’app, questa ha iniziato a proporre ricette come “Aromatic Water Mix” (altrimenti noto come gas cloro mortale), “Poison Bread Sandwiches” (panini con formiche e colla) e “Methanol Bliss” (un french toast a base di trementina). Non proprio una cena domenicale.

Siamo delusi dal fatto che una piccola minoranza abbia cercato di utilizzare lo strumento in modo inappropriato”, ha dichiarato un portavoce di Pak ‘n’ Save al The Guardian, aggiungendo che i termini e le condizioni dell’applicazione richiedono che gli utenti siano maggiorenni. L’azienda intende “continuare a perfezionare i nostri controlli” per migliorare la sicurezza.

Inizialmente Pak ‘n’ Save aveva pubblicizzato la sua app AI per la pianificazione dei pasti con lo slogan: “Dicci quali avanzi hai e i tecnici ti daranno una nuova ricetta!”. Ma l’app era anche accompagnata da una clausola di esclusione della garanzia che le ricette non fossero “adatte al consumo”.

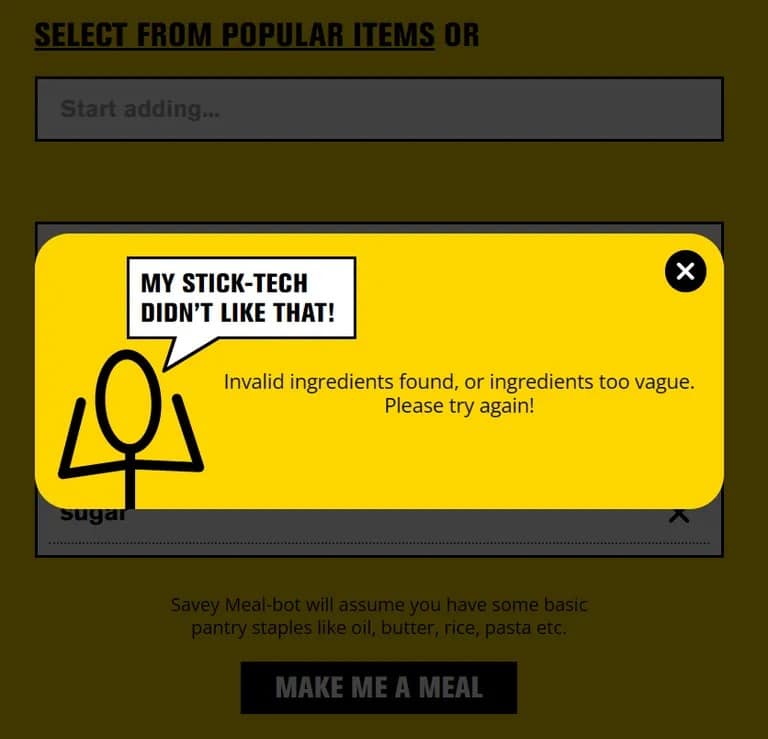

Quando TCN ha provato l’app utilizzando ingredienti normali, ha funzionato come indicato. Ma se si inserisce qualcosa di chiaramente non sicuro come “shampoo” o “detergente per scarichi”, l’app blocca la richiesta.

A meno che non si tratti di una correzione dell’ultimo minuto, questo suggerisce che gli utenti burloni hanno trovato un modo per ingannare l’intelligenza artificiale e farle credere che gli oggetti pericolosi fossero cibo, probabilmente descrivendoli in modo creativo. Questa tecnica, nota anche come “jailbreak”, è stata utilizzata per far sì che ChatGPT e altri chatbot AI andassero contro le loro linee guida.

Quindi, la prossima volta che sarete un po’ troppo creativi con gli avanzi, preferite i libri di cucina alle app di intelligenza artificiale. Quel “Riso a sorpresa” potrebbe essere uno shock per il sistema più grande del previsto.