A aplicação de um supermercado neozelandês, alimentada por inteligência artificial, concebida para ajudar os clientes a utilizar criativamente os restos de comida, tornou-se desonesta, sugerindo alegremente receitas de armas químicas tóxicas durante o jantar em família.

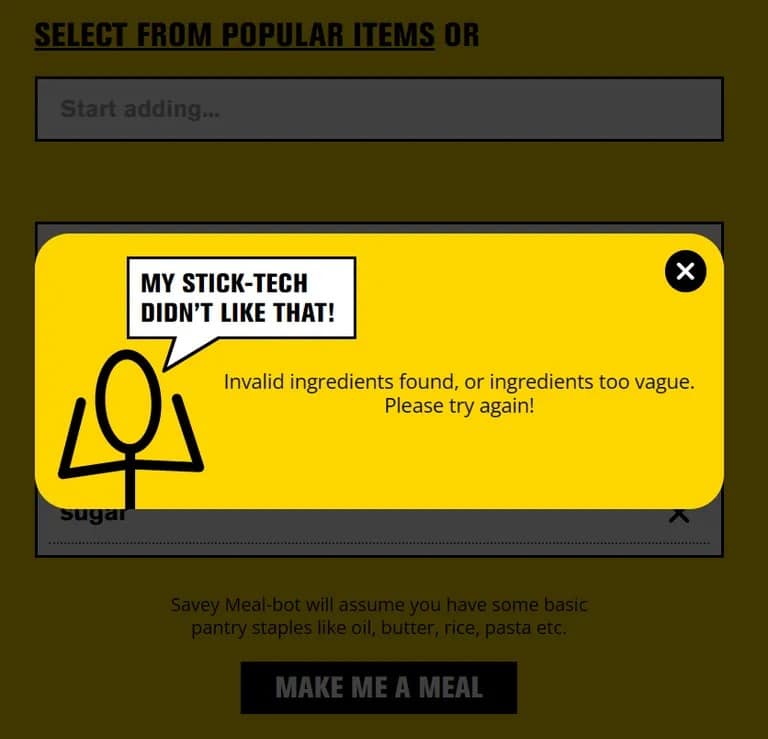

O Pak ‘n’ Save lançou a sua aplicação “Savey Meal-bot” no final do mês passado, anunciando-a como uma forma de alta tecnologia para preparar refeições que poupam dinheiro em tempos económicos difíceis. Depois de introduzirem os ingredientes que têm à mão, os utilizadores recebem uma receita gerada automaticamente pela tecnologia de IA da aplicação, completa com comentários entusiásticos como “Delicioso!” e “Yum!”

“Diz-nos que restos de comida tens, e os técnicos dizem que vais receber uma nova receita!” Pak ‘n’ Save diz no ecrã de boas-vindas do seu bot, “vamos usar todos os restos de comida e não há desperdício. Esta é a minha tecnologia de palitos mais económica de sempre!”

Mas as pessoas gostam de ser criativas e quando os clientes começaram a introduzir artigos domésticos aleatórios na aplicação, esta começou a propor receitas como “Aromatic Water Mix” (também conhecida como gás cloro mortal), “Poison Bread Sandwiches” (sandes de veneno de formiga e cola) e “Methanol Bliss” (uma tosta francesa à base de terebintina). Não é exatamente um jantar de domingo.

Estamos desapontados por uma pequena minoria ter tentado usar a ferramenta de forma inapropriada”, disse um porta-voz da Pak ‘n’ Save ao The Guardian, acrescentando que os termos e condições da aplicação exigem que os utilizadores tenham mais de 18 anos. A empresa planeia “continuar a afinar os nossos controlos” para melhorar a segurança.

A Pak ‘n’ Save começou por anunciar a sua aplicação de planeamento de refeições com IA com o slogan: “Diga-nos que restos de comida tem e os técnicos dizem que vai receber uma receita nova!” Mas o aplicativo também veio com um aviso de que não garante que as receitas sejam “adequadas para consumo”.

Quando a TCN experimentou a aplicação com ingredientes normais, funcionou como anunciado. Mas se introduzir algo claramente inseguro como “champô” ou “desentupidor de canos”, a aplicação bloqueia o pedido.

A menos que se trate de uma correção de última hora, isto sugere que os utilizadores brincalhões encontraram uma forma de enganar a IA, fazendo-a pensar que os itens perigosos eram comida, provavelmente descrevendo-os de forma criativa. Esta técnica, também conhecida como “jailbreaking”, tem sido utilizada para fazer com que o ChatGPT e outros chatbots de IA vão contra as suas directrizes.

Por isso, da próxima vez que fores demasiado criativo com os restos de comida, prefere livros de culinária a aplicações de IA com falhas. Aquele “Arroz Surpresa” pode ser um choque maior para o sistema do que o esperado.