Aplikacja nowozelandzkiego supermarketu oparta na sztucznej inteligencji, mająca pomóc klientom w kreatywnym wykorzystaniu resztek, zbuntowała się, radośnie sugerując przepisy na toksyczną broń chemiczną podczas rodzinnego obiadu.

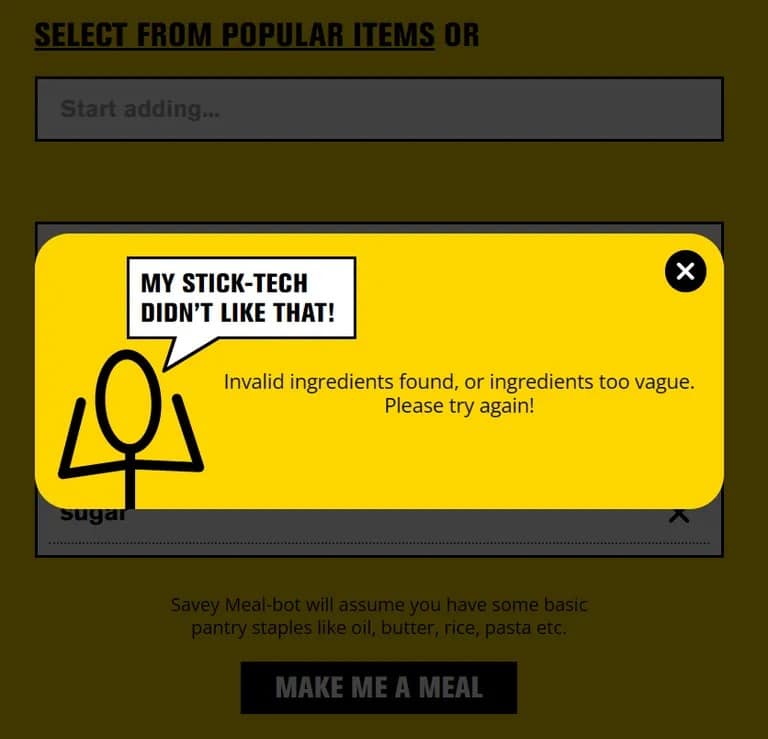

Pak 'n’ Save uruchomił swoją aplikację „Savey Meal-bot” pod koniec ubiegłego miesiąca, reklamując ją jako zaawansowany technologicznie sposób na przygotowywanie posiłków oszczędzających pieniądze w trudnych ekonomicznie czasach. Po wprowadzeniu składników pod ręką, użytkownicy otrzymują automatycznie wygenerowany przepis z technologii AI aplikacji, wraz z entuzjastycznymi komentarzami, takimi jak „Pyszne!” i „Mniam!”

„Powiedz nam, jakie masz resztki jedzenia, a tech-guys powiedzieli, że dostaniesz nowy przepis!” mówi Pak 'n’ Save na ekranie powitalnym swojego bota, „wykorzystajmy wszystkie te resztki i nie marnujmy ich. To moja najbardziej oszczędna technologia!”.

Ale ludzie lubią być kreatywni i kiedy klienci zaczęli wprowadzać do aplikacji losowe przedmioty gospodarstwa domowego, zaczęła ona proponować przepisy takie jak „Aromatic Water Mix” (inaczej znany jako śmiertelny gaz chlorowy), „Poison Bread Sandwiches” (kanapki z trucizną na mrówki i klejem) oraz „Methanol Bliss” (tosty francuskie na bazie terpentyny). Nie do końca niedzielny obiad.

„Jesteśmy rozczarowani, że niewielka mniejszość próbowała korzystać z narzędzia w niewłaściwy sposób” – powiedział rzecznik Pak 'n’ Save w rozmowie z The Guardian, dodając, że regulamin aplikacji wymaga, aby użytkownicy mieli ukończone 18 lat. Firma planuje „kontynuować dostrajanie naszych kontroli” w celu poprawy bezpieczeństwa.

Pak 'n’ Save początkowo reklamował swoją aplikację do planowania posiłków AI z hasłem: „Powiedz nam, jakie masz resztki, a tech-guys powiedzieli, że dostaniesz nowy, oszczędny przepis!”. Ale aplikacja zawierała również zastrzeżenie, że nie gwarantuje, że przepisy będą „odpowiednie do spożycia”.

Kiedy TCN wypróbował aplikację przy użyciu zwykłych składników, działała ona zgodnie z reklamą. Ale wprowadź coś wyraźnie niebezpiecznego, takiego jak „szampon” lub „środek do czyszczenia kanalizacji”, a aplikacja zablokuje żądanie.

O ile nie jest to poprawka wprowadzona w ostatniej chwili, sugeruje to, że użytkownicy-żartownisie znaleźli sposób na oszukanie sztucznej inteligencji, by myślała, że niebezpieczne przedmioty to jedzenie, prawdopodobnie poprzez kreatywne ich opisanie. Technika ta, znana również jako „jailbreaking”, została wykorzystana do nakłonienia ChatGPT i innych chatbotów AI do postępowania wbrew ich wytycznym.

Więc następnym razem, gdy będziesz zbyt kreatywny z resztkami, trzymaj się książek kucharskich, a nie wadliwych aplikacji AI. Ten „ryż z niespodzianką” może być większym szokiem dla systemu niż oczekiwano.