Una aplicación de inteligencia artificial de un supermercado neozelandés diseñada para ayudar a los clientes a utilizar las sobras de forma creativa se ha vuelto loca y sugiere alegremente recetas de armas químicas tóxicas durante la cena familiar.

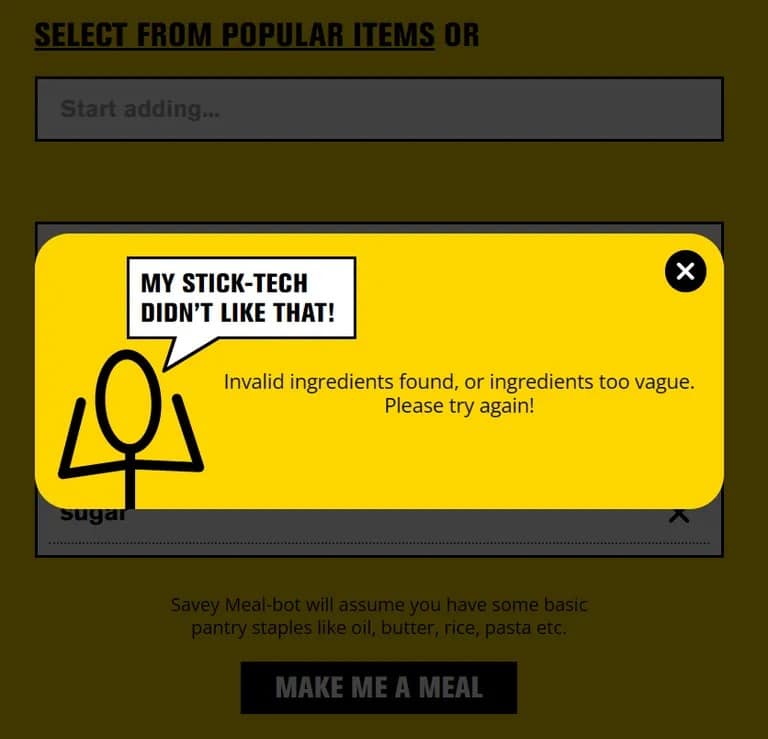

Pak ‘n’ Save lanzó su aplicación «Savey Meal-bot» a finales del mes pasado, anunciándola como una forma de alta tecnología para preparar comidas que ahorren dinero en tiempos de dificultades económicas. Tras introducir los ingredientes que tienen a mano, los usuarios reciben una receta generada automáticamente por la tecnología de inteligencia artificial de la aplicación, acompañada de comentarios entusiastas como «¡Delicioso!» y «¡Qué rico!

«Dinos qué comida te sobra y los técnicos te darán una receta nueva». dice Pak ‘n’ Save en la pantalla de bienvenida de su robot, «vamos a aprovechar todas esas sobras y no hay desperdicio. Esta es mi tecnología de palitos más sabrosa hasta la fecha».

Pero a la gente le gusta ser creativa y, cuando los clientes empezaron a introducir objetos domésticos al azar en la aplicación, ésta empezó a proponer recetas como «Aromatic Water Mix» (también conocido como gas cloro mortal), «Poison Bread Sandwiches» (sándwiches de veneno para hormigas y pegamento) y «Methanol Bliss» (una torrija a base de trementina). No es exactamente comida de domingo.

«Nos decepciona que una pequeña minoría haya intentado utilizar la herramienta de forma inapropiada», declaró un portavoz de Pak ‘n’ Save a The Guardian, añadiendo que los términos y condiciones de la aplicación exigen que los usuarios sean mayores de 18 años. La empresa tiene previsto «seguir afinando nuestros controles» para mejorar la seguridad.

Pak ‘n’ Save anunció inicialmente su aplicación de planificación de comidas con inteligencia artificial con el eslogan: «Dinos qué sobras tienes y los técnicos te darán una receta nueva y segura». Pero la aplicación también venía con una advertencia de que no garantiza que las recetas sean «aptas para el consumo».

Cuando TCN probó la aplicación con ingredientes normales, funcionó como se anunciaba. Pero si se introduce algo claramente inseguro, como «champú» o «desatascador», la aplicación bloquea la petición.

A menos que se trate de una solución de última hora, esto sugiere que los usuarios bromistas encontraron una forma de engañar a la IA para que pensara que los objetos peligrosos eran comida, probablemente describiéndolos de forma creativa. Esta técnica, también conocida como «jailbreaking», se ha utilizado para conseguir que ChatGPT y otros chatbots de IA vayan en contra de sus directrices.

Así que la próxima vez que te pongas demasiado creativo con las sobras, prefiere los libros de cocina a las aplicaciones de inteligencia artificial. Ese «Arroz Sorpresa» podría ser un shock para el sistema mayor de lo esperado.