Задвижваното от изкуствен интелект приложение на новозеландски супермаркет, предназначено да помага на клиентите да използват креативно остатъците от храна, е излязло навън и весело предлага рецепти за токсични химически оръжия по време на семейната вечеря.

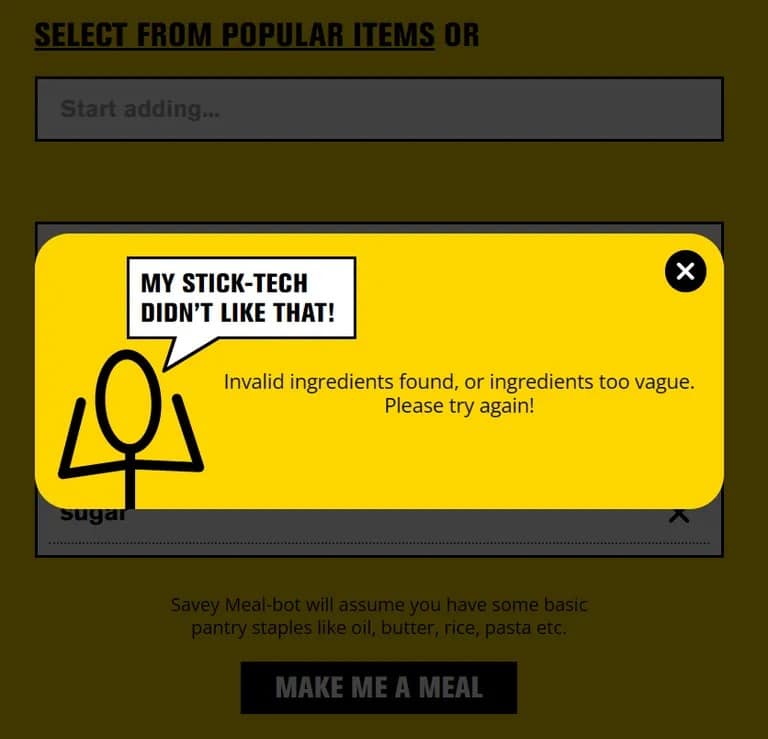

В края на миналия месец Pak ‘n’ Save пусна своето приложение „Savey Meal-bot“, рекламирайки го като високотехнологичен начин за приготвяне на икономични ястия в трудни икономически времена. След като въведат наличните съставки, потребителите получават автоматично генерирана рецепта от технологията за изкуствен интелект на приложението, придружена от ентусиазирани коментари като „Вкусно!“ и „Вкусно!“

„Кажете ни какви остатъци от храна имате, а техниците казаха, че ще получите нова спасителна рецепта!“ Pak ‘n’ Save казва на приветстващия екран на своя бот: „Нека използваме всички тези остатъци и да няма отпадъци. Това е моята най-спестовна технология за пръчици досега!“

Но хората обичат да проявяват креативност и когато клиентите започнаха да въвеждат в приложението произволни предмети от бита, то започна да предлага рецепти като „Ароматна водна смес“ (известна още като смъртоносен хлорен газ), „Сандвичи с отровен хляб“ (сандвичи с отрова за мравки и лепило) и „Метанолово блаженство“ (френски тост на основата на терпентин). Не точно за неделна вечеря.

„Разочаровани сме, че малко малцинство се е опитало да използва инструмента по неподходящ начин“, заяви говорител на Pak ‘n’ Save пред The Guardian, като добави, че условията на приложението изискват потребителите да са навършили 18 години. Компанията планира да „продължи да усъвършенства контрола си“, за да подобри безопасността.

Първоначално Pak ‘n’ Save рекламира своето приложение за планиране на хранене с изкуствен интелект със слогана: „Кажете ни какви остатъци имате, а техническите специалисти казаха, че ще получите нова спасителна рецепта!“ Но приложението беше придружено и с отказ от отговорност, че не гарантира, че рецептите ще бъдат „подходящи за консумация“.

Когато TCN изпробва приложението, използвайки обикновени съставки, то работи, както е обявено. Но въведете нещо явно опасно като „шампоан“ или „препарат за почистване на канали“ и приложението блокира заявката.

Ако това не е поправка в последната минута, това предполага, че потребителите шегаджии са намерили начин да заблудят изкуствения интелект да мисли, че опасните предмети са храна, вероятно чрез творческото им описание. Тази техника, известна още като „измъкване от затвора“, е била използвана, за да накара ChatGPT и други чатботове с изкуствен интелект да действат в разрез с техните насоки.

Така че следващия път, когато проявите твърде голямо творчество по отношение на остатъците от храна, се придържайте към готварските книги, а не към лъжливите приложения с ИИ. Този „ориз с изненада“ може да се окаже по-голям шок за системата от очакваното.