Alors que les photos et vidéos réalistes générées par l’IA prolifèrent en ligne, les entreprises technologiques et les groupes de surveillance s’efforcent de mettre au point des outils permettant d’identifier les contenus falsifiés.

Le filigrane des images générées par ordinateur est une solution couramment proposée, ajoutant un drapeau invisible sous la forme de métadonnées cachées qui aident à révéler qu’une image a été créée à l’aide d’un outil d’IA générative. Mais les chercheurs ont constaté que ce type de filigrane présente un défaut majeur : les techniques adverses peuvent facilement le supprimer.

Aujourd’hui, les principaux fabricants d’appareils photo proposent une approche différente, à l’opposé en quelque sorte : l’intégration de filigranes dans de « vraies » photographies.

Nikon, Sony et Canon ont récemment annoncé une initiative commune visant à inclure des signatures numériques dans les images prises directement à partir de leurs appareils photo sans miroir haut de gamme. Selon Nikkei Asia, les signatures intégreront des métadonnées clés telles que la date, l’heure, la localisation GPS et les coordonnées du photographe, certifiant de manière cryptographique l’origine numérique de chaque photo.

Nikon a déclaré qu’il lancerait cette fonctionnalité dans sa prochaine gamme d’appareils photo professionnels sans miroir ; Sony publiera des mises à jour de micrologiciel pour insérer des signatures numériques dans ses appareils photo sans miroir actuels ; et Canon a l’intention de lancer des appareils photo avec authentification intégrée en 2024, ainsi que le tatouage vidéo plus tard dans l’année.

L’objectif, selon Nikkei, est de fournir aux photojournalistes, aux professionnels des médias et aux artistes une preuve irréfutable de la crédibilité de leurs images. Les signatures inviolables ne disparaîtront pas avec les modifications et devraient contribuer à la lutte contre la désinformation et l’utilisation frauduleuse des photos en ligne.

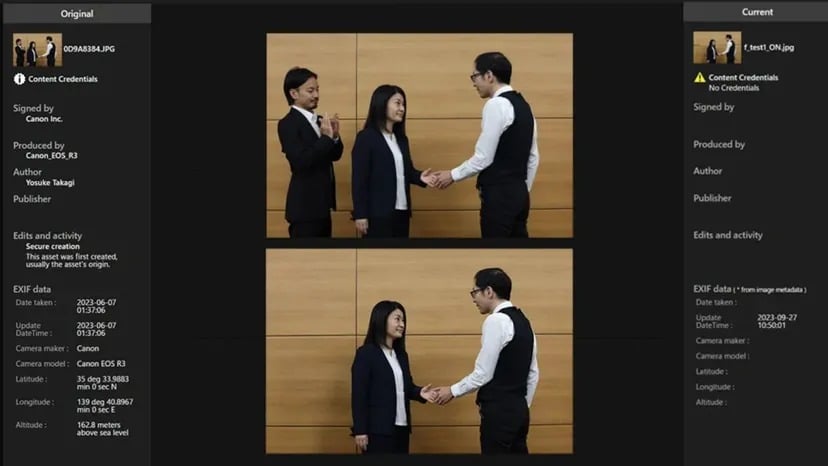

Pour ce faire, les entreprises ont collaboré à l’élaboration d’une norme ouverte pour les signatures numériques interopérables, appelée « Verify ». Une fois en place, les photos prises avec le matériel adéquat pourront être vérifiées en ligne gratuitement afin que les internautes puissent déterminer si une photo est authentique ou non.

Si une photo générée par l’IA tente de passer le système Verify sans signature authentique, elle sera étiquetée comme « No Content Credentials ».

Source : Canon

Au lieu de marquer rétroactivement le contenu de l’IA, le plan authentifie directement les photos réelles à l’origine. Mais comme tout autre système de filigrane, son succès dépendra de son adoption à grande échelle (davantage de fabricants de matériel intègrent la norme) et d’une mise en œuvre à l’épreuve du temps (le code évolue pour rester non piratable).

Comme l’a rapporté TCN, des recherches récentes indiquent que les techniques anti-filigrane pourraient également compromettre les signatures intégrées, rendant ainsi les méthodes de filigrane actuelles inutiles. Toutefois, cela ne fait que rendre les images filigranées non filigranées, de sorte que les gens ont moins d’outils pour détecter leur artificialité.

Si les techniques anti-filigrane peuvent potentiellement supprimer les signatures d’authenticité des photos réelles, cela est moins problématique que de supprimer les filigranes des fausses images générées par l’intelligence artificielle. Pourquoi ? Si un filigrane est retiré d’un deepfake généré par l’IA, le contenu falsifié peut plus facilement passer pour réel. Toutefois, si des signatures d’authentification sont piratées sur des photos réelles, l’image restante est toujours capturée par un appareil photo – elle ne provient pas d’un modèle génératif. Bien qu’elle perde sa preuve cryptographique, le contenu sous-jacent est toujours authentique.

Le principal risque dans ce cas est lié à l’attribution et à la gestion des droits, et non à la véracité du contenu. L’image pourrait être mal créditée ou utilisée sans licence appropriée, mais elle n’induit pas intrinsèquement les spectateurs en erreur quant à la réalité qu’elle représente

L’OpenAI a récemment annoncé un détecteur de deepfake alimenté par l’IA qui, selon elle, a une précision de 99 % sur les images. Cependant, les détecteurs d’IA restent imparfaits et doivent constamment être mis à niveau pour suivre les évolutions de la technologie générative.

La récente montée en puissance de la sophistication des deepfakes a en effet mis en lumière la nécessité de telles stratégies. Comme nous l’avons vu en 2023, la nécessité de faire la différence entre un contenu réel et un contenu fabriqué n’a jamais été aussi aiguë. Les politiciens et les développeurs technologiques s’efforcent de trouver des solutions viables, et un peu d’aide de la part de ces entreprises serait certainement appréciée.