Die schleichende Verbreitung von „Deepfakes“ birgt erhebliche Risiken – von der Erstellung von Bildern nackter Minderjähriger bis hin zu betrügerischen Werbeaktionen, die „Deepfakes“ von Prominenten verwenden, war die Fähigkeit, zwischen KI-generierten Inhalten (AIGC) und menschengenerierten Inhalten zu unterscheiden, noch nie so entscheidend.

Eine Methode zur Identifizierung dieser Art von Inhalten ist das

Watermark, eine gängige Fälschungsschutzmaßnahme, die in Dokumenten und Geld zu finden ist, wobei Informationen hinzugefügt werden, die dabei helfen, ein KI-generiertes Bild von einem nicht durch künstliche Intelligenz erzeugten Bild zu unterscheiden. Neuere Forschungsergebnisse kommen jedoch zu dem Schluss, dass einfache oder sogar ausgefeilte Wasserzeichenmethoden möglicherweise nicht ausreichen, um die Risiken zu vermeiden, die damit verbunden sind, von KI erzeugtes Material als von Menschen erzeugtes Material auszugeben.

Die Studie wurde von einem Team von Forschern der Nanyang Technological University, des S-Lab, der NTU, der Chongqing University, von Shannon.AI und der Zhejiang University durchgeführt.

Einer der Autoren, Li Guanlin, erklärte gegenüber TCN, dass „das Wasserzeichen den Menschen helfen kann, zu erkennen, ob Inhalte von KI oder von Menschen erstellt wurden“. Er fügte jedoch hinzu: „Wenn das Wasserzeichen auf dem IKGV leicht zu entfernen oder zu fälschen ist, können wir durch das Hinzufügen des Wasserzeichens andere willkürlich davon überzeugen, dass das Kunstwerk von der KI erstellt wurde, oder dass der IKGV von Menschen erstellt wurde, indem wir das Wasserzeichen entfernen“.

Das Dokument untersucht mehrere Schwachstellen in aktuellen Wasserzeichenmethoden.

„Wasserzeichensysteme für IGVC sind anfällig für Angriffe eines Gegners, der das Wasserzeichen entfernen kann, ohne den geheimen Schlüssel zu kennen“, heißt es in dem Bericht. Diese Schwachstelle hat Auswirkungen auf die reale Welt, insbesondere wenn es zu Desinformation oder böswilliger Nutzung von KI-generierten Inhalten kommt.

„Wenn böswillige Nutzer gefälschte KI-generierte Bilder von Prominenten verbreiten, nachdem sie die Wasserzeichen entfernt haben, können wir nicht beweisen, dass diese Bilder von der KI generiert wurden, da wir nicht genügend Beweise haben“, sagte Li gegenüber TCN.

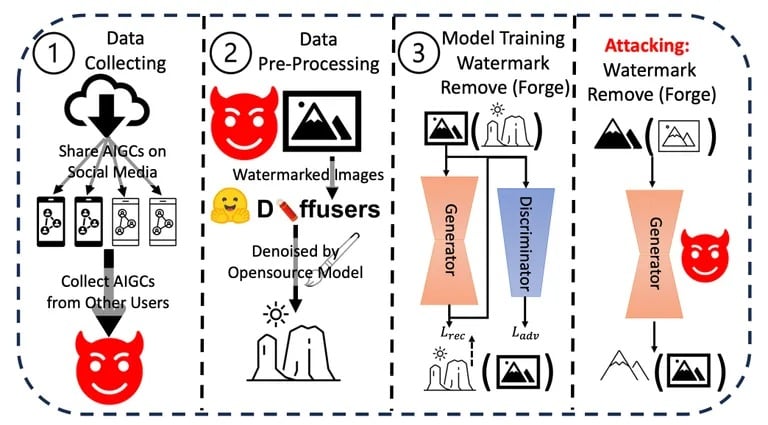

Herr Li und sein Team führten eine Reihe von Experimenten durch, um die Robustheit und Integrität der derzeitigen Wasserzeichenmethoden bei KI-generierten Inhalten zu testen. Sie verwendeten verschiedene Techniken, um Wasserzeichen zu entfernen oder zu fälschen, und bewerteten die Einfachheit und Effektivität jeder Methode. Die Ergebnisse zeigten durchweg, dass es relativ einfach ist, Wasserzeichen zu stören.

In der Studie verwendete Angriffsverfahren. Bild: Arvix

Darüber hinaus bewerteten sie die potenziellen Auswirkungen dieser Schwachstellen in der realen Welt, insbesondere in Szenarien, in denen es um Desinformation oder die böswillige Nutzung von KI-generierten Inhalten geht. Die kumulierten Ergebnisse dieser Experimente und Analysen führten zu der Schlussfolgerung, dass dringend robustere Wasserzeichenmechanismen benötigt werden.

Obwohl Unternehmen wie OpenAI angekündigt haben, dass sie Methoden entwickelt haben, mit denen sich KI-generierte Inhalte mit einer Genauigkeit von 99 % erkennen lassen, bleibt die Gesamtherausforderung bestehen. Die derzeitigen Identifizierungsmethoden, wie Metadaten und unsichtbare Wasserzeichen, stoßen an ihre Grenzen.

Li schlägt vor, dass „zum Schutz von IGVC bestimmte kryptografische Methoden, wie digitale Signaturen, am besten mit bestehenden Wasserzeichensystemen kombiniert werden sollten“, obwohl die genaue Umsetzung unklar bleibt.

Andere Forscher haben einen extremeren Ansatz vorgeschlagen. Wie TCN kürzlich berichtete, schlug ein Team des MIT vor, Bilder für Modelle der künstlichen Intelligenz in „Gift“ zu verwandeln. Wenn ein „vergiftetes“ Bild als Eingabe in einen Lerndatensatz verwendet würde, würde das daraus resultierende Modell schlechte Ergebnisse liefern, weil es Details enthalten würde, die für das menschliche Auge nicht sichtbar sind, die aber einen großen Einfluss auf den Lernprozess haben. Dies wäre wie ein tödliches Wasserzeichen, das das gebildete Modell töten würde.

Die raschen Fortschritte der KI, die Sam Altman, CEO von OpenAI, hervorhob, weisen auf eine Zukunft hin, in der die natürlichen Denkprozesse der KI die menschliche Logik und Intuition widerspiegeln können. Angesichts solcher Fortschritte wird der Bedarf an robusten Sicherheitsmaßnahmen wie dem Wasserzeichen noch dringender.

Li ist der Meinung, dass „Wasserzeichen und Content Management notwendig sind, weil sie normale Nutzer nicht wirklich betreffen“, aber der Konflikt zwischen Schöpfern und Kritikern bleibt bestehen. „Es wird immer ein Katz-und-Maus-Spiel sein….. Deshalb müssen wir unsere Wasserzeichensysteme ständig aktualisieren“.