Trotz des Warnschusses, der um die Welt ging – ein offener Brief, der von Hunderten von Branchenführern unterzeichnet wurde und in dem künstliche Intelligenz zu einer existenziellen Bedrohung für die Menschheit erklärt wurde – zeichnet eine neue Umfrage unter mehr als 2.700 KI-Experten ein weniger düsteres Bild von der Zukunft.

Die umfassende Umfrage zu den Auswirkungen von KI, die mit Hilfe von Forschern der Universitäten Oxford, Berkeley und Bonn durchgeführt wurde, befragte KI-Forscher zum Tempo des Fortschritts in diesem Bereich und zu den potenziellen Auswirkungen fortgeschrittener KI-Systeme. Während ein breites Spektrum an Perspektiven zusammengetragen wurde, waren nur etwa 5 % der Meinung, dass die Wahrscheinlichkeit des Aussterbens der Menschheit durch KI hoch sei.

Dies steht in krassem Gegensatz zu den Ansichten der breiten Öffentlichkeit.

Eine Umfrage vom August 2023 ergab, dass 61 % der Amerikaner die KI als eine Bedrohung für die Menschheit ansehen. Diese Besorgnis wurde auch von führenden Vertretern der Industrie geäußert, die ein Schreiben des Center for AI Safety unterzeichneten, in dem es heißt, dass „die Eindämmung des Risikos des Aussterbens durch KI eine globale Priorität sein sollte“.

Paul Christiano, ehemaliger Leiter der Abteilung Ausrichtung bei OpenAI, schätzt die Wahrscheinlichkeit, dass KI in einer „Katastrophe“ endet, auf 50 %. Viele haben KI zu einer Bedrohung erklärt, die mit einem Atomkrieg oder einer globalen Pandemie gleichzusetzen ist.

Trotz dieser weit verbreiteten pessimistischen Vorhersagen entwickelt sich die KI weiter. Die Unternehmen arbeiten mit Hochdruck an der Entwicklung fortschrittlicherer Systeme, und der CEO von OpenAI, Sam Altman, plädiert für eine Regulierung, um die Grenzen der Technologie zu testen.

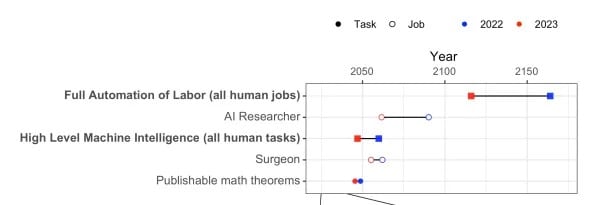

Hinsichtlich der KI-Fähigkeiten sagten viele der Befragten voraus, dass KI innerhalb von 10 Jahren wichtige kreative Meilensteine erreichen wird: zum Beispiel die Programmierung einer kompletten Zahlungswebsite von Grund auf oder die Erstellung von Songs, die von den heutigen Hits nicht zu unterscheiden sind. Bei Herausforderungen wie dem Beweisen mathematischer Theoreme ist die Zeitspanne jedoch länger:

Die Möglichkeit, dass maschinelle Intelligenz auf hohem Niveau (HLMI) Realität wird, ist 13 Jahre näher gerückt, wobei eine 50 %ige Erfolgswahrscheinlichkeit bis 2047 vorhergesagt wird. Ebenso wurde der Horizont für die vollständige Automatisierung der Arbeit (FAOL) – eine der umstrittenen Vorhersagen von Elon Musk – um 48 Jahre auf 2116 vorverlegt.

Auf die Frage, ob die KI in der Lage sein wird, alle menschlichen Fähigkeiten zu erreichen, prognostizieren die Forscher eine 50 %ige Chance bis 2047. Das ist 13 Jahre früher als bei einer ähnlichen Umfrage im Jahr 2022.

Die Befragten waren geteilter Meinung, ob ein schnellerer oder langsamerer Fortschritt der Menschheit mehr nützen würde.

Interessanterweise gehen die Forscher davon aus, dass die KI-Systeme des Jahres 2043 in der Lage sein werden, unerwartete Wege zur Erreichung von Zielen zu finden, während sie weniger Vertrauen in die menschliche Fähigkeit haben, solche Handlungen zu erklären. Diese Unklarheit darüber, wie KI-Entscheidungen getroffen werden, unterstreicht die Notwendigkeit, der KI-Sicherheitsforschung Priorität einzuräumen – eine Ansicht, die von 70 % der Befragten geteilt wurde.

Die Meinungen darüber, ob man der KI im Jahr 2028 zutrauen kann, ihre eigenen Überlegungen zu erklären, gingen auseinander.

Erhebliche Bedenken bestehen auch in Bezug auf Risiken wie Fehlinformationen, Ungleichheit und Massenüberwachung durch KI.

Während die Forscher insgesamt vorsichtig optimistisch sind, glauben etwa 40 %, dass die Wahrscheinlichkeit, dass die Menschheit durch fortschrittliche KI ausstirbt, minimal (nicht gleich null) ist. Auch wenn Killerroboter nicht unmittelbar bevorstehen, bleibt die Untersuchung der Ethik und Sicherheit von KI von entscheidender Bedeutung.