Despite the warning shot heard around the world-an open letter signed by hundreds of industry leaders declarating artificial intelligence an existential threat to humanity-a new survey of over 2,700 AI experts paints a less dire picture of the future.

W kompleksowym badaniu AI Impacts, przeprowadzonym z pomocą naukowców z uniwersytetów w Oksfordzie, Berkeley i Bonn, zapytano badaczy sztucznej inteligencji o tempo postępu w tej dziedzinie i potencjalny wpływ zaawansowanych systemów sztucznej inteligencji. Podczas gdy zebrano szeroki zakres perspektyw, tylko około 5% uważało, że istnieje duża szansa na wyginięcie człowieka z powodu sztucznej inteligencji.

Kontrastuje to wyraźnie z nastrojami ogółu społeczeństwa.

Sondaż z sierpnia 2023 r. wykazał, że 61% Amerykanów postrzega sztuczną inteligencję jako zagrożenie dla ludzkości. Obawy te zostały powtórzone przez liderów branży, którzy podpisali list Center for AI Safety, w którym stwierdzili, że „złagodzenie ryzyka wyginięcia z powodu sztucznej inteligencji powinno być globalnym priorytetem”.

Paul Christiano, były szef ds. dostosowania w OpenAI, oszacował 50% szans na to, że sztuczna inteligencja zakończy się „katastrofą”. Wielu uznało sztuczną inteligencję za zagrożenie na równi z wojną nuklearną lub globalną pandemią.

Pomimo tych szeroko rozpowszechnionych pesymistycznych prognoz, sztuczna inteligencja nadal ewoluuje. Firmy ścigają się w opracowywaniu bardziej zaawansowanych systemów, a dyrektor generalny OpenAI, Sam Altman, opowiada się za regulacjami, a także za testowaniem granic technologii.

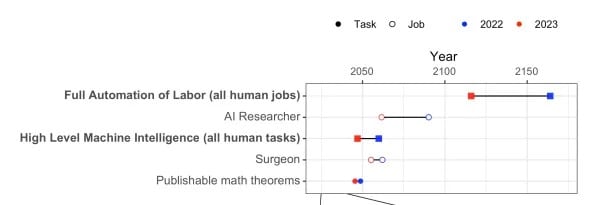

Jeśli chodzi o możliwości AI, wielu respondentów ankiety przewidywało, że AI osiągnie główne kamienie milowe w kreatywności w ciągu 10 lat: na przykład kodowanie całej strony internetowej płatności od podstaw lub tworzenie piosenek nie do odróżnienia od dzisiejszych hitów. Ale ramy czasowe rozciągały się dłużej w przypadku wyzwań takich jak matematyczne dowodzenie twierdzeń.

Dokładniej rzecz ujmując, możliwość urzeczywistnienia Inteligencji Maszyn Wysokiego Poziomu (HLMI) przybliżyła się o 13 lat, z 50% prawdopodobieństwem sukcesu przewidywanym do 2047 roku. Podobnie, horyzont pełnej automatyzacji pracy (FAOL) – jedna z kontrowersyjnych prognoz Elona Muska – przesunął się o 48 lat wcześniej, do 2116 roku.

Zapytani o zdolność sztucznej inteligencji do dorównania wszystkim ludzkim umiejętnościom, naukowcy przewidują 50% szans do 2047 roku. To o 13 lat wcześniej niż w podobnej ankiecie z 2022 roku.

Respondenci byli podzieleni co do tego, czy szybszy czy wolniejszy postęp przyniósłby ludzkości więcej korzyści.

Co ciekawe, podczas gdy oczekuje się, że systemy sztucznej inteligencji w 2043 roku będą w stanie znaleźć nieoczekiwane sposoby na osiągnięcie celów, wśród badaczy panuje mniejsze zaufanie do ludzkiej zdolności wyjaśniania takich działań. Ta niejednoznaczność w sposobie podejmowania decyzji przez sztuczną inteligencję podkreśla potrzebę priorytetowego traktowania badań nad bezpieczeństwem sztucznej inteligencji – zdanie to powtórzyło 70% respondentów.

Opinie na temat tego, czy sztucznej inteligencji w 2028 r. można zaufać, jeśli chodzi o wyjaśnianie własnego rozumowania, były różne.

Istnieją również poważne obawy dotyczące zagrożeń, takich jak dezinformacja, nierówność i masowa inwigilacja umożliwiana przez sztuczną inteligencję.

Podczas gdy badacze są ogólnie ostrożnie optymistyczni, około 40% uważa, że istnieje minimalna (nie zerowa) szansa na wyginięcie ludzi z powodu zaawansowanej sztucznej inteligencji. Tak więc, chociaż zabójcze roboty nie są nieuchronne, badanie etyki i bezpieczeństwa sztucznej inteligencji pozostaje krytyczne.