Сообщество искусственного интеллекта получило новое «перо в шапку», выпустив Falcon 180B — открытую большую языковую модель (LLM) с 180 миллиардами параметров, обученную на огромном количестве данных. Эта мощная новинка превзошла предыдущие модели с открытым исходным кодом по нескольким параметрам.

О выходе Falcon 180B было объявлено в блоге сообщества Hugging Face AI на Hugging Face Hub. Архитектура новейшей модели основана на предыдущей серии открытых LLM Falcon и использует такие инновации, как многозапросное внимание, для масштабирования до 180 млрд. параметров, обученных на 3,5 трлн. токенов.

На сегодняшний день это самый продолжительный период обучения на одной эпохе для модели с открытым исходным кодом. Для достижения таких показателей одновременно использовалось 4096 графических процессоров в течение примерно 7 млн GPU-часов с применением Amazon SageMaker для обучения и доработки.

Если говорить о размерах Falcon 180B, то ее параметры в 2,5 раза больше, чем у модели LLaMA 2 компании Meta. LLaMA 2 после запуска в начале этого года считалась самой мощной LLM с открытым исходным кодом и имела 70 млрд. параметров, обученных на 2 трлн. токенов.

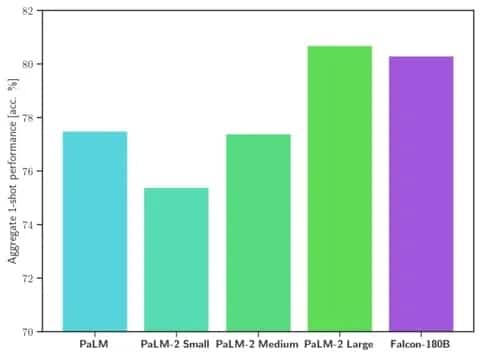

Falcon 180B превосходит LLaMA 2 и другие модели как по масштабу, так и по эталонной производительности в целом ряде задач обработки естественного языка (NLP). Она занимает лидирующие позиции среди моделей открытого доступа с результатом 68,74 балла и достигает почти равного уровня с коммерческими моделями, такими как PaLM-2 от Google, в таких оценках, как бенчмарк HellaSwag.

Изображение: Обнимающееся лицо

В частности, Falcon 180B соответствует или превосходит PaLM-2 Medium по часто используемым бенчмаркам, включая HellaSwag, LAMBADA, WebQuestions, Winogrande и др. По сути, он находится на одном уровне с PaLM-2 Large от Google. Это очень высокие показатели для модели с открытым исходным кодом, даже в сравнении с решениями, разработанными гигантами отрасли.

Если сравнивать с ChatGPT, то модель мощнее бесплатной версии, но чуть менее производительна, чем платный сервис «плюс».

«Falcon 180B обычно находится где-то между GPT 3.5 и GPT4 в зависимости от оценочного эталона, и за дальнейшей доработкой со стороны сообщества будет очень интересно наблюдать, поскольку она уже открыта», — говорится в блоге.

Выпуск Falcon 180B представляет собой очередной скачок в стремительном прогрессе, достигнутом в последнее время в области LLM. Помимо масштабирования параметров, такие технологии, как LoRA, рандомизация весов и Perfusion от Nvidia, позволили значительно повысить эффективность обучения больших моделей ИИ.

В настоящее время Falcon 180B находится в свободном доступе на сайте Hugging Face, и исследователи ожидают, что модель получит дополнительные преимущества благодаря дальнейшим усовершенствованиям, разработанным сообществом. Тем не менее, демонстрация передовых возможностей работы с естественным языком с самого начала знаменует собой захватывающее развитие ИИ с открытым исходным кодом.