Die Möglichkeit, KI-generierte Deepfakes von berühmten und einflussreichen Personen zu erstellen, hat im Internet einen ziemlichen Sturm ausgelöst. Doch während Bilder des Papstes, der eine bauschige Balenciaga-Jacke trägt, und des ehemaligen US-Präsidenten Donald Trump, der verhaftet wurde, für Schlagzeilen sorgten, zeichnet sich ein neuer Trend ab: Deepfakes von Mordopfern, so ein Bericht des Rolling Stone.

„Sie scheinen darauf ausgelegt zu sein, starke emotionale Reaktionen auszulösen, denn das ist der sicherste Weg, um Klicks und Likes zu bekommen“, so Paul Bleakley, Assistenzprofessor für Strafjustiz an der Universität von New Haven, gegenüber Rolling Stone, „Es ist unangenehm anzuschauen, aber ich denke, das könnte der Sinn sein“.

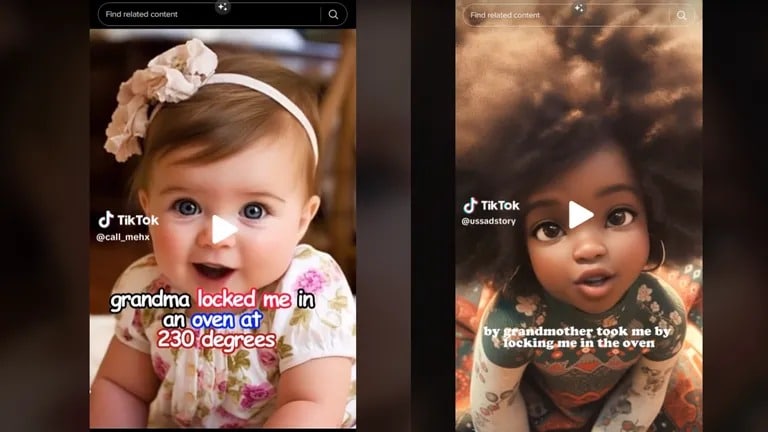

Die kurzen Videoclips, die auf TikTok die Runde machen, enthalten KI-generierte Videos, Audios und Ich-Beschreibungen von Kindern. Zu den bekanntesten, die auf diese Weise dargestellt werden, gehört Royalty Marie Floyd, die in einigen Videos als Rody Mary Floyd dargestellt wird und deren Leiche 2018 in einem Ofen gefunden wurde. Floyds Großmutter, Carolyn Jones, wurde des Mordes an Floyd angeklagt, so Rolling Stone, und fügte hinzu, dass der KI-Generator auch unterschiedliches Alter und Rasse des Kindes angab.

Image: KI-generierte Varianten von Royalty Marie Floyd

Das Phänomen, das diese Fehler verursacht, wird als Halluzinationen bezeichnet. KI-Halluzinationen“ beziehen sich auf Fälle, in denen eine KI unerwartete, unwahre Ergebnisse erzeugt und nicht durch reale Daten gestützt wird. KI-Halluzinationen können falsche Inhalte, Nachrichten oder Informationen über Personen, Ereignisse oder Fakten erzeugen.

„Diese KI-Deepfakes echter Verbrechensopfer erwecken die Geschichte auf eine Weise zum Leben, die sich niemand von uns hätte vorstellen können, was zur Aufklärung der Öffentlichkeit beitragen könnte“, sagte Andrew Rossow, Anwalt und CEO von AR Media, gegenüber TCN. „Aus rechtlicher Sicht ist diese Nutzung und Anwendung von KI jedoch äußerst beunruhigend und problematisch“.

Rossow wies auf zwei Hauptprobleme hin: Bedenken hinsichtlich des Datenschutzes und die Verursachung emotionalen Leids bei denjenigen, die das Opfer kannten.

Ein Deepfake ist eine immer häufiger vorkommende Art von Video, das mit künstlicher Intelligenz erstellt wird und falsche Ereignisse darstellt. Deepfakes sind bereits ein Anliegen von Cybersecurity- und Strafverfolgungsbehörden, aber dank sich schnell entwickelnder generativer KI-Plattformen wie Midjourney 5.1 und DALL-E 2 von OpenAI werden sie immer schwieriger zu erkennen.

Midjourney hat seine kostenlose Testversion im März eingestellt, nachdem die Zahl der mit seiner Technologie erzeugten viralen Deepfakes gestiegen war.

Die wachsende Macht der künstlichen Intelligenz führt auch dazu, dass Betrüger die Technologie nutzen, um Möchtegern-Investoren um ihr Geld und ihre Kryptowährung zu bringen. Letzte Woche ging ein Deepfake-Video von Elon Musk, der für einen Krypto-Betrug wirbt, viral.

Wie der Rolling Stone berichtet, wurde der Account, der das Royalty Marie Floyd-Video hochgeladen hat, von TikTok wegen „Verletzung der Richtlinien der Plattform in Bezug auf synthetische Medien, die Privatpersonen darstellen“, vom Netz genommen. Dennoch ist der Geist bereits aus der Flasche, und Accounts, die ähnliche Videos posten, füllen die Lücke.

„Leider müssen Anwendungsfälle wie dieser passieren, damit wir unsere Rechtsprechung und Präzedenzfälle in Bezug auf bereits heftig diskutierte Fragen der Privatsphäre (vor und nach dem Tod) und neu aufkommende Technologien, die an und für sich noch in der Grauzone mit unseren Gerichten operieren, vorantreiben können“, sagte Rossow.