La capacidad de crear deepfakes generados por IA de personajes famosos e influyentes ha causado una gran tormenta en Internet, pero mientras que las imágenes del Papa con una chaqueta abullonada de Balenciaga y el ex presidente de Estados Unidos Donald Trump siendo arrestado han acaparado titulares, está surgiendo una nueva tendencia: deepfakes de víctimas de asesinato, según un informe de Rolling Stone.

«Parecen diseñados para provocar fuertes reacciones emocionales, porque es la forma más segura de conseguir clics y likes», dijo a Rolling Stone Paul Bleakley, profesor adjunto de justicia penal en la Universidad de New Haven. «Es incómodo de ver, pero creo que ese podría ser el punto».

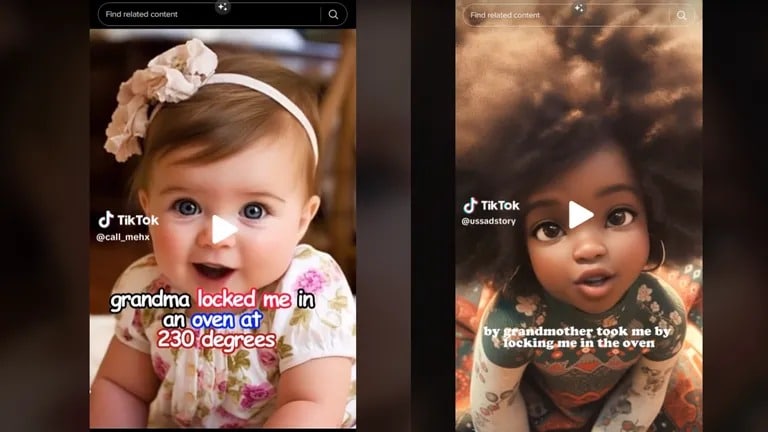

Los breves videoclips que circulan por TikTok incluyen vídeos generados por inteligencia artificial, audio y descripciones de niños en primera persona. Entre los más conocidos representados de esta manera está Royalty Marie Floyd, presentada en algunos vídeos como Rody Mary Floyd, cuyo cuerpo fue encontrado en un horno en 2018. La abuela de Floyd, Carolyn Jones, fue acusada del asesinato de Floyd, dijo Rolling Stone, agregando que el generador de IA también dio diferentes edades y razas de la niña.

Imagen: Variantes generadas por IA de Royalty Marie Floyd

El fenómeno que provoca estos errores se conoce como alucinaciones. Las «alucinaciones» de la IA se refieren a los casos en que una IA genera resultados inesperados y falsos y no está respaldada por datos del mundo real. Las alucinaciones de la IA pueden crear contenidos, noticias o información falsos sobre personas, acontecimientos o hechos.

«Estas deepfakes de IA de víctimas de crímenes reales ciertamente dan vida a la historia de una manera que ninguno de nosotros podría haber imaginado, lo que podría ayudar a educar al público en general», dijo el abogado y CEO de AR Media Andrew Rossow a TCN. «Sin embargo, desde una perspectiva legal, esta utilización y aplicación de la IA es extremadamente preocupante y problemática».

Rossow señaló dos cuestiones principales: los problemas de privacidad y causar angustia emocional a quienes conocían a la víctima.

Un deepfake es un tipo de vídeo cada vez más común creado con inteligencia artificial que representa acontecimientos falsos. Los deepfakes, que ya eran motivo de preocupación para las autoridades policiales y de ciberseguridad, son cada vez más difíciles de detectar gracias a plataformas de IA generativa en rápida evolución como Midjourney 5.1 y DALL-E 2 de OpenAI.

Midjourney puso fin a su versión de prueba gratuita en marzo tras el aumento de falsificaciones virales generadas con su tecnología.

El creciente poder de la IA también hace que los estafadores utilicen la tecnología para tratar de engañar a los posibles inversores para que pierdan su dinero y sus criptomonedas. La semana pasada, un vídeo deepfake de Elon Musk promocionando una estafa de criptomonedas se hizo viral.

Como informa Rolling Stone, la cuenta que subió el vídeo de Royalty Marie Floyd ha sido retirada por TikTok por «violar la política de la plataforma respecto a los medios sintéticos que representan a personas privadas.» Aún así, el genio ya está fuera de la botella, y las cuentas que publican vídeos similares están llenando el vacío.

«Lamentablemente, casos como este tienen que ocurrir para que podamos avanzar en nuestra jurisprudencia y precedentes legales sobre cuestiones ya muy debatidas que implican la privacidad (pre y post mortem) y la tecnología emergente que en sí misma todavía opera principalmente en el gris con nuestros tribunales», dijo Rossow.