Nachdem Apple die meiste Zeit des letzten Jahres scheinbar nur am Rande mitgewirkt hat, beginnt das Unternehmen nun, die Dinge im Bereich der künstlichen Intelligenz und insbesondere der Open-Source-KI aufzurütteln.

Der Tech-Gigant aus Cupertino hat sich mit der Universität von Santa Barbara zusammengetan, um ein KI-Modell zu entwickeln, das Bilder auf der Grundlage natürlicher Sprache bearbeiten kann, so wie Menschen mit ChatGPT interagieren. Apple nennt es Multimodal Large-Language Model-Guided Image Editing (MGIE).

MGIE interpretiert Textanweisungen von Nutzern, verarbeitet und verfeinert sie, um präzise Bildbearbeitungsbefehle zu generieren. Die Integration eines Diffusionsmodells verbessert den Prozess, so dass MGIE Bearbeitungen auf der Grundlage der Merkmale des Originalbildes vornehmen kann.

Multimodale Large Language Models (MLLMs), die sowohl Text als auch Bilder verarbeiten können, bilden die Grundlage der MGIE-Methode. Im Gegensatz zu herkömmlichen KI-Modellen, die sich nur auf Text oder Bilder konzentrieren, können MLLMs komplexe Anweisungen verarbeiten und in einem breiteren Spektrum von Situationen arbeiten. So kann ein Modell beispielsweise eine Textanweisung verstehen, die Elemente eines bestimmten Fotos analysieren, dann etwas aus dem Bild herausnehmen und ein neues Bild ohne dieses Element erstellen.

Um diese Aktionen durchführen zu können, muss ein KI-System über verschiedene Fähigkeiten verfügen, darunter generativer Text, generatives Bild, Segmentierung und CLIP-Analyse, und das alles in einem einzigen Prozess.

Die Einführung von MGIE bringt Apple dem Ziel näher, Fähigkeiten zu erreichen, die mit ChatGPT Plus von OpenAI vergleichbar sind und es Nutzern ermöglichen, mit KI-Modellen in Konversation zu treten, um individuelle Bilder auf der Grundlage von Texteingaben zu erstellen. Mit MGIE können Nutzer detaillierte Anweisungen in natürlicher Sprache geben – „entferne den Verkehrskegel im Vordergrund“ -, die in Bildbearbeitungsbefehle übersetzt und ausgeführt werden.

Mit anderen Worten: Der Benutzer kann mit einem Foto einer blonden Person beginnen und sie in einen Rotschopf verwandeln, indem er einfach sagt: „Mach aus dieser Person einen Rotschopf.“ Das Modell würde die Anweisung verstehen, die Haare der Person segmentieren, einen Befehl wie „rotes Haar, hochdetailliert, fotorealistisch, rothaarig“ generieren und dann die Änderungen per Inpainting ausführen.

Der Ansatz von Apple steht im Einklang mit bestehenden Tools wie Stable Diffusion, das mit einer rudimentären Schnittstelle für textgesteuerte Bildbearbeitung erweitert werden kann. Durch den Einsatz von Tools von Drittanbietern wie Pix2Pix können Benutzer mit der Stable Diffusion-Oberfläche über Befehle in natürlicher Sprache interagieren und die Auswirkungen auf die bearbeiteten Bilder in Echtzeit beobachten.

Apples Ansatz erweist sich jedoch als präziser als jede andere vergleichbare Methode.

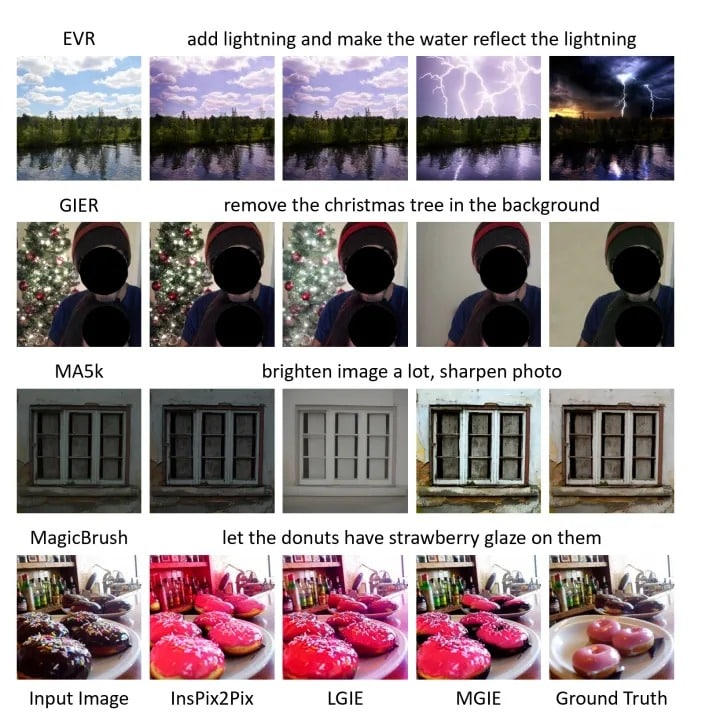

Ergebnisse der Bearbeitung eines Bildes mit natürlicher Sprache unter Verwendung von Instruct Pix2Pic, LGIE, Apples MGIE und Ground Truth Image: Apple

Neben der generativen KI kann Apples MGIE auch andere konventionelle Bildbearbeitungsaufgaben wie Farbkorrekturen, Größenänderungen, Drehungen, Stiländerungen und Skizzen durchführen

Warum sollte Apple es quelloffen machen?

Apples Open-Source-Vorstöße sind ein klarer strategischer Schachzug – mit einer Reichweite, die über bloße Lizenzierungsanforderungen hinausgeht.

Für die Entwicklung von MGIE verwendet Apple Open-Source-Modelle wie Llava und Vicuna. Aufgrund der Lizenzanforderungen dieser Modelle, die die kommerzielle Nutzung durch große Unternehmen einschränken, war Apple wahrscheinlich gezwungen, seine Verbesserungen offen auf GitHub zu veröffentlichen.

Dies ermöglicht es Apple aber auch, einen weltweiten Pool von Entwicklern zu nutzen, um seine Stärke und Flexibilität zu erhöhen. Diese Art der Zusammenarbeit bringt die Dinge viel schneller voran, als wenn Apple ganz allein arbeitet und bei Null anfängt. Darüber hinaus inspiriert diese Offenheit ein breiteres Spektrum an Ideen und zieht verschiedene technische Talente an, so dass sich MGIE schneller weiterentwickeln kann.

Das Engagement von Apple in der Open-Source-Gemeinschaft mit Projekten wie MGIE gibt der Marke auch Auftrieb bei Entwicklern und Technikbegeisterten. Dieser Aspekt ist kein Geheimnis, denn sowohl Meta als auch Microsoft investieren stark in Open-Source-KI.

Möglicherweise verschafft die Veröffentlichung von MGIE als Open-Source-Software Apple einen Vorsprung bei der Festlegung der sich noch entwickelnden Branchenstandards für KI und insbesondere für KI-basierte Bildbearbeitung. Mit MGIE hat Apple den KI-Künstlern und -Entwicklern wahrscheinlich eine solide Grundlage für die Entwicklung des nächsten großen Wurfs an die Hand gegeben, die mehr Genauigkeit und Effizienz bietet als das, was anderswo verfügbar ist.

MGIE wird Apples Produkte sicherlich verbessern: Es dürfte nicht allzu schwierig sein, einen an Siri gesendeten Sprachbefehl zu synthetisieren und diesen Text zur Bearbeitung eines Fotos auf dem Smartphone, Computer oder Innersive-Headset des Benutzers zu verwenden.

Technisch versierte KI-Entwickler können MGIE bereits jetzt nutzen. Besuchen Sie einfach das GitHub-Repository des Projekts: