去年大部分时间里,苹果公司似乎一直处于观望状态,如今它开始在人工智能–尤其是开源人工智能–领域大展拳脚。

这家位于库比蒂诺的科技巨头与圣巴巴拉大学合作开发了一种人工智能模型,它可以根据自然语言编辑图像,就像人们与 ChatGPT 交互一样。苹果称之为多模态大语言模型引导图像编辑(MGIE)。

MGIE 可以解释用户提供的文本指令,并对其进行处理和提炼,从而生成精确的图像编辑指令。扩散模型的集成增强了这一过程,使 MGIE 能够根据原始图像的特征进行编辑。

多模态大语言模型(MLLM)可同时处理文本和图像,是 MGIE 方法的基础。与只关注文本或图像的传统单模式人工智能不同,MLLM 可以处理复杂的指令,并在更广泛的情况下工作。例如,人工智能模型可以理解文字指令,分析特定照片的元素,然后从图像中提取某些元素并创建一张没有该元素的新照片。

要执行这些操作,人工智能系统必须具备不同的能力,包括生成文本、生成图像、分割和 CLIP 分析,所有这些都要在同一过程中完成。

MGIE的推出使苹果更接近于实现类似于OpenAI的ChatGPT Plus的功能,使用户能够与人工智能模型进行对话式互动,根据文本输入创建定制的图像。有了 MGIE,用户可以用自然语言提供详细的指令–“移除前景中的交通锥”–这些指令会被翻译成图像编辑命令并执行。

换句话说,用户只需说出 “把这个人变成红头发”,就能从一张金发碧眼的人的照片开始,将其变成姜黄色。在引擎盖下,模型会理解指令,对人的头发进行分割,生成类似 “红发、高度细致、逼真、姜黄色调 “的命令,然后通过内画执行更改。

苹果公司的做法与稳定扩散等现有工具相一致,后者可以通过一个简单的界面进行文本引导的图像编辑。借助 Pix2Pix 等第三方工具,用户可以使用自然语言命令与 Stable Diffusion 界面进行交互,见证编辑图像的实时效果。

不过,事实证明,苹果的方法比其他任何类似方法都更加准确。

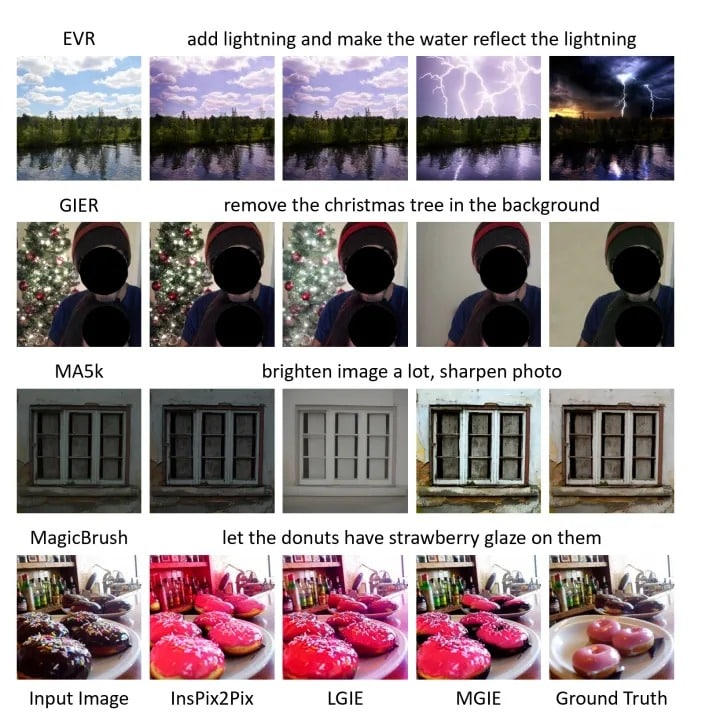

使用 Instruct Pix2Pic、LGIE、Apple 的 MGIE 和地面实况图像,用自然语言编辑图像的结果: Apple

除了生成式人工智能,苹果 MGIE 还能执行其他常规图像编辑任务,如调色、调整大小、旋转、更改样式和素描。

Why would Apple make it open source?

苹果的开源尝试是一项明确的战略举措,其范围超出了单纯的许可要求。

为了构建 MGIE,苹果使用了 Llava 和 Vicuna 等开源模型。由于这些模型的许可要求限制了大企业实体的商业使用,苹果很可能不得不在 GitHub 上公开分享其改进成果。

但这也让苹果能够利用全球范围内的开发者资源,以增强自身的实力和灵活性。这种合作比苹果完全靠自己从头开始要快得多。此外,这种开放性还能激发更广泛的创意,吸引不同的技术人才,让 MGIE 发展得更快。

苹果公司在开源社区中与 MGIE 等项目的合作也为其品牌在开发者和技术爱好者中的知名度带来了提升。这已经不是什么秘密了,Meta 和微软都在开源人工智能领域进行了大量投资。

将 MGIE 作为开源软件发布,可能会让苹果在为人工智能,特别是基于人工智能的图像编辑制定仍在不断发展的行业标准方面占得先机。有了 MGIE,苹果很可能为人工智能艺术家和开发人员提供了一个坚实的基础,使他们能够打造下一个大事件,提供比其他地方更高的准确性和效率。

MGIE 肯定会让苹果的产品变得更好:合成发送给 Siri 的语音命令,并使用该文本在用户的智能手机、电脑或 innersive 耳机上编辑照片,并不是一件太难的事。

精通技术的人工智能开发人员现在就可以使用 MGIE。只需访问该项目的 GitHub 存储库即可。