Liefhebbers van kunstmatige intelligentie werken liever met open-source tools dan met propriëtaire commerciële tools, zo blijkt uit een doorlopend onderzoek onder meer dan 100.000 respondenten.

De opkomst van Mistral AI’s Mixtral 8x7B, een open-source model, heeft een significante impact gehad in de AI-ruimte. Het is licht en krachtig en is door TCN uitgeroepen tot een van de beste LLM’s van 2023. Mixtral heeft veel aandacht gekregen voor zijn opmerkelijke prestaties in verschillende benchmarktests, met name Chatbot Arena, dat een unieke mensgerichte aanpak biedt voor het evalueren van LLM’s.

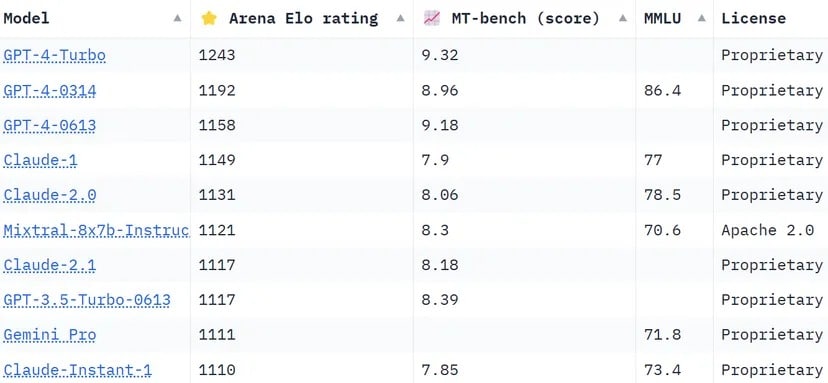

De Chatbot Arena-ranking, een crowdsourced lijst, maakt gebruik van meer dan 130.000 gebruikersstemmen om Elo-ratings voor AI-modellen te berekenen. In vergelijking met andere methoden die de resultaten proberen te standaardiseren om objectiever te zijn, kiest de arena voor een meer “menselijke” benadering, waarbij mensen blindelings worden gevraagd om te kiezen tussen twee antwoorden van niet-geïdentificeerde LLMS. Deze antwoorden kunnen naar bepaalde maatstaven onconventioneel lijken, maar kunnen intuïtief worden geëvalueerd door echte menselijke gebruikers.

Mixtral heeft een indrukwekkende reputatie en overtreft industriële giganten zoals Anthropíc’s Claude 2.1, OpenAI’s GPT-3.5, die de gratis versie van ChatGPT aandrijft, en Google’s Gemini, een multimodale LLM die werd verkocht als de krachtigste chatbot om de dominantie van GPT-4 uit te dagen.

Chatbot Arena’s ranglijst. Mistral AI’s LLM staat op plaats 6 in de lijst. Afbeelding: Huggingface

Een van de opvallende onderscheidende kenmerken van Mixtral is dat het de enige open-source LLM in de Chatbot Arena top 10 is. Deze onderscheiding is niet alleen een kwestie van ranking; het vertegenwoordigt een belangrijke verschuiving in de AI-industrie naar meer toegankelijke en community-gedreven modellen. Zoals gemeld door TCN, zei Mistral AI dat zijn model “beter presteert dan LlaMA 2 70B op de meeste benchmarks met 6x snellere inferentie en GPT 3.5 evenaart of overtreft op de meeste standaard benchmarks”, zoals MMLU, Arc-C of GSM.

Het geheim achter het succes van Mixtral ligt in de ‘Mixture of Experts’ (MoE) architectuur. Deze techniek maakt gebruik van meerdere virtuele expertmodellen die elk gespecialiseerd zijn in een specifiek onderwerp of vakgebied. Wanneer Mixtral met een probleem wordt geconfronteerd, selecteert het de meest relevante experts uit zijn pool, wat leidt tot nauwkeurigere en efficiëntere resultaten.

“Op elke laag, voor elke token, kiest een router netwerk twee van deze groepen (de ‘experts’) om de token te verwerken en hun output additief te combineren,” legt Mistral uit in de recent gepubliceerde paper van LLM. “Deze techniek verhoogt het aantal parameters van een model terwijl de kosten en latentie onder controle worden gehouden, omdat het model slechts een fractie van de totale set parameters per token gebruikt.”

Verder onderscheidt Mixtral zich door zijn meertaligheid. Het model blinkt uit in talen als Frans, Duits, Spaans, Italiaans en Engels, wat de veelzijdigheid en het brede potentieel aantoont. Het open-source karakter, onder de Apache 2.0 licentie, stelt ontwikkelaars in staat om het model vrij te verkennen, aan te passen en te verbeteren, wat een collaboratieve en innovatieve omgeving bevordert.

Het succes van Mixtral gaat duidelijk niet alleen over technologische dapperheid; het markeert een kleine maar belangrijke overwinning voor de open-source AI-gemeenschap. Misschien gaat het in een niet zo verre toekomst niet meer om de vraag welk model het eerst kwam, of welk model meer parameters of contextmogelijkheden heeft, maar welk model echt aanslaat bij de mensen.