Considérez-vous : L’IA pourrait entraîner l’extinction de l’humanité.

Mardi, des centaines de dirigeants et de chercheurs du secteur de l’IA, dont des cadres de Microsoft, Google et OpenAI, ont lancé un avertissement qui donne à réfléchir. Ils affirment que la technologie d’intelligence artificielle qu’ils mettent au point pourrait un jour représenter un danger réel et actuel pour l’existence de l’humanité. À côté des horreurs des pandémies et des guerres nucléaires, ils considèrent l’IA comme un risque sociétal d’une ampleur similaire.

Dans une lettre publiée par le Center for AI Safety, les spécialistes de l’IA ont fait cette déclaration qui se distingue par sa brièveté : « L’atténuation du risque d’extinction lié à l’IA devrait être une priorité mondiale au même titre que d’autres risques à l’échelle de la société tels que les pandémies et les guerres nucléaires. »

C’est tout, c’est tout ce qu’ils disent.

Source : Center for AI Safety

La déclaration présente l’IA comme une menace imminente, comparable à une catastrophe nucléaire ou à une pandémie mondiale. Mais les signataires, ces magiciens de l’industrie technologique, n’ont pas développé leur sinistre avertissement.

Comment ce scénario de fin du monde est-il censé se dérouler exactement ? Quand devrions-nous inscrire à nos calendriers l’avènement de nos maîtres robots ? Pourquoi l’IA, une invention issue de l’innovation humaine, se retournerait-elle contre ses créateurs ? Le silence de ces architectes de l’intelligence artificielle a été retentissant, et ils n’ont fourni aucune réponse.

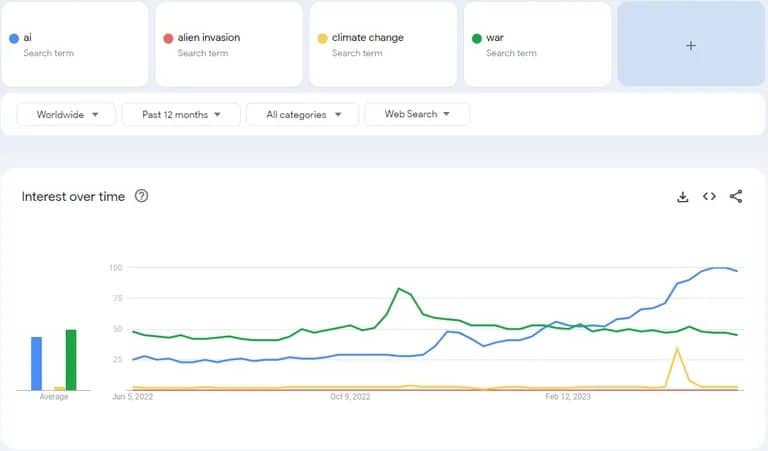

En fait, ces chefs de file de l’industrie n’ont pas été plus instructifs qu’un chatbot aux réponses toutes faites. Dans le domaine des menaces mondiales, l’IA semble avoir soudainement pris le dessus, devançant le changement climatique, les conflits géopolitiques et même les invasions d’extraterrestres en termes de recherche de mots clés sur Google.

Recherches Google sur l’IA, comparées à d’autres préoccupations mondiales telles que la guerre, les invasions extraterrestres et le changement climatique. Image : Google

Il est intéressant de noter que les entreprises ont tendance à défendre les réglementations qui vont dans le sens de leurs intérêts. On peut considérer que c’est leur façon de dire : « Nous souhaitons avoir notre mot à dire dans l’élaboration de ces réglementations. » C’est un peu comme si le renard demandait de nouvelles règles dans le poulailler.

Il est également à noter que le PDG d’OpenAI, Sam Altman, a fait pression en faveur d’une réglementation aux États-Unis. Il a néanmoins menacé de quitter l’Europe si les politiciens du continent continuaient à essayer de réglementer l’IA. « Nous allons essayer de nous conformer », a déclaré M. Altman lors d’une table ronde à l’University College London. « Si nous pouvons nous conformer, nous le ferons. Et si nous ne le pouvons pas, nous cesserons nos activités. »

Il est juste de dire qu’il a fait marche arrière quelques jours plus tard, déclarant qu’OpenAI n’avait pas l’intention de quitter l’Europe. Bien entendu, cela s’est produit après qu’il ait eu l’occasion de discuter de la question avec les régulateurs au cours d’une « semaine très productive ».

une semaine très productive de conversations en europe sur la meilleure façon de réglementer l’IA ! nous sommes ravis de continuer à opérer ici et n’avons bien sûr aucun projet de départ.

– Sam Altman (@sama) 26 mai 2023

L’IA est risquée, mais l’est-elle à ce point ?

Les dangers potentiels de l’intelligence artificielle ne sont pas passés inaperçus auprès des experts. Une lettre ouverte signée par 31 810 personnes, dont Elon Musk, Steve Wozniak, Yuval Harari et Andrew Yang, appelait à une pause dans la formation des puissants modèles d’IA.

« Ces protocoles devraient garantir que les systèmes qui y adhèrent sont sûrs au-delà de tout doute raisonnable », indique la lettre, précisant que « cela ne signifie pas une pause dans le développement de l’IA en général, mais simplement un recul par rapport à la course dangereuse vers des modèles de boîte noire imprévisibles de plus en plus grands avec des capacités émergentes. «

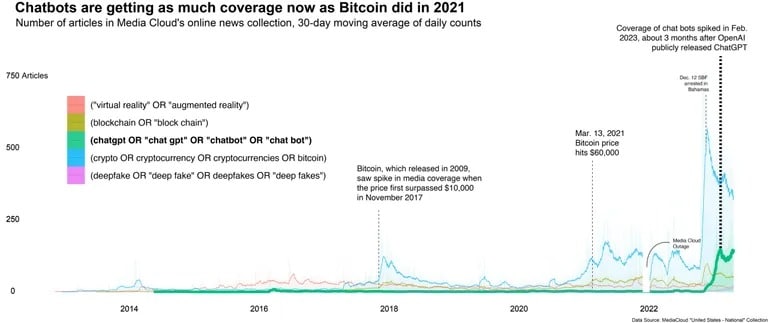

La question d’un éventuel Foom de l’IA (dans lequel une IA devient capable d’améliorer ses propres systèmes, augmentant ses capacités au point de surpasser l’intelligence humaine) est discutée depuis des années. Cependant, le rythme rapide des changements actuels, associé à une couverture médiatique importante, a propulsé le débat sous les feux de la rampe.

Source : Columbia Journalism Review

Cela a généré des opinions diverses sur la manière dont l’IA aura (et non simplement pourrait avoir) un impact sur l’avenir des interactions sociales.

Certains envisagent une ère utopique où l’IA et les humains alignés interagissent et où le progrès technologique règne en maître. D’autres pensent que l’humanité s’adaptera à l’IA et que de nouveaux emplois seront créés autour de la technologie, à l’instar de la croissance de l’emploi qui a suivi l’invention de l’automobile. D’autres encore affirment que l’IA a de grandes chances de mûrir et de devenir incontrôlable, constituant ainsi une véritable menace pour l’humanité.

D’ici là, le monde de l’IA continue de fonctionner comme si de rien n’était. Gardez un œil sur votre ChatGPT, votre Bard ou votre Siri – ils ne sont peut-être qu’à une mise à jour logicielle de dominer le monde. Mais pour l’instant, il semble que la plus grande menace pour l’humanité ne soit pas nos propres inventions, mais plutôt notre talent illimité pour l’hyperbole.