Смиритесь: ИИ может привести к вымиранию человечества.

Во вторник сотни лидеров индустрии ИИ и исследователей, включая руководителей Microsoft, Google и OpenAI, выступили с отрезвляющим предупреждением.

[…] […]

[…] […] […]

В письме, опубликованном Центром безопасности ИИ, специалисты по ИИ предложили следующее заявление, отличающееся суровой краткостью: «Снижение риска вымирания от ИИ должно стать глобальным приоритетом наряду с другими рисками общественного масштаба, такими как пандемии и ядерные войны».

Вот и все, это все, что они говорят.

Источник: Центр безопасности искусственного интеллекта

В заявлении ИИ рисуется как неотвратимая угроза, подобная ядерной катастрофе или глобальной пандемии. Но подписанты, эти волшебники технологической индустрии, не смогли расширить свое зловещее предупреждение.

Как именно будет происходить этот сценарий конца света? Когда мы должны отметить в календаре пришествие наших роботов-надсмотрщиков? Почему ИИ, изобретение человеческих инноваций, может обернуться против своих создателей? Эти архитекторы искусственного интеллекта хранили гробовое молчание и не давали никаких ответов.

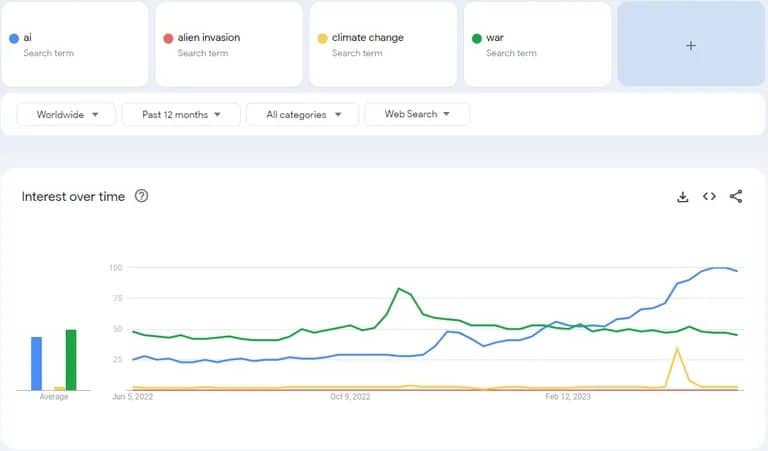

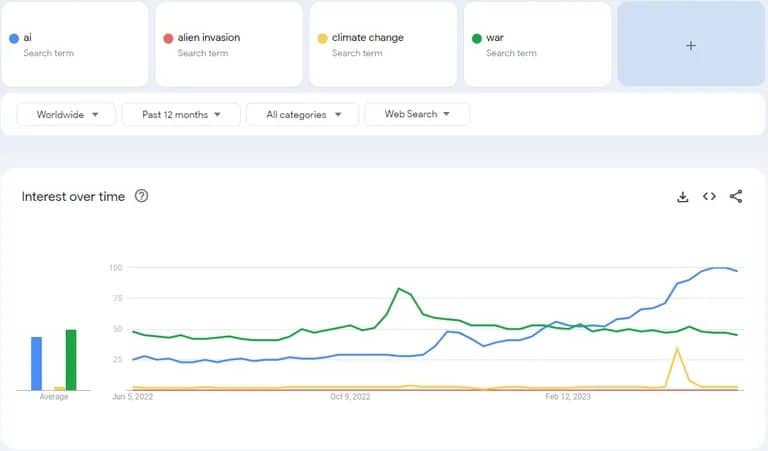

Действительно, эти лидеры отрасли были не более информативны, чем чат-бот с консервированным ответом. В сфере глобальных угроз ИИ, похоже, внезапно вырвался вперед, опередив изменение климата, геополитические конфликты и даже вторжение инопланетян по количеству поисковых запросов в Google по ключевым словам.

Интересно, что компании склонны выступать в поддержку нормативных актов, когда они соответствуют их интересам. Это можно рассматривать как их способ сказать: «Мы хотим иметь руку в формировании этих правил». Это похоже на то, как лиса подает петицию о введении новых правил в курятнике.

Также примечательно, что генеральный директор OpenAI Сэм Альтман настаивает на принятии правил в США. Тем не менее, он пригрозил покинуть Европу, если политики континента будут и дальше пытаться регулировать ИИ. «Мы постараемся соответствовать требованиям», — сказал Альтман на заседании в Университетском колледже Лондона. «Если мы сможем соответствовать, мы это сделаем. А если не сможем, то прекратим свою деятельность».

Справедливости ради надо сказать, что через несколько дней он пошел на попятную, заявив, что OpenAI не планирует покидать Европу. Это, конечно, произошло после того, как он получил возможность обсудить этот вопрос с регулирующими органами на «очень продуктивной неделе».

очень продуктивная неделя разговоров в Европе о том, как лучше регулировать ИИ! мы рады продолжать работать здесь и, конечно, не планируем уезжать.

— Сэм Альтман (@sama) 26 мая 2023

АИ рискованно, но так ли это рискованно?

Потенциальная опасность искусственного интеллекта не осталась незамеченной среди экспертов. В предыдущем открытом письме, которое подписали 31 810 человек, включая Элона Маска, Стива Возняка, Юваля Харари и Эндрю Янга, содержался призыв сделать паузу в обучении мощных моделей ИИ.

«Эти протоколы должны гарантировать, что системы, придерживающиеся их, безопасны вне всяких разумных сомнений», — говорится в письме, уточняя, что «это не означает паузу в развитии ИИ в целом, а лишь отступление от опасной гонки за все более крупными непредсказуемыми моделями «черного ящика» с эмерджентными возможностями. «

Проблема потенциального Foom ИИ (когда ИИ становится способным совершенствовать свои собственные системы, увеличивая свои возможности до такой степени, что превосходит человеческий интеллект) обсуждается уже много лет. Однако стремительные темпы сегодняшних изменений в сочетании со значительным освещением в СМИ привели к тому, что эта дискуссия оказалась в центре внимания мировой общественности.

Источник: Columbia Journalism Review

Это породило различные мнения о том, как ИИ повлияет (а не просто может повлиять) на будущее социальных взаимодействий.

Некоторые представляют себе утопическую эпоху, когда ИИ и люди будут взаимодействовать, а технологический прогресс будет господствовать. Другие считают, что человечество приспособится к ИИ, и вокруг технологии появятся новые рабочие места, подобно росту занятости, последовавшему за изобретением автомобиля. Другие же считают, что у ИИ есть все шансы созреть и стать неконтролируемым, представляя реальную угрозу для человечества.

А пока в мире ИИ все идет своим чередом. […] […] Они утверждают, что технологии искусственного интеллекта, которые они разрабатывают, могут однажды создать реальную и настоящую угрозу для существования человечества. Наряду с такими ужасами, как пандемии и ядерные войны, они считают ИИ риском для общества такого же масштаба.

В письме, опубликованном Центром безопасности ИИ, специалисты по ИИ предложили следующее заявление, отличающееся суровой краткостью: «Снижение риска вымирания от ИИ должно стать глобальным приоритетом наряду с другими рисками общественного масштаба, такими как пандемии и ядерные войны».

Вот и все, это все, что они говорят.

Источник: Центр безопасности искусственного интеллекта

В заявлении ИИ рисуется как неотвратимая угроза, подобная ядерной катастрофе или глобальной пандемии. Но подписанты, эти волшебники технологической индустрии, не смогли расширить свое зловещее предупреждение.

Как именно будет происходить этот сценарий конца света? Когда мы должны отметить в календаре пришествие наших роботов-надсмотрщиков? Почему ИИ, изобретение человеческих инноваций, может обернуться против своих создателей? Эти архитекторы искусственного интеллекта хранили гробовое молчание и не давали никаких ответов.

Действительно, эти лидеры отрасли были не более информативны, чем чат-бот с консервированным ответом. В сфере глобальных угроз ИИ, похоже, внезапно вырвался вперед, опередив изменение климата, геополитические конфликты и даже вторжение инопланетян по количеству поисковых запросов в Google по ключевым словам.

Интересно, что компании склонны выступать в поддержку нормативных актов, когда они соответствуют их интересам. Это можно рассматривать как их способ сказать: «Мы хотим иметь руку в формировании этих правил». Это похоже на то, как лиса подает петицию о введении новых правил в курятнике.

Также примечательно, что генеральный директор OpenAI Сэм Альтман настаивает на принятии правил в США. Тем не менее, он пригрозил покинуть Европу, если политики континента будут и дальше пытаться регулировать ИИ. «Мы постараемся соответствовать требованиям», — сказал Альтман на заседании в Университетском колледже Лондона. «Если мы сможем соответствовать, мы это сделаем. А если не сможем, то прекратим свою деятельность».

Справедливости ради надо сказать, что через несколько дней он пошел на попятную, заявив, что OpenAI не планирует покидать Европу. Это, конечно, произошло после того, как он получил возможность обсудить этот вопрос с регулирующими органами на «очень продуктивной неделе».

очень продуктивная неделя разговоров в Европе о том, как лучше регулировать ИИ! мы рады продолжать работать здесь и, конечно, не планируем уезжать.

— Сэм Альтман (@sama) 26 мая 2023

АИ рискованно, но так ли это рискованно?

Потенциальная опасность искусственного интеллекта не осталась незамеченной среди экспертов. В предыдущем открытом письме, которое подписали 31 810 человек, включая Элона Маска, Стива Возняка, Юваля Харари и Эндрю Янга, содержался призыв сделать паузу в обучении мощных моделей ИИ.

«Эти протоколы должны гарантировать, что системы, придерживающиеся их, безопасны вне всяких разумных сомнений», — говорится в письме, уточняя, что «это не означает паузу в развитии ИИ в целом, а лишь отступление от опасной гонки за все более крупными непредсказуемыми моделями «черного ящика» с эмерджентными возможностями. «

Проблема потенциального Foom ИИ (когда ИИ становится способным совершенствовать свои собственные системы, увеличивая свои возможности до такой степени, что превосходит человеческий интеллект) обсуждается уже много лет. Однако стремительные темпы сегодняшних изменений в сочетании со значительным освещением в СМИ привели к тому, что эта дискуссия оказалась в центре внимания мировой общественности.

Источник: Columbia Journalism Review

Это породило различные мнения о том, как ИИ повлияет (а не просто может повлиять) на будущее социальных взаимодействий.

Некоторые представляют себе утопическую эпоху, когда ИИ и люди будут взаимодействовать, а технологический прогресс будет господствовать. Другие считают, что человечество приспособится к ИИ, и вокруг технологии появятся новые рабочие места, подобно росту занятости, последовавшему за изобретением автомобиля. Другие же считают, что у ИИ есть все шансы созреть и стать неконтролируемым, представляя реальную угрозу для человечества.

А пока в мире ИИ все идет своим чередом. Следите за своим ChatGPT, Bard или Siri — возможно, они находятся всего в одном обновлении программного обеспечения от того, чтобы править миром. Но пока, похоже, самую большую угрозу человечеству представляют не наши собственные изобретения, а наш безграничный талант к гиперболе.