A medida que proliferan en Internet fotos y vídeos realistas generados por IA, las empresas tecnológicas y los grupos de vigilancia se apresuran a desarrollar herramientas para identificar los contenidos falsos.

La marca de agua en las imágenes generadas por ordenador es una solución comúnmente propuesta, añadiendo una bandera invisible en forma de metadatos ocultos que ayudan a revelar que una imagen fue creada utilizando una herramienta de IA generativa. Pero los investigadores han descubierto que este tipo de marca de agua tiene un fallo importante: las técnicas adversarias pueden eliminarla fácilmente.

Ahora, los principales fabricantes de cámaras proponen un enfoque diferente, en cierto modo el opuesto: incrustar marcas de agua en fotografías «reales».

Nikon, Sony y Canon acaban de anunciar una iniciativa conjunta para incluir firmas digitales en las imágenes tomadas directamente con sus cámaras sin espejo de gama alta. Según Nikkei Asia, las firmas integrarán metadatos clave como la fecha, la hora, la ubicación GPS y los datos del fotógrafo, certificando criptográficamente el origen digital de cada foto.

Nikon ha anunciado que lanzará esta función en su próxima gama de cámaras profesionales sin espejo; Sony publicará actualizaciones de firmware para insertar firmas digitales en sus actuales cámaras sin espejo; y Canon tiene previsto presentar cámaras con autenticación integrada en 2024, junto con marcas de agua en vídeo ese mismo año.

El objetivo, según Nikkei, es proporcionar a fotoperiodistas, profesionales de los medios de comunicación y artistas una prueba irrefutable de la credibilidad de sus imágenes. Las firmas a prueba de manipulaciones no desaparecerán con las ediciones y deberían ayudar a combatir la desinformación y el uso fraudulento de fotos en Internet.

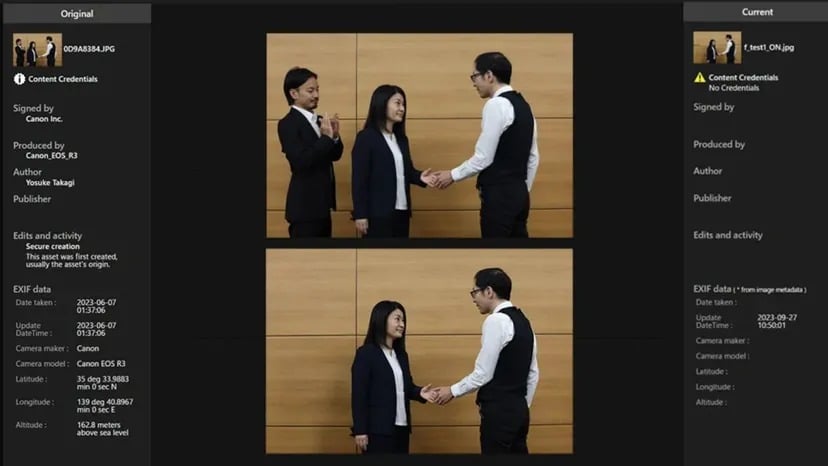

Para ello, las empresas han colaborado en un estándar abierto de firmas digitales interoperables llamado «Verify». Una vez implantado, las fotos tomadas con el hardware adecuado podrán comprobarse en línea de forma gratuita para que la gente pueda determinar si una foto es auténtica o no.

Si una foto generada por inteligencia artificial intenta pasar el sistema Verify sin una firma auténtica, se marcará como «Sin credenciales de contenido».

Fuente: Canon

En lugar de marcar retroactivamente el contenido de la IA, el plan autentica directamente las fotos reales en origen. Pero como cualquier otro sistema de marcas de agua, su éxito dependerá de una adopción generalizada (que más fabricantes de hardware incorporen el estándar) y de una implementación a prueba de tiempo (que el código evolucione para seguir siendo inhackeable).

Como informó TCN, investigaciones recientes indican que las técnicas antimarcas de agua también podrían comprometer las firmas incrustadas, inutilizando los métodos actuales de marcado de agua. Sin embargo, esto sólo hace que las imágenes con marca de agua no lo sean, por lo que la gente tiene menos herramientas para detectar su artificialidad.

Aunque las técnicas contra las marcas de agua podrían eliminar las firmas de autenticidad de las fotos reales, esto es menos problemático que eliminar las marcas de agua de las imágenes falsas generadas por IA. ¿Por qué? Si se elimina una marca de agua de una deepfake generada por IA, el contenido falsificado puede pasar por real más fácilmente. Sin embargo, si se piratean las firmas de autenticación de fotos reales, la imagen restante sigue siendo capturada por una cámara, no procede de un modelo generativo. Aunque pierda su prueba criptográfica, el contenido subyacente sigue siendo auténtico.

El principal riesgo en este caso está relacionado con la atribución y la gestión de derechos, no con la veracidad del contenido. La imagen podría estar mal acreditada o utilizarse sin la licencia adecuada, pero no engaña intrínsecamente a los espectadores sobre la realidad que representa.

OpenAI ha anunciado recientemente un detector de imágenes falsas basado en IA que, según afirma, tiene una precisión del 99%. Sin embargo, los detectores de IA siguen siendo imperfectos y deben actualizarse constantemente para superar la evolución de la tecnología generativa.

El reciente aumento de la sofisticación de las falsificaciones profundas ha puesto de relieve la necesidad de este tipo de estrategias. Como hemos visto en 2023, la necesidad de diferenciar entre contenido real e inventado nunca ha sido tan acuciante. Tanto los políticos como los desarrolladores de tecnología se afanan por encontrar soluciones viables, por lo que una pequeña ayuda de estas empresas sería de agradecer.