La tecnología ha hecho mucho por ayudar en esos momentos en los que se te escapa la lengua y tienes que nombrar esa melodía. Gracias a la IA, ahora ni siquiera es necesario cantar o tararear una canción: basta con pensar en ella.

Ese es el futuro que los científicos se proponen después de que un innovador estudio haya utilizado con éxito la inteligencia artificial (IA) para recrear música simplemente a partir del escaneo de la actividad cerebral mientras se pensaba en una canción.

En un artículo publicado en PLOS Biology, investigadores dirigidos por la Universidad de California en Berkeley fueron capaces de generar un audio reconocible de «Another Brick in the Wall, Part 1» de Pink Floyd utilizando únicamente datos del cerebro.

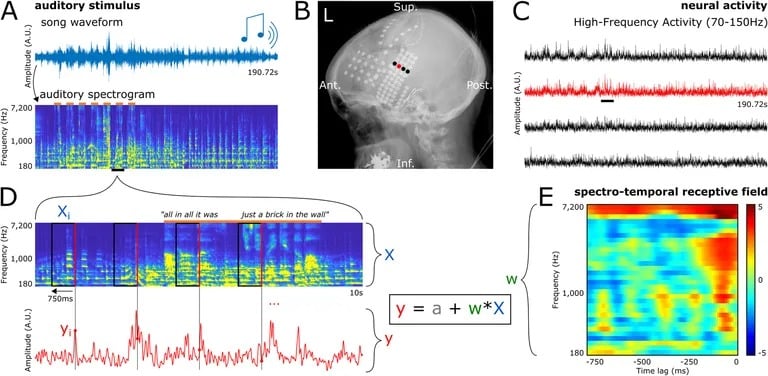

El estudio consistió en grabar señales eléctricas directamente del cerebro de pacientes con epilepsia ya sometidos a monitorización para el tratamiento de las crisis. Mientras los pacientes escuchaban pasivamente la clásica canción de rock, unos electrodos situados en la superficie de sus cerebros captaban la actividad de las regiones de procesamiento auditivo.

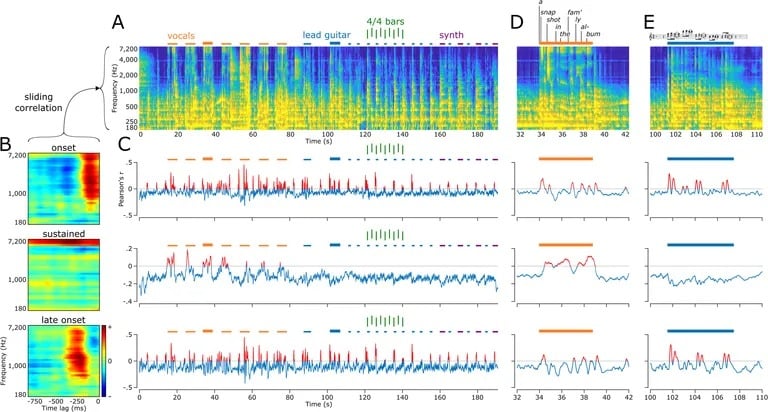

Los investigadores introdujeron estos datos cerebrales en algoritmos de aprendizaje automático. Analizando los patrones de reacción de las distintas áreas de la corteza auditiva ante componentes como el tono, el tempo, las voces y los instrumentos, los modelos de IA aprendieron a asociar una actividad neuronal específica con determinadas características acústicas.

Una vez entrenados en estos emparejamientos de entrada-respuesta, los modelos fueron capaces de generar nuevas representaciones espectrográficas a partir únicamente de datos cerebrales. A continuación, los investigadores convirtieron estas visualizaciones en formas de onda, produciendo un audio que, aunque confuso, se parecía claramente a «Another Brick in the Wall, Part 1».

No sólo podían identificarse la melodía y la letra, sino que la decodificación neuronal reflejaba incluso qué instrumentos provocaban determinadas respuestas en distintas regiones del cerebro. Por ejemplo, la actividad en ciertas partes de la circunvolución temporal superior fluctuaba específicamente como reacción a las sílabas vocales. Mientras tanto, otras áreas se activaban más en respuesta a los motivos de guitarra de ritmo constante de la canción.

Esto demuestra la capacidad de descomponer un estímulo musical complejo en sus partes constituyentes basándose únicamente en el procesamiento cerebral. De confirmarse en futuras investigaciones, supondría un enorme salto adelante en la descodificación del pensamiento, ya que las técnicas anteriores se limitaban a palabras o letras sueltas.

El autor principal, el Dr. Robert Knight, neurocientífico de la Universidad de Berkeley, explicó que el equipo eligió la canción de Pink Floyd por su rica instrumentación en capas. Pero el método podría aplicarse a cualquier tipo de música, o incluso a captar las propiedades melódicas del habla natural.

Los investigadores sugieren que esta tecnología podría llegar a utilizarse para ayudar a pacientes con parálisis severa o víctimas de derrames cerebrales a recuperar la capacidad de hablar simplemente con el pensamiento. Ya se están desarrollando interfaces cerebro-ordenador para descodificar palabras o textos a partir de escáneres cerebrales no invasivos. Añadir la dimensión de la melodía y la prosodia permitiría reconstruir pensamientos más completos y la intención del habla.

Los investigadores llevan años avanzando en este campo de la lectura de la mente, y el auge de potentes modelos de inteligencia artificial (y hardware) ha hecho posible importantes avances en este campo.

En mayo, un equipo de investigadores fue capaz de convertir pensamientos en texto. «Nos sorprendió que funcionara tan bien. Llevo 15 años trabajando en esto… así que fue chocante y emocionante cuando por fin funcionó», dijo el autor principal, el Dr. Alexander Huth, neurocientífico de la Universidad de Texas en Austin.

Además, TCN informó recientemente de que un equipo médico implantó con éxito microchips en el cerebro de un hombre tetrapléjico y fue capaz de utilizar la IA para recuperar la sensibilidad y el movimiento «(revinculando) su cerebro a su cuerpo y médula espinal».

Además, Neuralink, de Elon Musk, ha recibido luz verde para comenzar los ensayos en humanos de sus implantes cerebrales y llevar este campo de investigación a nuevas fronteras. Neuralink ya ha afirmado que es capaz de leer los pensamientos de un animal y permitir que un mono controle un ordenador y juegue al Pong utilizando sólo el cerebro.

Aún quedan retos por superar para trasladar estos resultados a aplicaciones del mundo real. Pero los autores confían en que, con los rápidos avances en los dispositivos de grabación y las capacidades de la IA, su método pueda evolucionar algún día hacia interfaces pensamiento-voz que devuelvan la voz a los discapacitados del habla.

«Hoy hemos reconstruido una canción», declaró a Scientific American Robert T. Knight, uno de los investigadores. «Quizá mañana podamos reconstruir el álbum entero de Pink Floyd».

Más allá de los usos clínicos, estas técnicas de descodificación neuronal abren también interesantes posibilidades para estudiar fenómenos como la memoria, el aprendizaje y la creatividad, leyendo literalmente los pensamientos con alta fidelidad. El estudio del equipo de la UC Berkeley representa un momento decisivo, que nos acerca al acceso a la rica experiencia interior de la mente.