La tecnologia ha fatto molto per aiutare i momenti in cui si sente la punta della lingua e si sente il nome di una canzone. Grazie all’intelligenza artificiale, ora non c’è nemmeno bisogno di cantare o canticchiare una canzone: basta pensarci.

Questo è il futuro che gli scienziati stanno prospettando dopo che uno studio innovativo ha utilizzato con successo l’intelligenza artificiale (IA) per ricreare la musica semplicemente scansionando l’attività cerebrale mentre si pensava a una canzone.

In un articolo pubblicato su PLOS Biology, i ricercatori guidati dall’Università della California di Berkeley sono stati in grado di generare un audio riconoscibile di “Another Brick in the Wall, Part 1” dei Pink Floyd utilizzando solo dati provenienti dal cervello.

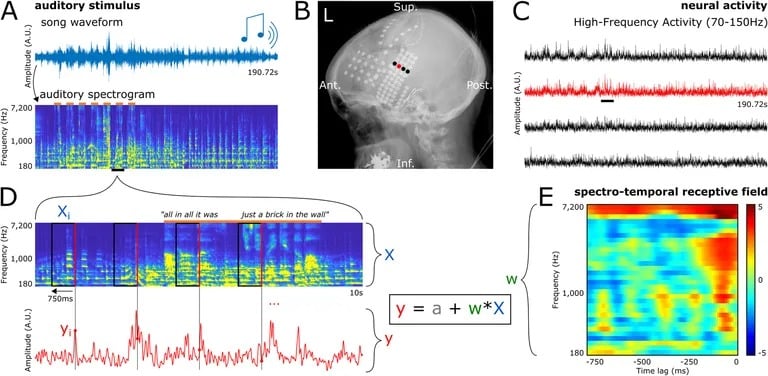

Lo studio ha previsto la registrazione di segnali elettrici direttamente dal cervello di pazienti affetti da epilessia già sottoposti a monitoraggio per il trattamento delle crisi. Mentre i pazienti ascoltavano passivamente la canzone rock classica, gli elettrodi sulla superficie del loro cervello hanno catturato l’attività delle regioni di elaborazione uditiva.

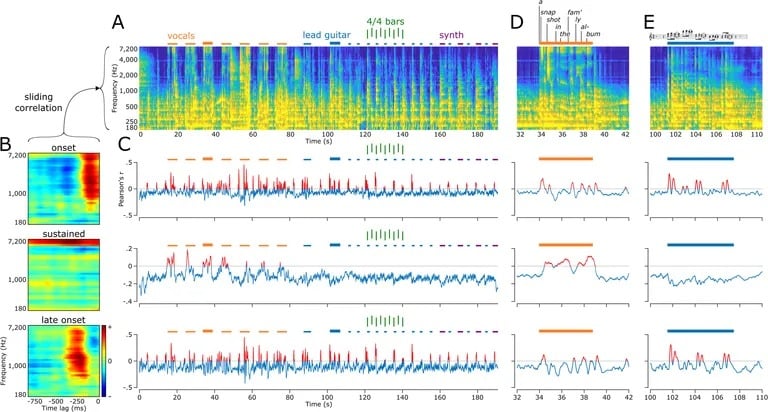

I ricercatori hanno quindi inserito questa serie di dati cerebrali in algoritmi di apprendimento automatico. Analizzando i modelli di reazione delle diverse aree della corteccia uditiva a componenti come l’intonazione, il tempo, le voci e gli strumenti, i modelli di intelligenza artificiale hanno imparato ad associare un’attività neurale specifica a particolari caratteristiche acustiche.

Una volta addestrati su queste coppie ingresso-risposta, i modelli sono stati in grado di generare nuove rappresentazioni spettrografiche dai soli dati cerebrali. I ricercatori hanno poi convertito queste visualizzazioni in forme d’onda, producendo un audio che, sebbene confuso, assomigliava chiaramente a “Another Brick in the Wall, Part 1”.

Non solo la melodia e il testo erano identificabili, ma la decodifica neurale rifletteva anche quali strumenti suscitavano determinate risposte nelle diverse regioni cerebrali. Per esempio, l’attività in alcune parti del giro temporale superiore fluttuava in modo specifico in reazione alle sillabe vocali. Altre aree, invece, si attivavano maggiormente in risposta ai motivi ritmici e costanti della chitarra.

Questo dimostra la capacità di scomporre uno stimolo musicale complesso nelle sue parti costitutive basandosi esclusivamente sull’elaborazione cerebrale. Se confermata da ricerche future, rappresenta un enorme balzo in avanti nella decodifica dei pensieri, dato che le tecniche precedenti si limitavano a singole parole o lettere.

L’autore senior, il neuroscienziato dell’UC Berkeley Robert Knight, ha spiegato che il team ha scelto la canzone dei Pink Floyd proprio per la sua strumentazione ricca e stratificata. Ma l’approccio potrebbe essere applicato a qualsiasi musica, o anche alla cattura delle proprietà melodiche del parlato naturale.

I ricercatori suggeriscono che questa tecnologia potrebbe essere utilizzata per aiutare i pazienti gravemente paralizzati o colpiti da ictus a riacquistare la capacità di parlare semplicemente pensando. Sono già in fase di sviluppo interfacce cervello-computer per decodificare parole o testi da scansioni cerebrali non invasive. L’aggiunta della dimensione della melodia e della prosodia consentirebbe di ricostruire i pensieri più completi e le intenzioni del discorso.

Inoltre, Neuralink di Elon Musk ha ottenuto il via libera per iniziare la sperimentazione sull’uomo dei suoi impianti cerebrali per portare questo campo di ricerca verso nuove frontiere. Neuralink ha già dichiarato di essere in grado di leggere i pensieri di un animale e di permettere a una scimmia di controllare un computer e di giocare a Pong usando solo il cervello.

La traduzione di questi risultati in applicazioni reali è ancora difficile. Ma gli autori sperano che, con i rapidi progressi dei dispositivi di registrazione e delle capacità dell’intelligenza artificiale, il loro approccio possa un giorno evolversi in interfacce pensiero-parlato che restituiscano la voce ai non udenti.

“Oggi abbiamo ricostruito una canzone”, ha dichiarato a Scientific American Robert T. Knight, uno dei ricercatori. “Forse domani potremo ricostruire l’intero album dei Pink Floyd”.

Al di là degli usi clinici, queste tecniche di decodifica neurale aprono anche interessanti possibilità di studio di fenomeni come la memoria, l’apprendimento e la creatività, leggendo letteralmente i pensieri con alta fedeltà. Lo studio dell’équipe dell’UC Berkeley rappresenta una svolta, che ci avvicina all’accesso alla ricca esperienza interiore della mente.