Komunita umělé inteligence má nové pero v klobouku, když byl vydán Falcon 180B, open-source velký jazykový model (LLM), který se může pochlubit 180 miliardami parametrů natrénovaných na hromadě dat. Tento výkonný nováček překonal předchozí open-source LLM na několika frontách.

Model Falcon 180B byl zveřejněn v příspěvku na blogu komunity Hugging Face AI na webu Hugging Face Hub. Architektura nejnovějšího modelu vychází z předchozí řady open source LLM Falcon a využívá inovace, jako je pozornost na více dotazů, ke škálování až na 180 miliard parametrů natrénovaných na 3,5 bilionu tokenů.

To představuje doposud nejdelší předtrénování modelu s jedinou epochou u modelu s otevřeným zdrojovým kódem. K dosažení těchto hodnot bylo současně použito 4 096 grafických procesorů po dobu přibližně 7 milionů GPU hodin, přičemž k trénování a zpřesňování byl použit Amazon SageMaker.

Pro představu o velikosti modelu Falcon 180B je třeba uvést, že jeho parametry měří 2,5krát více než model LLaMA 2 společnosti Meta. LLaMA 2 byl dříve po svém uvedení na trh na začátku tohoto roku považován za nejschopnější open-source LLM a mohl se pochlubit 70 miliardami parametrů natrénovaných na 2 bilionech tokenů.

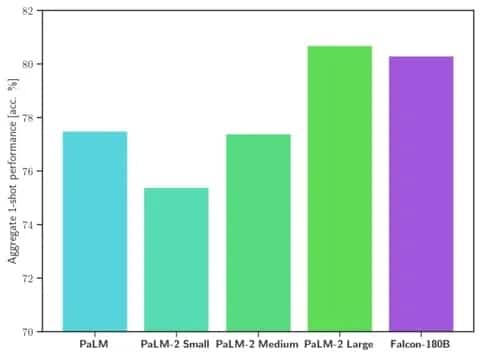

Falcon 180B překonává LLaMA 2 a další modely jak v rozsahu, tak ve výkonnosti benchmarků v celé řadě úloh zpracování přirozeného jazyka (NLP). V žebříčku modelů s otevřeným přístupem se umístil na 68,74 bodu a v hodnoceních, jako je benchmark HellaSwag, dosahuje téměř stejné úrovně jako komerční modely, například PaLM-2 společnosti Google.

Obrázek: Objímající se tvář

Konkrétně Falcon 180B odpovídá nebo překonává PaLM-2 Medium v běžně používaných benchmarcích, včetně HellaSwag, LAMBADA, WebQuestions, Winogrande a dalších. V podstatě je na stejné úrovni jako PaLM-2 Large od společnosti Google. To představuje na model s otevřeným zdrojovým kódem mimořádně vysoký výkon, a to i ve srovnání s řešeními vyvinutými giganty v oboru.

Při srovnání s ChatGPT je model výkonnější než bezplatná verze, ale o něco méně schopný než placená služba „plus“.

„Falcon 180B se v závislosti na hodnotícím benchmarku typicky pohybuje někde mezi GPT 3.5 a GPT4 a další dolaďování ze strany komunity bude velmi zajímavé sledovat nyní, když je otevřeně uvolněn,“ píše se na blogu.

Vydání Falconu 180B představuje poslední skok v rychlém pokroku, kterého bylo v poslední době dosaženo v oblasti LLM. Kromě samotného škálování parametrů umožnily techniky jako LoRA, randomizace vah a Perfusion společnosti Nvidia výrazně efektivnější trénování velkých modelů umělé inteligence.

Vzhledem k tomu, že Falcon 180B je nyní volně k dispozici na portálu Hugging Face, vědci předpokládají, že model zaznamená další přínosy díky dalším vylepšením vyvinutým komunitou. Nicméně jeho demonstrace pokročilých schopností v oblasti přirozeného jazyka hned na začátku znamená vzrušující vývoj pro open-source AI.