オープンソースの大規模言語モデル(LLM)であるFalcon 180Bがリリースされ、人工知能コミュニティに新たな羽が生えた。この強力な新参者は、いくつかの面で先行するオープンソースのLLMを凌駕している。

Hugging Face AIコミュニティによるブログ投稿で発表されたFalcon 180Bは、Hugging Face Hubでリリースされた。最新のモデル・アーキテクチャは、以前のオープンソースLLMのFalconシリーズをベースにしており、マルチクエリー・アテンションのようなイノベーションを活用し、3兆5000億トークンに対して学習された1800億パラメータまでスケールアップする。

これは、オープンソースモデルとしてはこれまでで最長のシングルエポック事前学習となります。このような記録を達成するために、4,096個のGPUが同時に使用され、約700万GPU時間が費やされました。

Falcon 180Bのサイズを考慮すると、そのパラメータはMetaのLLaMA 2モデルよりも2.5倍大きい。LLaMA 2は、今年初めに発表された後、最も高性能なオープンソースのLLMとみなされており、2兆のトークンで訓練された700億のパラメータを誇っていた。

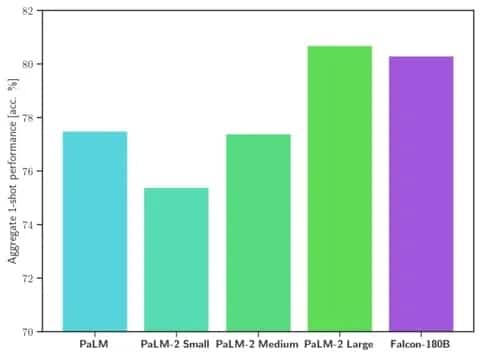

Falcon 180Bは、さまざまな自然言語処理(NLP)タスクにおいて、スケールとベンチマーク性能の両方でLLaMA 2や他のモデルを上回っている。オープンアクセスモデルでは68.74ポイントでリーダーボードにランクインし、HellaSwagベンチマークのような評価ではGoogleのPaLM-2のような商用モデルとほぼ同等に達している

。

画像: ハグする顔

具体的には、ファルコン180Bは、HellaSwag、LAMBADA、WebQuestions、Winograndeなどを含む一般的に使用されるベンチマークにおいて、PaLM-2 Mediumと同等かそれ以上です。基本的にはグーグルのPaLM-2 Largeと同等です。これは、業界の巨人が開発したソリューションと比較しても、オープンソースモデルとしては非常に強力なパフォーマンスを示しています。

ChatGPTと比較した場合、このモデルは無料版よりも強力ですが、有料の「プラス」サービスよりは少し能力が劣ります。

「ファルコン180Bは通常、評価ベンチマークによってGPT3.5とGPT4の間のどこかに位置し、公開された今、コミュニティからのさらなる微調整は非常に興味深いものとなるでしょう。

Falcon 180Bのリリースは、最近のLLMの急速な進歩における最新の飛躍を象徴している。単にパラメーターをスケールアップするだけでなく、LoRA、重みのランダム化、NvidiaのPerfusionのような技術は、大規模なAIモデルの劇的に効率的な学習を可能にしている。

ファルコン180Bは現在ハギング・フェイスで自由に利用可能であり、研究者たちは、コミュニティによって開発されたさらなる機能強化によって、このモデルがさらなる進歩を遂げることを期待している。しかし、ゲートからすぐに高度な自然言語能力を実証したことは、オープンソースAIにとってエキサイティングな進展となった。