È stata una storia di spionaggio aziendale che nemmeno uno sceneggiatore umano avrebbe potuto immaginare. OpenAI, che l’anno scorso ha scatenato l’ossessione globale per l’IA, si è ritrovata sulle prime pagine dei giornali per l’improvviso licenziamento e l’eventuale reintegrazione di Sam Altman, l’amministratore delegato dell’azienda.

Anche se Altman è tornato al suo posto, rimane una nuvola vorticosa di domande, tra cui cosa è successo dietro le quinte.

Alcuni hanno descritto il caos come una battaglia a livello di “Succession” o “Game of Thrones” della HBO. Altri hanno ipotizzato che ciò sia avvenuto perché Altman ha spostato la sua attenzione su altre società, come Worldcoin.

Ma l’ultima teoria, la più convincente, dice che è stato licenziato a causa di una singola lettera: Q.

Fonti non citate hanno riferito a Reuters che il CTO di OpenAI, Mira Murati, ha dichiarato che un’importante scoperta, descritta come “Q Star” o “Q*”, è stata la causa del licenziamento di Altman, eseguito senza la partecipazione del presidente del consiglio di amministrazione Greg Brockman, che si è poi dimesso da OpenAI per protesta.

Che cos’è “Q*” e perché dovrebbe interessarci? Si tratta dei percorsi più probabili che lo sviluppo dell’intelligenza artificiale potrebbe intraprendere da qui in poi.

Svelare il mistero di Q*

L’enigmatica Q* citata da Mira Murati, CTO di OpenAI, ha dato vita a una serie di speculazioni nella comunità dell’IA. Questo termine potrebbe riferirsi a una delle due distinte teorie: Q-learning o l’algoritmo Q* del Maryland Refutation Proof Procedure System (MRPPS). Capire la differenza tra queste due teorie è fondamentale per comprendere il potenziale impatto di Q*.

Teoria 1: Q-Learning

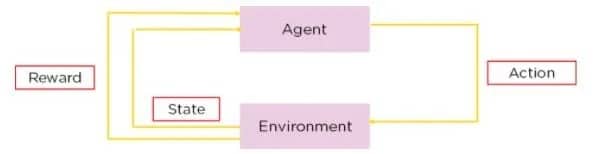

L’apprendimento Q è un tipo di apprendimento per rinforzo, un metodo in cui l’intelligenza artificiale impara a prendere decisioni per tentativi ed errori. Nell’apprendimento Q, un agente impara a prendere decisioni stimando la “qualità” delle combinazioni azione-stato.

Fonte: Simplilearn

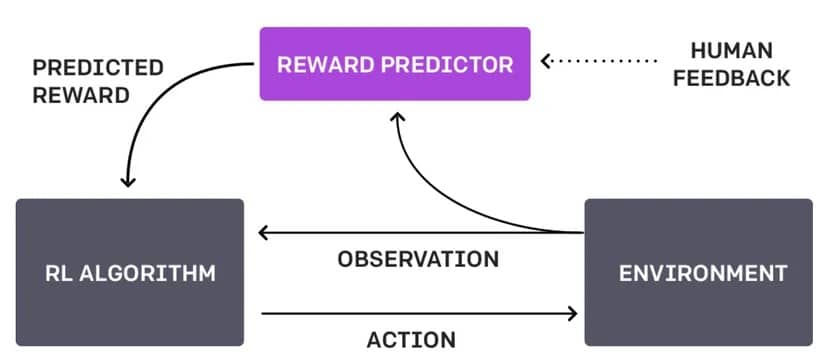

La differenza tra questo approccio e quello attuale di OpenAI, noto come Reinforcement Learning Through Human Feedback o RLHF, è che non si basa sull’interazione umana e fa tutto da solo.

Diagramma RLHF. Immagine: OpenAI

Immaginate un robot che naviga in un labirinto. Con l’apprendimento Q, impara a trovare il percorso più rapido per l’uscita provando diversi percorsi, ricevendo ricompense positive stabilite dal suo stesso progetto quando si avvicina all’uscita e ricompense negative quando si trova in un vicolo cieco. Nel corso del tempo, attraverso prove ed errori, il robot sviluppa una strategia (una “tabella Q”) che gli indica l’azione migliore da intraprendere da ogni posizione nel labirinto. Questo processo è autonomo e si basa sulle interazioni del robot con l’ambiente.

Se il robot utilizzasse la RLHF, invece di scoprire le cose da solo, un umano potrebbe intervenire quando il robot raggiunge un incrocio per indicare se la scelta del robot è stata saggia o meno.

Il feedback potrebbe essere sotto forma di comandi diretti (“gira a sinistra”), suggerimenti (“prova il percorso con più luce”) o valutazioni delle scelte del robot (“robot buono” o “robot cattivo”).

Nell’apprendimento Q, Q* rappresenta lo stato desiderato in cui un agente conosce esattamente l’azione migliore da intraprendere in ogni stato per massimizzare la sua ricompensa totale attesa nel tempo. In termini matematici, soddisfa l’equazione di Bellman.

A maggio OpenAI ha pubblicato un articolo in cui affermava di aver “addestrato un modello per raggiungere un nuovo stato dell’arte nella risoluzione di problemi matematici, premiando ogni fase corretta del ragionamento invece di premiare semplicemente la risposta finale corretta”. Se usassero il Q-learning o un metodo simile per raggiungere questo obiettivo, si aprirebbe un’intera nuova serie di problemi e situazioni che ChatGPT sarebbe in grado di risolvere in modo nativo.

Teoria 2: Algoritmo Q* da MRPPS

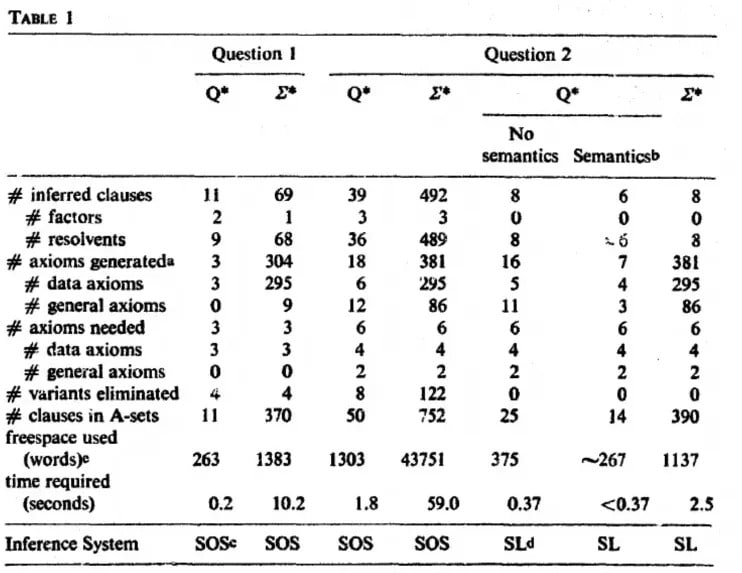

L’algoritmo Q* fa parte del Maryland Refutation Proof Procedure System (MRPPS). È un metodo sofisticato per la dimostrazione di teoremi nell’IA, in particolare nei sistemi di risposta alle domande.

“L’algoritmo Q∗ genera nodi nello spazio di ricerca, applicando informazioni semantiche e sintattiche per indirizzare la ricerca. La semantica permette di terminare i percorsi e di esplorare quelli fruttuosi”, si legge nel documento di ricerca.

Immagine: Jack Minker

Un modo per spiegare il processo è considerare il detective immaginario Sherlock Holmes che cerca di risolvere un caso complesso. Egli raccoglie indizi (informazioni semantiche) e li collega logicamente (informazioni sintattiche) per giungere a una conclusione. L’algoritmo Q* funziona in modo simile nell’IA, combinando informazioni semantiche e sintattiche per navigare in processi complessi di risoluzione dei problemi.

Ciò implica che OpenAI è un passo più vicino ad avere un modello in grado di comprendere la sua realtà al di là delle semplici indicazioni testuali e più in linea con il fittizio J.A.R.V.I.S (per i GenZers) o il Bat Computer (per i boomers).

Quindi, mentre l’apprendimento Q consiste nell’insegnare all’intelligenza artificiale a imparare dall’interazione con l’ambiente, l’algoritmo Q si occupa piuttosto di migliorare le capacità deduttive dell’intelligenza artificiale. Comprendere queste distinzioni è fondamentale per apprezzare le potenziali implicazioni di “Q” di OpenAI. Entrambi hanno un immenso potenziale per il progresso dell’IA, ma le loro applicazioni e implicazioni variano in modo significativo.

Tutto questo, naturalmente, è solo una speculazione, poiché OpenAI non ha spiegato il concetto né ha confermato o smentito le voci secondo cui Q*, qualunque cosa sia, esista davvero.

Potenziali implicazioni di “Q “*

La vociferata “Q*” di OpenAI potrebbe avere un impatto vasto e variegato. Se si tratta di una forma avanzata di apprendimento Q, potrebbe significare un salto di qualità nella capacità dell’IA di apprendere e adattarsi autonomamente in ambienti complessi, risolvendo un’intera nuova serie di problemi. Un tale progresso potrebbe migliorare le applicazioni dell’IA in settori come i veicoli autonomi, dove è fondamentale prendere decisioni in una frazione di secondo in base a condizioni in continua evoluzione.

D’altra parte, se “Q” si riferisce all’algoritmo Q di MRPPS, potrebbe segnare un significativo passo avanti nelle capacità di ragionamento deduttivo e di risoluzione dei problemi dell’IA. Ciò avrebbe un impatto particolare nei campi che richiedono un pensiero analitico profondo, come l’analisi legale, l’interpretazione di dati complessi e persino la diagnosi medica.

Indipendentemente dalla sua esatta natura, “Q*” rappresenta potenzialmente un passo avanti significativo nello sviluppo dell’IA, quindi il fatto che sia al centro di un dibattito esistenziale di OpenAI è vero. Potrebbe avvicinarci a sistemi di IA più intuitivi, efficienti e capaci di gestire compiti che attualmente richiedono alti livelli di competenza umana. Tuttavia, con questi progressi arrivano anche domande e preoccupazioni sull’etica dell’IA, sulla sicurezza e sulle implicazioni di sistemi di IA sempre più potenti nella nostra vita quotidiana e nella società in generale.

Il bene e il male di Q*

Potenziali vantaggi di Q*:

Miglioramento della risoluzione dei problemi e dell’efficienza: Se Q* è una forma avanzata di Q-learning o dell’algoritmo Q*, potrebbe portare a sistemi di IA in grado di risolvere problemi complessi in modo più efficiente, a vantaggio di settori come la sanità, la finanza e la gestione ambientale.

Migliore collaborazione tra uomo e IA: Un’IA con migliori capacità di apprendimento o deduttive potrebbe aumentare il lavoro umano, portando a una collaborazione più efficace nella ricerca, nell’innovazione e nelle attività quotidiane.

Progressi nell’automazione: “Q*” potrebbe portare a tecnologie di automazione più sofisticate, migliorando la produttività e creando potenzialmente nuove industrie e opportunità di lavoro.

Rischi e preoccupazioni:

Problemi etici e di sicurezza: Man mano che i sistemi di IA diventano più avanzati, garantire che operino in modo etico e sicuro diventa sempre più impegnativo. C’è il rischio di conseguenze indesiderate, soprattutto se le azioni dell’IA non sono perfettamente in linea con i valori umani.

Privacy e sicurezza: Con l’IA più avanzata, le preoccupazioni per la privacy e la sicurezza dei dati aumentano. I sistemi di IA in grado di comprendere e interagire più a fondo con i dati potrebbero essere utilizzati in modo improprio. Immaginate un’IA che chiama il vostro partner quando lo state tradendo perché sa che il tradimento è un male.

Impatto economico: L’aumento dell’automazione e delle capacità dell’IA potrebbe portare alla perdita di posti di lavoro in alcuni settori, rendendo necessari adeguamenti sociali e nuovi approcci allo sviluppo della forza lavoro. Se un’IA può fare quasi tutto, perché avere lavoratori umani?

Disallineamento dell’IA: Il rischio che i sistemi di IA sviluppino obiettivi o metodi operativi non allineati con le intenzioni o il benessere dell’uomo, con potenziali esiti dannosi. Immaginate un robot per le pulizie di casa che è ossessionato dall’ordine e continua a buttare via le vostre carte importanti? O che elimina completamente i creatori di disordine?

Il mito dell’AGI

Dove si colloca la vociferata Q* di OpenAI nell’ambito della ricerca dell’Intelligenza Generale Artificiale (AGI), il Santo Graal della ricerca sull’IA?

L’AGI si riferisce alla capacità di una macchina di comprendere, apprendere e applicare l’intelligenza in vari compiti, come le capacità cognitive umane. È una forma di IA in grado di generalizzare l’apprendimento da un dominio all’altro, dimostrando una vera adattabilità e versatilità.

Indipendentemente dal fatto che Q sia una forma avanzata di apprendimento Q o si riferisca all’algoritmo Q, è essenziale capire che questo non equivale a raggiungere l’AGI. Mentre la “Q*” potrebbe rappresentare un significativo passo avanti nelle capacità specifiche dell’intelligenza artificiale, l’intelligenza artificiale comprende una gamma più ampia di abilità e comprensione.

Raggiungere l’AGI significherebbe sviluppare un’IA in grado di svolgere qualsiasi compito intellettuale che un essere umano può svolgere, un traguardo inafferrabile.

Una macchina che ha raggiunto l’AGI non è consapevole della propria esistenza e non può ancora ragionare oltre i confini dei suoi dati di pre-addestramento e degli algoritmi impostati dall’uomo. Quindi no, nonostante il clamore, “Q” non è ancora il presagio dei nostri signori dell’intelligenza artificiale; è più simile a un tostapane intelligente che ha imparato a imburrare il proprio pane.

Per quanto riguarda le IA che inaugureranno la fine della civiltà, forse stiamo sopravvalutando la nostra importanza nell’ordine di importanza cosmico. Q* di OpenAI potrebbe essere un passo avanti verso l’IA dei nostri sogni (o incubi), ma non è ancora l’IA che si interrogherà sul significato della vita o sulla propria esistenza al silicio.

Ricordiamo che questa è la stessa OpenAI che ha osservato con cautela il suo ChatGPT come un genitore che osserva un bambino con un pennarello: orgogliosa, ma perennemente preoccupata di disegnare sui muri dell’umanità. Sebbene “Q*” sia un salto, l’AGI è ancora lontana, e il muro dell’umanità è al sicuro per ora.