Los principales modelos fundacionales de IA, como ChatGPT, Claude, Bard y LlaM-A-2, son cada vez menos transparentes, según un equipo de investigadores de la Universidad de Stanford.

El nuevo estudio procede del Center for Research on Foundation Models (CRFM) de la universidad, parte del Stanford Institute for Human-Centered Artificial Intelligence (HAI), que estudia y desarrolla modelos fundacionales de IA.

«Las empresas del ámbito de los modelos fundacionales son cada vez menos transparentes», afirma Rishi Bommasani, responsable de Sociedad del CRFM, según un comunicado de prensa oficial. Esta opacidad plantea retos tanto para las empresas como para los responsables políticos y los consumidores.

Las empresas que están detrás de los LLM más precisos y utilizados coinciden en que quieren hacer el bien, pero tienen puntos de vista diferentes en cuanto a la apertura y la transparencia.

OpenAI, por ejemplo, ha adoptado la falta de transparencia como una medida de precaución.

«Ahora creemos que estábamos equivocados en nuestro pensamiento original sobre la apertura, y hemos pasado de pensar que deberíamos publicarlo todo a pensar que deberíamos averiguar cómo compartir de forma segura el acceso y los beneficios de los sistemas», se lee en un blog oficial.

La investigación del MIT de 2020 muestra que esta ha sido una filosofía central durante un tiempo. «Sus relatos sugieren que OpenAI, a pesar de todas sus nobles aspiraciones, está obsesionada con mantener el secreto, proteger su imagen y conservar la lealtad de sus empleados», escribieron los investigadores.

Por su parte, los principales puntos de vista de Anthropic sobre la seguridad de la IA muestran el compromiso de la startup con «el tratamiento de sistemas de IA que sean transparentes e interpretables», y su enfoque en el establecimiento de «medidas de transparencia y procedimiento para garantizar el cumplimiento verificable de (sus) compromisos.» Además, en agosto de 2023, Google anunció el lanzamiento de un Centro de Transparencia para divulgar mejor sus políticas y abordar esta cuestión.

B

¿Pero por qué deberían preocuparse los usuarios por la transparencia de la IA?

«Una menor transparencia hace más difícil que otras empresas sepan si pueden crear aplicaciones seguras basadas en modelos comerciales; que los académicos confíen en modelos comerciales para la investigación; que los responsables políticos diseñen políticas significativas para frenar esta poderosa tecnología; y que los consumidores entiendan las limitaciones de los modelos o busquen compensación por los daños causados», argumenta el documento de Stanford.

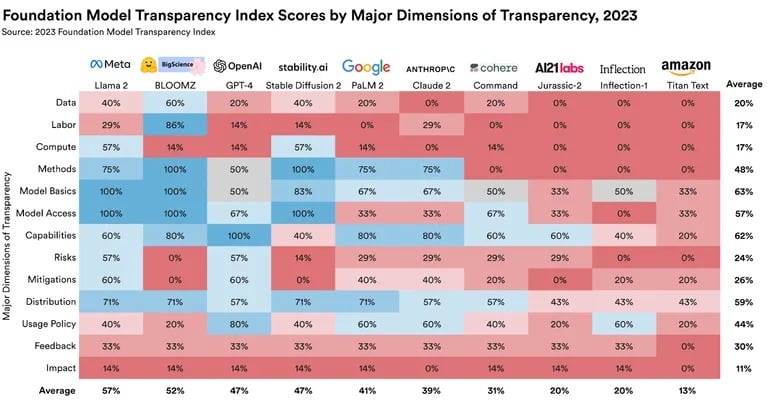

Para abordar esta cuestión, Bommasani y un equipo de Stanford, el MIT y Princeton crearon el Índice de Transparencia de Modelos de Fundaciones (FMTI). El índice evalúa un amplio conjunto de temas que ofrecen una visión global del grado de transparencia de las empresas en lo que respecta a sus modelos de IA. La clasificación estudia aspectos como la forma en que una empresa construye un modelo básico, la disponibilidad de su conjunto de datos, cómo funciona y cómo se utiliza posteriormente.

Los resultados fueron menos que estelares. Las puntuaciones más altas oscilaron entre 47 y 54 en una escala de 0 a 100, con Llama 2 de Meta a la cabeza. OpenAI tiene un 47% de transparencia, Google sólo un 41% y Anthropic obtuvo un 39% por su transparencia.

Fuente: Stanford Center for Research on Foundation Models

La distinción entre modelos de código abierto y de código cerrado también influyó en la clasificación.

«En concreto, cada desarrollador abierto es casi tan transparente en términos de puntuación agregada como el desarrollador cerrado con mayor puntuación», escribió el equipo de la Universidad de Stanford en un extenso documento de investigación. Para los no científicos, eso significa que el peor modelo de IA de código abierto es más transparente que los mejores modelos de código cerrado.

La transparencia en los modelos de IA no es sólo una cuestión de interés académico. Los responsables políticos de todo el mundo han expresado la necesidad de un desarrollo de IA transparente.

Para muchos responsables políticos de la UE, EE.UU., Reino Unido, China, Canadá, el G7 y muchos otros gobiernos, la transparencia es una prioridad política fundamental», afirma Bommasani.

Las implicaciones generales de estas conclusiones son claras. A medida que los modelos de IA se integran más en diversos sectores, la transparencia se convierte en algo primordial. No sólo por consideraciones éticas, sino también por las aplicaciones prácticas y la fiabilidad.