根据斯坦福大学研究团队的研究,ChatGPT、Claude、Bard 和 LlaM-A-2 等主流人工智能模型的透明度越来越低。

这项新研究由斯坦福大学基础模型研究中心(CRFM)完成,该中心隶属于斯坦福大学以人为本的人工智能研究所(HAI),负责研究和开发人工智能基础模型。

CRFM 社区负责人 Rishi Bomasani 在一份官方新闻稿中说:”基础模型领域的公司正变得越来越不透明。这种不透明性给企业、政策制定者和消费者都带来了挑战。

最准确、最常用的基础模型背后的公司都同意他们想做好事,但对公开性和透明度却有不同的看法。

例如,OpenAI 将缺乏透明度视为一种保障。

“官方博客写道:”我们现在认为,我们最初关于开放性的想法是错误的,我们已经从认为应该公布一切转变为认为我们需要弄清楚如何安全地分享系统访问权限及其收益。

麻省理工学院 2020 年的一项研究表明,这种核心理念已经存在了一段时间。”研究人员写道:”他们的叙述表明,OpenAI 尽管有着崇高的愿望,但却执着于保守秘密、保护形象和维护员工的忠诚度。

Anthropic公司关于人工智能安全的核心观点则表明,这家初创公司致力于 “将人工智能系统视为透明和可解释的系统”,并注重建立 “透明度和程序措施,以确保可核查地遵守(其)承诺”。同样在 2023 年 8 月,谷歌宣布启动透明中心,以更好地披露其政策并解决这一问题。

但用户为什么要关心人工智能的透明度呢?

“斯坦福大学的论文认为:”透明度较低,其他企业就很难了解他们是否可以安全地创建依赖于商业模型的应用;科学家也很难依赖于基于商业模型的商业模式进行研究;政策制定者也很难制定有意义的政策来限制这一强大的技术;消费者也很难了解模型的局限性或寻求对所造成伤害的补偿。

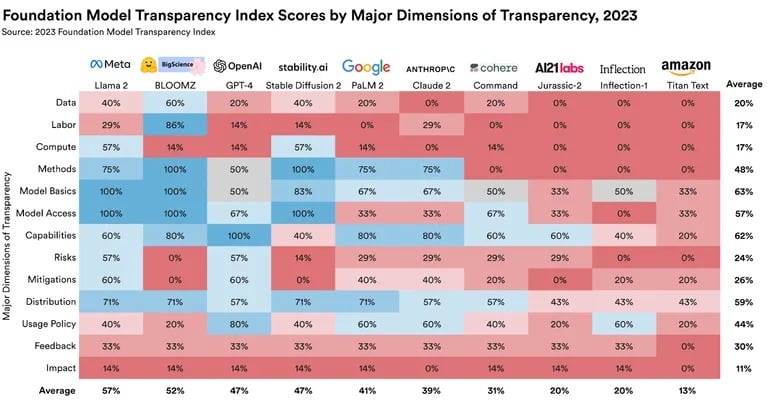

为了解决这个问题,博马萨尼和一个来自斯坦福大学、麻省理工学院和普林斯顿大学的团队正在开发基础模型透明度指数(FMTI)。该指数对一系列广泛的主题进行评估,以全面了解公司在人工智能模型方面的透明度。排名考察的方面包括:公司如何建立基础模型、数据集的可用性、如何运作以及如何在下游使用。

结果并不理想。在 0 到 100 的评分范围内,最高得分介于 47 到 54 之间,Meta 的 Llama 2 遥遥领先。OpenAI 的透明度为 47%,谷歌仅为 41%,Anthropic 的透明度为 39%。

来源:斯坦福大学基金会模式研究中心

开放源代码模式和封闭源代码模式之间的区别在排名中也起到了一定的作用。

“斯坦福大学团队在一份详尽的研究论文中写道:”特别是,每个开源模型开发者的综合得分几乎与得分最高的闭源模型开发者一样透明。在外行人看来,这意味着最差的开源人工智能模型比最好的闭源模型更加透明。

人工智能模型的透明度不仅仅是一个学术问题。全世界的政策制定者都表示,人工智能的发展需要适当的透明度。

“对于欧盟以及美国、英国、中国、加拿大、七国集团和其他一些政府的许多政治家来说,透明度是政治上的头等大事,”博马萨尼说。

这些发现的广泛影响显而易见。随着人工智能模型越来越多地融入各个领域,透明度变得至关重要。这不仅是出于道德方面的考虑,也是出于实际应用和可靠性的考虑。