ChatGPT、Claudeなど主要AI基盤モデル AIモデルの透明性が悪化していると研究者が警告

スタンフォード大学の研究チームによると、ChatGPT、Claude、Bard、LlaM-A-2のような主要なAI基盤モデルの透明性が低下しているという。

この新しい研究は、スタンフォード大学人間中心人工知能研究所(HAI)の一部であり、AI基盤モデルの研究開発を行う同大学の基盤モデル研究センター(CRFM)によるものだ。

「公式プレスリリースによると、CRFMのソサエティ・リードであるリシ・ボマサニ氏は、「ファウンデーション・モデル分野の企業は、透明性を失いつつある。この不透明性は、企業、政策立案者、消費者に課題を突きつけている。

最も正確で利用されているLLMの背後にある企業はすべて、良いことをしたいという点では一致しているが、公開性と透明性に関しては異なる見解を持っている。

例えばOpenAIは、透明性の欠如を警告として受け入れている。

「私たちは現在、オープン性に関する当初の考え方が間違っていたと考えており、すべてを公開すべきだという考えから、システムへのアクセスやその恩恵を安全に共有する方法を見つけるべきだという考えに転換した」と公式ブログには書かれている。

2020年からのMITの調査によれば、これはしばらくの間、核となる理念であった。「OpenAIは、その崇高な志のために、秘密保持、イメージの保護、従業員の忠誠心の保持に執着していることを示唆している」と研究者は書いている。

一方、AnthropicのAI安全性に関する中核的な見解は、「透明で解釈可能なAIシステムを扱う」というスタートアップのコミットメントと、「(コミットメントの)検証可能な遵守を保証するための透明性と手続き上の措置」の設定に重点を置いていることを示している。また、グーグルは2023年8月、自社の方針をより適切に開示し、この問題に取り組むため、透明性センターを立ち上げると発表した

。

しかし、なぜユーザーはAIの透明性を気にする必要があるのだろうか?

「透明性が低いと、他の企業が商業的な基盤モデルに依存したアプリケーションを安全に構築できるかどうかを知ることが難しくなり、学者が研究のために商業的な基盤モデルに依存することが難しくなり、政策立案者がこの強力なテクノロジーを抑制するために意味のある政策を設計することが難しくなり、消費者がモデルの限界を理解したり、引き起こされた損害の救済を求めたりすることが難しくなる」とスタンフォード大学の論文は主張している。

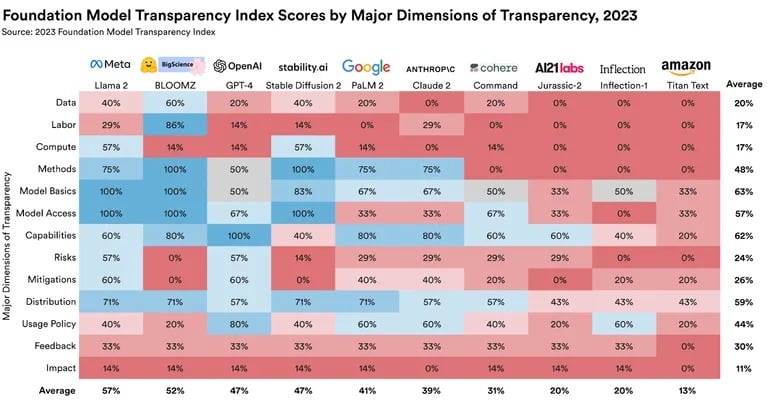

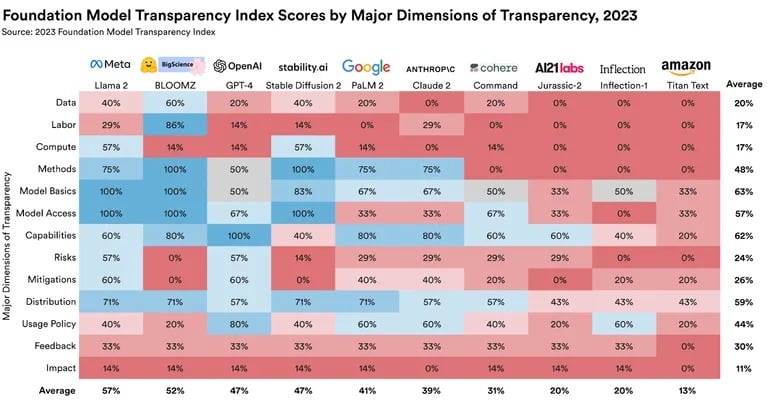

これに対処するため、ボマサニ氏とスタンフォード大学、マサチューセッツ工科大学、プリンストン大学のチームは、財団モデル透明性指数(Foundation Model Transparency Index:FMTI)を考案した。この指標は、企業がAIモデルに関してどの程度透明性があるかを総合的に評価するものである。このランキングは、企業がどのように基盤モデルを構築しているか、データセットの入手可能性、どのように動作しているか、どのように下流で使用されているかといった側面を調査している。

結果はあまり芳しいものではなかった。最も高いスコアは、0から100のスケールで47から54の範囲であり、MetaのLlama 2が群を抜いていた。OpenAIの透明性は47%、Googleはわずか41%、Anthropicは39%だった

。

Source: Stanford Center for Research on Foundation Models

オープンソース型とクローズドソース型の区別も、ランキングに一役買っている。

スタンフォード大学の研究チームは、膨大な研究論文の中で、「特に、すべてのオープン開発者は、総スコアにおいて、最もスコアの高いクローズド開発者とほぼ同等の透明性を持っている」と書いている。科学者以外にとっては、最悪のオープンソースのAIモデルは、最高のクローズドソースのモデルよりも透明性が高いということになる。

AIモデルの透明性は、学術的な関心の問題だけではない。適切な透明性のあるAI開発の必要性は、世界中の政策立案者からも声があがっている

。

EUだけでなく、米国、英国、中国、カナダ、G7、その他多くの政府の多くの政策立案者にとって、透明性は主要な政策優先事項です」とボマサニは言う。

この調査結果の広範な意味は明らかだ。AIモデルが様々な分野に組み込まれるにつれ、透明性が最も重要になる。スタンフォード大学の研究チームによれば、

、バルド、LlaM-A-2は透明性を失いつつあるという。

この新しい研究は、スタンフォード大学人間中心人工知能研究所(HAI)の一部であり、AI基盤モデルの研究開発を行う同大学の基盤モデル研究センター(CRFM)によるものだ。

「公式プレスリリースによると、CRFMのソサエティ・リードであるリシ・ボマサニ氏は、「ファウンデーション・モデル分野の企業は、透明性を失いつつある。この不透明性は、企業、政策立案者、消費者に課題を突きつけている。

最も正確で利用されているLLMの背後にある企業はすべて、良いことをしたいという点では一致しているが、公開性と透明性に関しては異なる見解を持っている。

例えばOpenAIは、透明性の欠如を警告として受け入れている。

「私たちは現在、オープン性に関する当初の考え方が間違っていたと考えており、すべてを公開すべきだという考えから、システムへのアクセスやその恩恵を安全に共有する方法を見つけるべきだという考えに転換した」と公式ブログには書かれている。

2020年からのMITの調査によれば、これはしばらくの間、核となる理念であった。「OpenAIは、その崇高な志のために、秘密保持、イメージの保護、従業員の忠誠心の保持に執着していることを示唆している」と研究者は書いている。

一方、AnthropicのAI安全性に関する中核的な見解は、「透明で解釈可能なAIシステムを扱う」というスタートアップのコミットメントと、「(コミットメントの)検証可能な遵守を保証するための透明性と手続き上の措置」の設定に重点を置いていることを示している。また、グーグルは2023年8月、自社の方針をより適切に開示し、この問題に取り組むため、透明性センターを立ち上げると発表した

。

しかし、なぜユーザーはAIの透明性を気にする必要があるのだろうか?

「透明性が低いと、他の企業が商業的な基盤モデルに依存したアプリケーションを安全に構築できるかどうかを知ることが難しくなり、学者が研究のために商業的な基盤モデルに依存することが難しくなり、政策立案者がこの強力なテクノロジーを抑制するために意味のある政策を設計することが難しくなり、消費者がモデルの限界を理解したり、引き起こされた損害の救済を求めたりすることが難しくなる」とスタンフォード大学の論文は主張している。

これに対処するため、ボマサニ氏とスタンフォード大学、マサチューセッツ工科大学、プリンストン大学のチームは、財団モデル透明性指数(Foundation Model Transparency Index:FMTI)を考案した。この指標は、企業がAIモデルに関してどの程度透明性があるかを総合的に評価するものである。このランキングは、企業がどのように基盤モデルを構築しているか、データセットの入手可能性、どのように動作しているか、どのように下流で使用されているかといった側面を調査している。

結果はあまり芳しいものではなかった。最も高いスコアは、0から100のスケールで47から54の範囲であり、MetaのLlama 2が群を抜いていた。OpenAIの透明性は47%、Googleはわずか41%、Anthropicは39%だった

。

Source: Stanford Center for Research on Foundation Models

オープンソース型とクローズドソース型の区別も、ランキングに一役買っている。

スタンフォード大学の研究チームは、膨大な研究論文の中で、「特に、すべてのオープン開発者は、総スコアにおいて、最もスコアの高いクローズド開発者とほぼ同等の透明性を持っている」と書いている。科学者以外にとっては、最悪のオープンソースのAIモデルは、最高のクローズドソースのモデルよりも透明性が高いということになる。

AIモデルの透明性は、学術的な関心の問題だけではない。適切な透明性のあるAI開発の必要性は、世界中の政策立案者からも声があがっている

。

EUだけでなく、米国、英国、中国、カナダ、G7、その他多くの政府の多くの政策立案者にとって、透明性は主要な政策優先事項です」とボマサニは言う。

この調査結果の広範な意味は明らかだ。AIモデルが様々な分野に組み込まれるにつれ、透明性が最も重要になる。倫理的配慮のためだけでなく、実用的な応用や信頼性のためにも。