Con la proliferazione online di foto e video realistici generati dall’intelligenza artificiale, le aziende tecnologiche e i gruppi di controllo stanno facendo a gara per sviluppare strumenti in grado di identificare i contenuti falsi.

Una soluzione comunemente proposta è il watermarking delle immagini generate al computer, che aggiunge una bandiera invisibile sotto forma di metadati nascosti che aiutano a rivelare che un’immagine è stata creata con uno strumento di IA generativa. Ma i ricercatori hanno scoperto che questo tipo di watermarking ha un grosso difetto: le tecniche avversarie possono rimuoverlo facilmente.

Ora i principali produttori di fotocamere propongono un approccio diverso, in un certo senso opposto: incorporare i watermark in fotografie “reali”.

Nikon, Sony e Canon hanno recentemente annunciato un’iniziativa congiunta per includere le firme digitali nelle immagini scattate direttamente dalle loro fotocamere mirrorless di fascia alta. Secondo Nikkei Asia, le firme integreranno metadati chiave come la data, l’ora, la posizione GPS e i dettagli del fotografo, certificando crittograficamente l’origine digitale di ogni foto.

Nikon ha dichiarato che lancerà questa funzione nella sua prossima linea di fotocamere mirrorless professionali; Sony rilascerà aggiornamenti del firmware per inserire le firme digitali nelle sue attuali fotocamere mirrorless; e Canon intende far debuttare le fotocamere con autenticazione integrata nel 2024, insieme al watermarking dei video più tardi nello stesso anno.

L’obiettivo, riporta Nikkei, è quello di fornire a fotoreporter, professionisti dei media e artisti una prova inconfutabile della credibilità delle loro immagini. Le firme resistenti alle manomissioni non scompariranno con le modifiche e dovrebbero aiutare a combattere la disinformazione e l’uso fraudolento delle foto online.

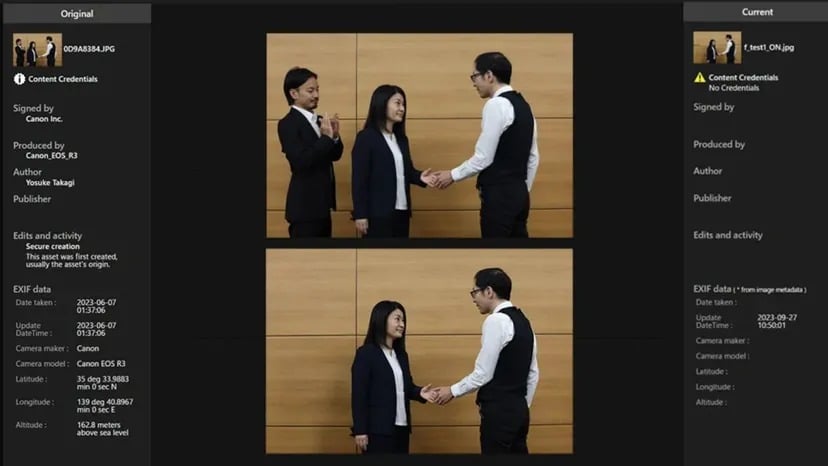

A tal fine, le aziende hanno collaborato a uno standard aperto per firme digitali interoperabili denominato “Verify”. Una volta in vigore, le foto scattate con un hardware adeguato potranno essere verificate gratuitamente online, in modo che le persone possano determinare se una foto è autentica o meno.

Se una foto generata dall’intelligenza artificiale cerca di superare il sistema Verify senza una firma autentica, viene etichettata come “Senza credenziali di contenuto”.

Fonte: Canon

Invece di contrassegnare retroattivamente i contenuti AI, il piano autentica direttamente le foto reali all’origine. Ma come qualsiasi altro sistema di watermarking, il suo successo dipenderà dall’adozione diffusa (più produttori di hardware incorporano lo standard) e da un’implementazione a prova di tempo (il codice si evolve per rimanere non violabile).

Come riportato da TCN, recenti ricerche indicano che le tecniche anti-watermarking potrebbero anche compromettere le firme incorporate, rendendo inutili gli attuali metodi di watermarking. Tuttavia, questo rende solo le immagini filigranate non filigranate, quindi le persone hanno meno strumenti per rilevarne l’artificiosità.

Sebbene le tecniche di anti-watermarking possano potenzialmente rimuovere le firme di autenticità dalle foto reali, questo è meno problematico rispetto alla rimozione dei watermark dalle immagini false generate dall’intelligenza artificiale. Perché? Se un watermark viene rimosso da un deepfake generato dall’intelligenza artificiale, il contenuto falsificato può passare più facilmente per vero. Tuttavia, se le firme di autenticazione sono state eliminate da foto reali, l’immagine rimanente è ancora catturata da una fotocamera e non proviene da un modello generativo. Anche se perde la sua prova crittografica, il contenuto sottostante è ancora autentico.

Il rischio principale in questo caso è legato all’attribuzione e alla gestione dei diritti, non alla veridicità del contenuto. L’immagine potrebbe essere accreditata in modo errato o utilizzata senza le dovute licenze, ma non è intrinsecamente in grado di ingannare gli spettatori sulla realtà che rappresenta.

OpenAI ha recentemente annunciato un rilevatore di deepfake alimentato dall’intelligenza artificiale che sostiene di avere un’accuratezza del 99% sulle immagini. Tuttavia, i rilevatori di AI rimangono imperfetti e devono essere costantemente aggiornati per superare le evoluzioni della tecnologia generativa.

La recente impennata di sofisticazione dei deepfake ha effettivamente messo in luce la necessità di tali strategie. Come abbiamo visto nel 2023, la necessità di distinguere tra contenuti reali e contenuti inventati non è mai stata così forte. Sia i politici che gli sviluppatori tecnologici si stanno dando da fare per trovare soluzioni valide, quindi un piccolo aiuto da parte di queste aziende è sicuramente apprezzato.