De AI-industrie is getuige van een spannende competitie tussen de bekende ChatGPT- en Claude AI-modellen. De Large Model Systems Organization (LMSO), verantwoordelijk voor het creëren van de Chatbot Arena en het befaamde Vicuna Model, heeft zojuist zijn Chatbot Arena Leaderboard bijgewerkt, waarin wordt weergegeven hoe elke AI-chatbot zich verhoudt tot zijn concurrenten. Het blijkt dat Anthropic OpenAI het nakijken geeft, ook al zijn de modellen nog steeds gratis te gebruiken.

GPT-4, de krachtpatser achter ChatGPT Plus en Bing AI, regeert met de hoogste score en is de gouden standaard voor Large Language Models (LLM’s). Maar naarmate we lager op de ranglijst komen, ontvouwt zich een onverwacht underdogverhaal. Anthropic’s Claude modellen – Claude 1, Claude 2 en Claude Instant – presteren allemaal beter dan GPT-3.5, de engine die de gratis versie van ChatGPT aanstuurt. Dit betekent dat elk groot taalmodel ontwikkeld door Antropic de gratis versie van ChatGPT kan overtreffen.

Het nauwgezette rankingsysteem van de LMSO gaf inzicht in de prestatiecijfers van deze modellen. Volgens het klassement heeft GPT-4 een Arena Elo-rating van 1181 en voert daarmee de ranglijst aan, terwijl de Claude-modellen op de voet volgen met ratings variërend van 1119 tot 1155. GPT-3.5 daarentegen blijft achter met een rating van 1115.

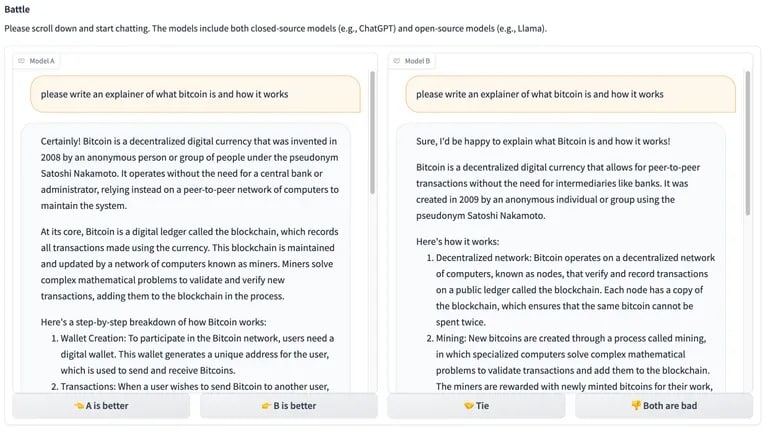

Om de modellen te rangschikken laat het LMSO ze “strijden” in wedstrijden met vergelijkbare prompts. Het model met het beste antwoord wint en het andere verliest. Gebruikers beslissen wie er wint op basis van hun eigen voorkeuren, maar ze weten nooit welke modellen met elkaar concurreren.

Afbeelding: LMSO

Zoals TCN eerder meldde, is het verschil in tokenverwerkingsmogelijkheden tussen ChatGPT Plus en Claude Pro, hoewel geen factor in de LMSO-ranglijst, ook een groot voordeel dat Claude-modellen hebben ten opzichte van GPT.

“Claude Pro, gebaseerd op de Claude 2 LLM, kan tot 100K tokens aan informatie verwerken, terwijl ChatGPT Plus, aangedreven door de GPT-4 LLM, 8.192 tokens verwerkt,” herinnerden we ons. Dit verschil in token-verwerkingscapaciteit onderstreept de voorsprong die Claude-modellen hebben in het beheren van uitgebreide contextuele input, wat cruciaal is voor een genuanceerde en verrijkte gebruikerservaring.

Bovendien heeft Claude 2 bij het verwerken van lange prompts laten zien superieur te zijn aan GPT, waarbij prompts van grotere omvang efficiënter worden verwerkt. Wanneer prompts echter vergelijkbaar zijn, leveren Claude 1 en Claude Instant vergelijkbare of iets betere resultaten dan GPT-3.5, wat de competitieve aard van deze modellen aantoont. Met de contextmogelijkheden van Claude kan een slecht eerste antwoord drastisch worden verbeterd met een meer verfijnde, grotere en rijkere prompt.

Open-source modellen liggen niet ver achter in deze race.

WizardLM, een model getraind op Meta’s LlaMA-2 met 70 miljard parameters, is de beste open-source LLM. Vlak daarna volgen Vicuna 33B en de originele LlaMA-2, uitgebracht door Meta.

De @lmsysorg heeft zojuist het Chatbot Arena Leaderboard bijgewerkt!

Onze WizardLM-70B is nu hetTop-1 open-source model op zowel ⚔️Arena Elo als MT-bench.

❤️Main Medewerkers:@CanXu20 @victorsungo_ai@ChiYeung_Law@hpluo12@tangmensan

Klassement: https://t.co/1gkZKGVutQ

Model… pic.twitter.com/bsJ0jv2i7I– WizardLM (@WizardLM_AI) Oktober 5, 2023

Voor niet-ingewijden lijkt dit misschien de zoveelste leaderboard-update. Maar voor degenen die de AI-industrie nauwlettend in de gaten houden, is het een bewijs van hoe hevig de concurrentie is en hoe snel het tij kan keren. En voor de rest van ons, die zich tussen deze twee kampen in bevindt, is het een herinnering dat in de AI-wereld het populairste model van vandaag ten onder kan gaan aan het meest efficiënte model.