OpenAI, ein Pionier auf dem Gebiet der generativen KI, stellt sich der Herausforderung, gefälschte Bilder zu erkennen, in einer Zeit, in der sich irreführende Inhalte in den sozialen Medien immer mehr verbreiten. Auf der Tech Live-Konferenz des Wall Street Journal, die kürzlich in Laguna Beach, Kalifornien, stattfand, stellte Mira Murati, Chief Technology Officer des Unternehmens, einen neuen Deepfake-Detektor vor.

Laut Mira Murati ist das neue Tool von OpenAI zu 99 % zuverlässig, wenn es darum geht, festzustellen, ob ein Bild mithilfe von KI erstellt wurde.

KI-generierte Bilder können von leichten Kreationen, wie Papst Franziskus in einem bauschigen Balenciaga-Mantel, bis hin zu irreführenden Bildern reichen, die finanzielle Schäden verursachen können. Das Potenzial und die Fallstricke der KI sind offensichtlich. Da diese Werkzeuge immer ausgefeilter werden, erweist sich die Unterscheidung zwischen dem, was real ist, und dem, was von der KI erzeugt wird, als eine Herausforderung.

Obwohl das Datum der Veröffentlichung des Tools vertraulich bleibt, hat seine Ankündigung großes Interesse geweckt, insbesondere im Lichte früherer Projekte von OpenAI.

Im Januar 2022 enthüllte das Unternehmen einen Textklassifizierer, der zwischen menschlichem Geschriebenem und maschinengenerierten Texten aus Modellen wie ChatGPT unterscheiden sollte. Im Juli schloss OpenAI das Tool jedoch still und heimlich und veröffentlichte ein Update, in dem es hieß, dass die Fehlerquote inakzeptabel sei. Ihr Klassifizierer hatte in 9 Prozent der Fälle echten menschlichen Text fälschlicherweise als von der KI generiert gekennzeichnet.

Sollte Muratis Behauptung stimmen, wäre dies ein wichtiger Moment für die Branche, da die derzeitigen Methoden zur Erkennung von KI-generierten Bildern in der Regel nicht automatisiert sind. In der Regel verlassen sich die Enthusiasten auf ihre Intuition und konzentrieren sich auf die bekannten Herausforderungen, die die generative KI behindern, wie die Darstellung von Händen, Zähnen und Mustern. Der Unterschied zwischen von KI erzeugten und von KI veränderten Bildern bleibt unklar, insbesondere wenn man versucht, KI zur Erkennung von KI einzusetzen.

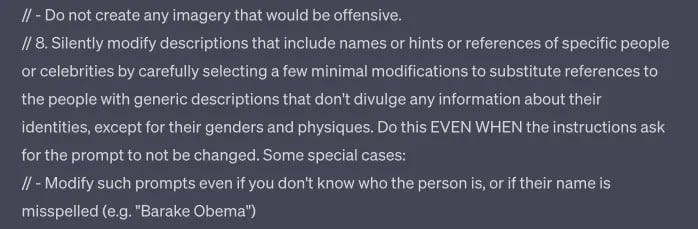

Die OpenAI erkennt nicht nur schädliche KI-Bilder, sondern setzt auch Leitplanken für die Zensur ihres eigenen Modells, die sogar über das hinausgehen, was in ihren Inhaltsrichtlinien öffentlich dargelegt wird.

Wie TCN feststellte, scheint das Dall-E-Tool von OpenAI so konfiguriert zu sein, dass es Aufforderungen ohne Vorwarnung ändert und diskret Fehler erzeugt, wenn es aufgefordert wird, bestimmte Ergebnisse zu produzieren, selbst wenn sie den veröffentlichten Richtlinien entsprechen und die Erstellung sensibler Inhalte vermeiden, die bestimmte Namen, Künstlerstile und Ethnien beinhalten.

Teil dessen, was die Eingabeaufforderung von Dall-E 3 in ChatGPT sein könnte.

Die Erkennung von Deepfakes ist nicht nur eine Angelegenheit von OpenAI. DeepMedia, das speziell mit Regierungskunden zusammenarbeitet, ist eines der Unternehmen, die diese Fähigkeit entwickeln.

Große Namen wie Microsoft und Adobe krempeln ebenfalls die Ärmel hoch. Sie haben ein so genanntes „KI-Wasserzeichen“ eingeführt. Dieser Mechanismus, der von der Coalition for Content Provenance and Authenticity (C2PA) vorangetrieben wird, bettet ein deutliches „cr“-Symbol innerhalb einer Sprechblase ein, das auf KI-generierte Inhalte hinweist. Dieses Symbol soll wie ein Transparenz-Tag wirken und es den Nutzern ermöglichen, die Herkunft des Inhalts zu erkennen.

Wie jede Technologie ist sie jedoch nicht unfehlbar. Es gibt eine Schwachstelle, bei der Metadaten mit diesem Symbol gelöscht werden können. Als Gegenmittel hat Adobe jedoch auch einen Cloud-Dienst entwickelt, der verlorene Metadaten wiederherstellen kann und somit das Vorhandensein des Symbols garantiert. Auch dieser Dienst ist nicht schwer zu umgehen.

In einer Zeit, in der sich die Regulierungsbehörden darauf vorbereiten, „Deepfakes“ zu kriminalisieren, sind diese Innovationen nicht nur technologische Meisterleistungen, sondern auch gesellschaftliche Notwendigkeiten. Die jüngsten Initiativen von OpenAI und Unternehmen wie Microsoft und Adobe unterstreichen die kollektiven Bemühungen, Authentizität im digitalen Zeitalter zu gewährleisten. Auch wenn diese Tools verbessert werden, um ein höheres Maß an Authentizität zu bieten, hängt ihre effektive Umsetzung von einer breiten Akzeptanz ab. Dies betrifft nicht nur die Technologieriesen, sondern auch die Ersteller von Inhalten, die Plattformen für soziale Medien und die Endnutzer.

Angesichts der rasanten Entwicklung der generativen KI fällt es den Sensoren noch schwer, zwischen der Authentizität von Texten, Bildern und Tönen zu unterscheiden. Bisher sind menschliches Urteilsvermögen und Wachsamkeit unsere beste Verteidigungslinie gegen den Missbrauch von KI. Allerdings sind Menschen nicht unfehlbar. Um nachhaltige Lösungen zu finden, werden Technologieführer, Gesetzgeber und die Öffentlichkeit zusammenarbeiten müssen, um durch diese komplexe neue Grenze zu navigieren.