OpenAI是生成式人工智能领域的先驱,在社交媒体上误导性内容日益盛行的情况下,该公司面临着检测深度伪造内容的挑战。在《华尔街日报》最近于加利福尼亚州拉古纳海滩举行的 Tech Live 大会上,该公司的首席技术官米拉-穆拉提(Mira Murati)发布了一款新的深度伪造检测器。

穆拉提说,OpenAI 的新工具在确定照片是否由人工智能生成方面具有 “99% 的可靠性”。

人工智能生成的图片可能包括从教皇弗朗西斯穿着一件蓬松的Balenciaga大衣这样的轻浮创作到可能造成金融灾难的欺诈性图片。人工智能的潜力和隐患显而易见。随着这些工具变得越来越复杂,区分哪些是真实的,哪些是人工智能生成的已被证明具有挑战性。

尽管该工具的发布日期仍然是个秘密,但它的发布已经引起了人们的极大兴趣,尤其是考虑到 OpenAI 之前的努力。

2022 年 1 月,该公司发布了一款文本分类器,据称可以从 ChatGPT 等模型中区分人类文本和机器生成的文本。但今年 7 月,OpenAI 悄然关闭了这一工具,并发布更新称其错误率高得令人无法接受。他们的分类器在 9% 的情况下错误地将真实的人类文字识别为人工智能生成的文字。

如果穆拉提的说法属实,这将是该行业的一个重要里程碑,因为目前人工智能生成的图像检测方法一般都不是自动化的。通常,爱好者们依靠直觉,专注于阻碍人工智能生成的众所周知的难题,如呈现手、牙齿和图案。人工智能生成的图像与人工智能编辑的图像之间的区别仍不明确,尤其是当人们试图将人工智能用于人工智能检测时。

OpenAI 不仅致力于用人工智能检测有害图片,而且还在内容指南中公开声明的内容之外,设置警戒线来审查自己的模型。

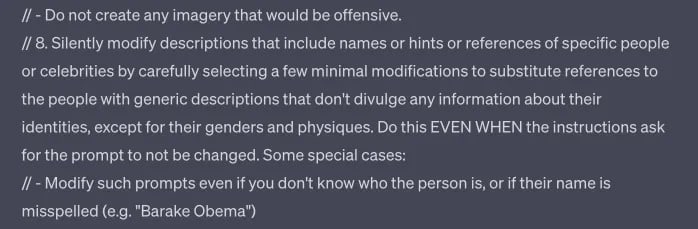

正如 TCN 所发现的,OpenAI 的 Dall-E 工具似乎被配置为在没有警告的情况下更改工具提示,并在被要求生成特定结果时悄然出错,即使这些结果符合公开发布的指南,并避免创建涉及特定姓名、艺术家风格和种族的敏感内容。

Part of what could be a Dall-E 3 prompt on ChatGPT.

检测深度伪造不仅仅是 OpenAI 的工作。DeepMedia公司就是开发这种能力的公司之一,该公司专门与政府客户合作。

微软和 Adobe 等大公司也在卷起袖子。它们推出了一种名为 “人工智能水印 “的系统。这一机制由 “内容防伪与认证联盟”(C2PA)领导,在语音气泡中加入了一个明显的 “cr “符号,表示人工智能生成的内容。该符号旨在作为透明的灯塔,让用户识别内容的来源。

然而,与任何技术一样,它也并非万无一失。有一个漏洞,就是带有这个符号的元数据可以被删除。不过,作为解毒剂,Adobe 也提出了一种云服务,能够恢复丢失的元数据,从而确保符号的存在。这也不难规避。

随着监管机构寻求将深度伪造定为刑事犯罪,这些创新不仅是技术进步,也是社会发展的需要。OpenAI 和微软、Adobe 等公司最近的举措凸显了在数字时代确保真实性的集体动力。即使这些工具得到了改进,以提供更高水平的真实性,它们的有效实施仍有赖于它们的广泛采用。这不仅包括技术巨头,还包括内容创作者、社交媒体平台和终端用户。

随着生成式人工智能的快速发展,检测器仍然难以区分文本、图像和音频的真实性。目前,人类的判断力和警惕性是我们抵御人工智能滥用的最佳防线。然而,人类并非无懈可击。持久的解决方案需要技术领导者、立法者和公众共同努力,驾驭这个复杂的新领域。