Das Unternehmen, das sich umbenannt hat, um sich auf das Metaverse zu konzentrieren, verbrachte den größten Teil seiner Keynote-Präsentation auf der jährlichen Meta Connect-Konferenz damit, über künstliche Intelligenz zu sprechen, was die plötzliche Dominanz und Omnipräsenz von KI-Technologie in diesem Jahr weiter bestätigt.

Die Meta-Führungskräfte legten einen soliden Plan dafür vor, wie KI zum Dreh- und Angelpunkt vieler Unternehmensinitiativen werden wird – einschließlich der Gestaltung des Metaverse.

Im Mittelpunkt des Tages stand MetaAI, ein persönlicher Assistent, der an die Funktionen von Siri angelehnt ist, aber über ein breiteres Spektrum an multimodalen Fähigkeiten verfügt. Dieser KI-Begleiter ist nicht nur verbal interaktiv – er kann mit Sprache, Text und sogar mit Gesten kommunizieren. Er kann mit der kommenden intelligenten Brille von Meta gekoppelt werden, die in Zusammenarbeit mit dem Brillenriesen Ray-Ban entwickelt wurde und für 299 US-Dollar vorbestellt werden kann.

Benutzer, die Metas kommende AR-Brille tragen, können mit MetaAI interagieren, während es reale Objekte identifiziert, auf Aufforderungen in natürlicher Sprache antwortet und Aufgaben erledigt. So können Nutzer MetaAI zum Beispiel nach Fakten über einen bestimmten Ort oder ein Kunstwerk fragen oder ein Foto oder Video von einem bestimmten Moment aufnehmen.

Die neuen KI-Fähigkeiten des Unternehmens gehen jedoch noch weiter. Restyle, eine neue Funktion, ermöglicht es Nutzern, ihre Instagram-Bilder mit Text zu bearbeiten, ähnlich wie bei der Inpainting-Funktion in Stable Diffusion. Diese textbasierte Fotobearbeitungsfunktion erweitert die Möglichkeiten der Nutzer, mit Bildern zu interagieren, und nutzt die multimodalen KI-Fähigkeiten von Meta.

Bild: Meta

Auf dem Weg zu mehr KI-gesteuerten Bearbeitungstools hat Meta Backdrop eingeführt, das Elemente eines Bildes identifiziert und für spätere Bearbeitungen wie das Ändern von Hintergründen oder das Neueinfärben eines Outfits separiert. Bei dieser Funktion geht es nicht nur um die Bearbeitung, sondern auch um die Gestaltung.

Die Grundlage für viele dieser Innovationen ist Emu, das neue Text-Bild-Modell von Meta. Emu kann in Sekundenschnelle originalgetreue Bilder generieren, die MetaAI und anderen Anwendungen reichlich Material zum Aufbau immersiver virtueller Welten liefern. Emu lässt sich mit Metas LLaMA-2 Textgenerator und MetaAI zu einem All-in-One-KI-Begleiter kombinieren.

Multimodale KI, die Computer Vision, natürliche Sprachverarbeitung, Spracherkennung und andere Modalitäten kombiniert, ist ein Eckpfeiler von Metas Ansatz.

Auch bei der Sicherheit hat Meta nicht gespart. Das Unternehmen hat ein LLaMA-2 „rotes Team“ eingeführt, das den KI-Sprachmodus des Unternehmens eindämmen soll, was besonders kritisch ist, da sein Open-Source-Charakter eine Büchse der Pandora für unzensierte Inhalte darstellen könnte.

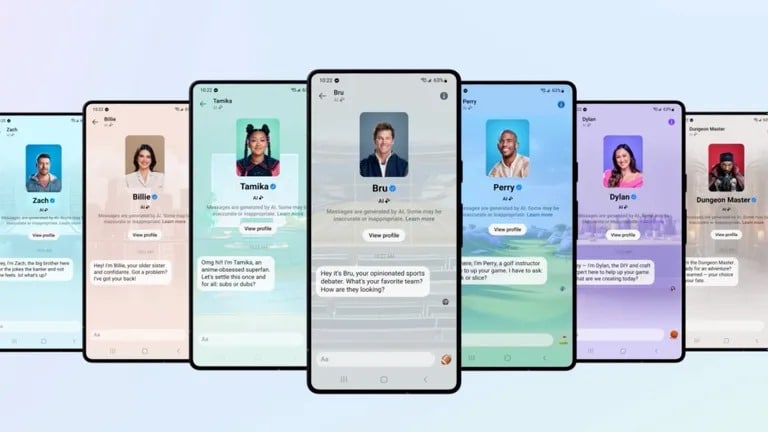

Meta hat KI-Charakter-Chatbots eingeführt, die Berühmtheiten wie Tom Brady und Naomi Osaka nachempfunden sind. Bild: Meta

Meta führt außerdem 28 KI-Charaktere ein, mit denen die Nutzer interagieren können. „Einige werden von kulturellen Ikonen und Einflussnehmern gespielt, darunter Snoop Dogg, Tom Brady, Kendall Jenner und Naomi Osaka“, so Meta in seiner offiziellen Ankündigung.

Um seine KI-Ambitionen zu erweitern, kündigte Meta eine neue Partnerschaft mit Amazon Web Services (AWS) an, die es AWS-Kunden ermöglicht, Llama2 mit nur einem API-Schlüssel auszuführen. Dies senkt die Hürde für Entwickler, die den KI-Bereich erkunden möchten, erheblich. Das neue AI Studio von Meta ist ein Toolkit für Entwickler, mit dem sie KI-Produkte für verschiedene Bereiche wie Mode, Design und Spiele erstellen können.

Andrew Bosworth, CTO von Meta, fasste die Geschichte von Metas KI-Reise während seiner Keynote wortgewandt zusammen: „KI prägt die Art und Weise, wie wir das Metaverse aufbauen.“ Die Absicht war eindeutig, eine symbiotische Beziehung zwischen KI und dem Metaversum aufzuzeigen und nicht eine Verlagerung des Schwerpunkts in Metas Geschäftsmodell