深度伪造的泛滥带来了巨大的风险–从创建未成年人的裸体图像到利用名人的深度伪造进行欺诈性促销–区分人工智能生成的内容(AIGC)和人类创建的内容的能力从未像现在这样重要。

水印是一种常见的文件和货币防伪措施,是识别此类内容的一种方法,它通过添加信息来帮助区分人工智能生成的图像和非人工智能生成的图像。但最近的一篇研究论文认为,简单甚至复杂的水印方法可能并不足以真正防止将人工智能材料作为人类生成的材料进行营销所带来的风险。

这项研究由来自南洋理工大学、S-Lab、南洋理工大学、重庆大学、香农人工智能公司和浙江大学的研究团队共同完成。

作者之一李冠林告诉 TCN,”水印可以帮助人们了解内容是人工智能生成的还是人类生成的”。但他补充说:”如果AIGC水印很容易去除或伪造,我们就可以随意通过添加水印让别人相信作品是人工智能生成的,或者通过去除水印让别人相信AIGC是人类创造的。”

论文探讨了当前水印方法的各种漏洞。

“论文指出:”AIGC 的水印方案很容易受到对手的攻击,对手可以在不知道秘钥的情况下去除水印。这一漏洞会对现实世界产生影响,尤其是当涉及到错误信息或恶意使用人工智能生成的内容时。

“如果一些恶意用户在去除水印后传播人工智能生成的某些名人的虚假图片,由于我们没有足够的证据,因此无法证明这些图片是人工智能生成的,”Li 告诉 TCN。

李和他的团队进行了一系列实验,测试了当前水印方法对人工智能生成内容的鲁棒性和完整性。他们采用各种技术去除或篡改水印,评估每种方法的易用性和有效性。结果一致表明,水印相对容易被破坏。

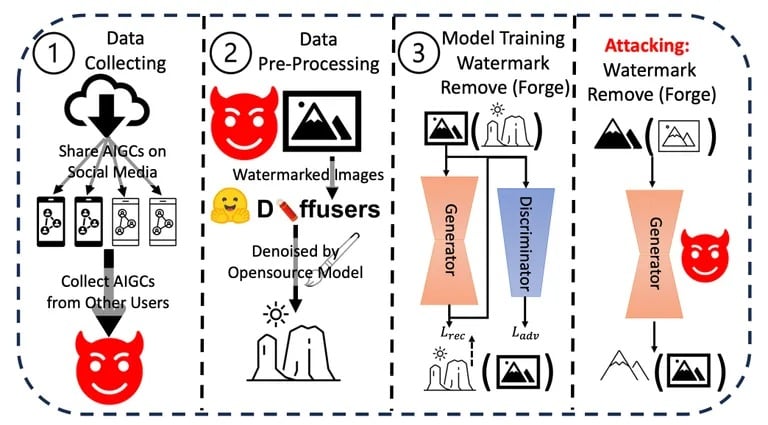

研究中使用的攻击程序。图片来源:Arvix

他们进一步评估了这些漏洞对现实世界的潜在影响,尤其是在涉及错误信息或恶意使用人工智能生成内容的场景中。这些实验和分析的累积结果使他们得出结论:迫切需要更强大的水印机制。

尽管 OpenAI 等公司已经宣布,他们已经开发出检测人工智能生成内容的方法,准确率达到 99%,但总体挑战依然存在。目前的识别方法,如元数据和隐形水印,都有其局限性。

Li建议:”最好将数字签名等加密方法与现有的水印方案结合起来,以保护AIGC。

其他研究人员提出了一种更极端的方法。正如 TCN 最近报道的那样,麻省理工学院(MIT)的一个团队建议将图像变成人工智能模型的 “毒药”。如果使用 “中毒 “图像作为训练数据集的输入,最终模型将产生糟糕的结果,因为它将捕捉人眼无法看到但对学习过程有很大影响的细节。这就像一个致命的水印,会杀死训练它的模型。

OpenAI 首席执行官萨姆-奥特曼(Sam Altman)强调,人工智能的快速发展表明,未来人工智能固有的思维过程可以反映人类的逻辑和直觉。随着这种进步,对水印等强大安全措施的需求变得更加重要。

李认为,”水印和内容管理是必不可少的,因为它们实际上不会影响普通用户”,但创作者和反对者之间的冲突仍在继续。”这永远是一场猫捉老鼠的游戏……这就是我们需要不断更新水印方案的原因。”