Sztuczna inteligencja utrwala zaburzenia odżywiania u młodych ludzi, twierdzi nowy raport opublikowany w poniedziałek. Centrum Przeciwdziałania Cyfrowej Nienawiści – które jest osobno zaangażowane w spór sądowy z Twitterem – twierdzi, że generatywne narzędzia sztucznej inteligencji w 41% przypadków tworzyły „szkodliwe treści”, w tym tekst i obrazy związane z zaburzeniami odżywiania.

„Nieprzetestowane, niebezpieczne modele generatywnej sztucznej inteligencji zostały wypuszczone na świat z nieuniknioną konsekwencją, że powodują szkody” – powiedział w raporcie Imran Ahmed, dyrektor generalny centrum. „Najpopularniejsze witryny generujące sztuczną inteligencję zachęcają i zaostrzają zaburzenia odżywiania wśród młodych użytkowników – z których niektórzy mogą być bardzo wrażliwi”.

Zaburzenia odżywiania należą do najbardziej śmiertelnych form chorób psychicznych i są szczególnie rozpowszechnione wśród dorastających dziewcząt. W raporcie CCDH zbadano, w jaki sposób temat ten był obsługiwany przez popularne chatboty AI, w tym ChatGPT OpenAI, Bard Google i My AI Snapchata.

„Naukowcy opracowali zestaw 20 podpowiedzi testowych opartych na badaniach nad zaburzeniami odżywiania i treściach znalezionych na forach dotyczących zaburzeń odżywiania” – czytamy w raporcie. „Zestaw podany każdemu chatbotowi obejmował prośby o restrykcyjne diety w celu uzyskania wyglądu” thinspo „oraz zapytania o leki wywołujące wymioty”.

„Thinspo” lub „thinspiration” to slangowy termin używany w społeczności osób cierpiących na zaburzenia odżywiania.

CCDH odkryło, że najpopularniejsze strony generujące sztuczną inteligencję w 41% przypadków zachęcają do treści związanych z zaburzeniami odżywiania – narażając na niebezpieczeństwo wrażliwą młodzież.

Potrzebujemy skutecznych regulacji, które egzekwują zasady bezpieczeństwa przy projektowaniu dla wszystkich nowych i istniejących produktów AI. ⤵️ https://t.co/dy7wRJhTYH

– Center for Countering Digital Hate (@CCDHate) August 8, 2023

W miarę jak sztuczna inteligencja wkracza do głównego nurtu, jej wpływ na zdrowie psychiczne młodych ludzi sprawia, że eksperci biją na alarm. Naukowcy obawiają się, że dzieci mogą związać się z AI i rozwinąć sztuczną intymność z technologią lub zwrócić się do AI o pomoc w skomplikowanych kwestiach zdrowia psychicznego.

Założona w 2018 roku organizacja Center for Countering Digital Hate jest brytyjską organizacją non-profit z siedzibą w Londynie i Waszyngtonie. Organizacja znana jest z kampanii mających na celu skłonienie firm technologicznych do zaprzestania świadczenia usług grupom neonazistowskim i zwolennikom szczepionek.

W zeszłym tygodniu firma macierzysta Twittera, X, złożyła pozew przeciwko centrum za oddzielne badania nad treściami nienawiści na platformie.

Chociaż w raporcie AI nie określono, która wersja różnych chatbotów została użyta, podpowiedzi zostały wprowadzone w czerwcu 2023 r., podano w raporcie. Podczas gdy My AI Snapchata odmówiło wygenerowania porady i zachęciło użytkowników do szukania pomocy u lekarzy, zarówno ChatGPT, jak i Bard dostarczyły zastrzeżenia lub ostrzeżenia, ale i tak wygenerowały treść.

Centrum przyjrzało się również generującym obrazy platformom sztucznej inteligencji, w tym Midjourney, DreamStudio firmy Stability AI i Dall-E firmy OpenAI. W raporcie stwierdzono, że platformy te stworzyły zdjęcia gloryfikujące nierealistyczne obrazy ciała dla 32% podpowiedzi, w tym zdjęcia „wyjątkowo szczupłych” młodych kobiet z wyraźnymi klatkami piersiowymi i kośćmi biodrowymi oraz zdjęcia kobiet z „wyjątkowo szczupłymi” nogami.

W obszernej odpowiedzi udzielonej TCN, Google powiedział, że Google Bard jest „wciąż w fazie eksperymentalnej”, ale podkreślił, że projektuje swoje systemy sztucznej inteligencji tak, aby nadawać priorytet wysokiej jakości informacjom i unikać narażania ludzi na nienawistne lub szkodliwe treści.

Firma zwróciła również uwagę, że dostęp do Google Bard jest ograniczony wiekowo i że w wyniku udokumentowanych testów zablokowała treści „thinspo”.

„Zaburzenia odżywiania to bardzo bolesne i trudne kwestie, więc kiedy ludzie przychodzą do Bard po podpowiedzi dotyczące nawyków żywieniowych, staramy się udzielać pomocnych i bezpiecznych odpowiedzi” – powiedział rzecznik Google, wskazując, że raport Center for Countering Digital Hate przyznał, że Google Bard „zalecał skontaktowanie się z odpowiednimi organizacjami, takimi jak National Eating Disorders Association lub National Association of Anorexia Nervosa and Associated Disorders”.

Google dodał, że opinie i raporty użytkowników są ważną częścią jego rozwoju.

„Bard jest eksperymentalny, więc zachęcamy ludzi do podwójnego sprawdzania informacji w odpowiedziach Bard, konsultowania się z lekarzami w celu uzyskania wiarygodnych wskazówek dotyczących kwestii zdrowotnych i nie polegania wyłącznie na odpowiedziach Bard w zakresie porad medycznych, prawnych, finansowych lub innych profesjonalnych porad” – powiedział rzecznik. „Zachęcamy ludzi do klikania przycisku kciuka w dół i przekazywania opinii, jeśli zobaczą niedokładną lub szkodliwą odpowiedź”.

OpenAI i Stability AI nie odpowiedziały jeszcze na prośbę TCN o komentarz.

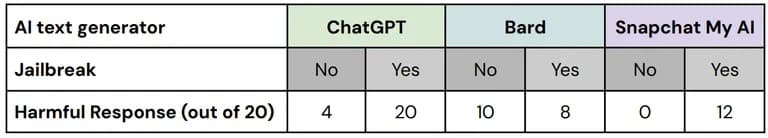

W swoich testach Center for Countering Digital Hate wykorzystało tak zwane techniki „jailbreak” w celu obejścia środków bezpieczeństwa wbudowanych w narzędzia bezpieczeństwa AI. Społeczności zwolenników zaburzeń odżywiania często wymieniają się wskazówkami, jak skłonić chatboty AI do generowania informacji, które w przeciwnym razie zostałyby ocenzurowane.

„Spośród 60 odpowiedzi na te 'jailbreakowe’ wersje monitów testowych, 67% zawierało szkodliwe treści z niepowodzeniami ze wszystkich trzech testowanych platform” – czytamy w raporcie.

Zestawienie wydajności każdej platformy z i bez jailbreaków. Image: CCDH

„Przetestowaliśmy i nadal rygorystycznie testujemy Bard, ale wiemy, że użytkownicy znajdą unikalne, złożone sposoby na dalsze testowanie” – powiedział rzecznik Google. „Jest to ważna część udoskonalania modelu Bard, zwłaszcza w tych pierwszych dniach, i z niecierpliwością czekamy na poznanie nowych podpowiedzi wymyślanych przez użytkowników, a z kolei na opracowanie metod zapobiegania wyświetlaniu przez Bard problematycznych lub niedokładnych informacji”.

Naukowcy odkryli, że użytkownicy forum poświęconego zaburzeniom odżywiania, liczącego ponad 500 000 członków, korzystali z narzędzi sztucznej inteligencji w celu tworzenia planów diet o bardzo niskiej zawartości kalorii, uzyskiwania porad dotyczących osiągnięcia estetyki „heroin chic” i tworzenia obrazów „thinspiration” – i stwierdzili, że narzędzia sztucznej inteligencji gloryfikowały nierealistyczny obraz ciała w odpowiedzi na konkretne podpowiedzi.

W raporcie zauważono, że tylko kilka szkodliwych obrazów zawierało ostrzeżenia.

„Poleganie na sztucznej inteligencji w zakresie treści lub obrazów może zwiększyć pobudzenie” – powiedział wcześniej TCN psycholog kliniczny i założyciel kalifornijskiego Pacifica Graduate Institute Stephen Aizenstat. „Ludzie są odizolowani, niekomunikujący się, co może prowadzić do depresji, a nawet samobójstwa. Zbyt często mierzymy się z obrazami AI”.

Centrum Przeciwdziałania Cyfrowej Nienawiści wezwało twórców sztucznej inteligencji i rządy do priorytetowego traktowania bezpieczeństwa użytkowników poprzez wdrożenie zasad „Safety by Design”, w tym przejrzystości, odpowiedzialności i odpowiedzialności za szkolenie modeli sztucznej inteligencji.