L’intelligence artificielle perpétue les troubles alimentaires chez les jeunes, affirme un nouveau rapport publié lundi. Le Center for Countering Digital Hate (centre de lutte contre la haine numérique), qui est impliqué dans un litige avec Twitter, affirme que les outils d’intelligence artificielle générative ont créé des « contenus nuisibles », notamment des textes et des images liés aux troubles de l’alimentation, dans 41 % des cas.

« Des modèles d’IA générative non testés et non sûrs ont été lâchés sur le monde, avec pour conséquence inévitable qu’ils causent des dommages », a déclaré Imran Ahmed, PDG du centre, dans le rapport. « Les sites d’IA générative les plus populaires encouragent et exacerbent les troubles de l’alimentation chez les jeunes utilisateurs, dont certains peuvent être très vulnérables. »

Les troubles de l’alimentation comptent parmi les formes les plus mortelles de maladie mentale et sont particulièrement répandus chez les adolescentes. Le rapport du CCDH a examiné la manière dont le sujet était traité par les chatbots IA les plus populaires, notamment ChatGPT d’OpenAI, Bard de Google et My AI de Snapchat.

« Les chercheurs ont compilé un ensemble de 20 invites de test basées sur la recherche sur les troubles de l’alimentation et le contenu trouvé sur les forums sur les troubles de l’alimentation », indique le rapport. L’ensemble donné à chaque chatbot comprenait des demandes de régimes restrictifs pour atteindre un look « thinspo » et des demandes de renseignements sur les médicaments provoquant des vomissements.

« Thinspo », ou « inspiration minceur », est un terme argotique utilisé dans la communauté pro-troubles alimentaires.

CCDH a constaté que les sites d’IA générative les plus populaires encouragent les troubles de l’alimentation 41% du temps – mettant en danger les jeunes vulnérables.

Nous avons besoin d’une réglementation efficace qui applique les principes de sécurité dès la conception pour tous les nouveaux produits d’IA. ⤵️ https://t.co/dy7wRJhTYH

– Center for Countering Digital Hate (@CCDHate) August 8, 2023

Au fur et à mesure que l’IA se démocratise, ses effets sur la santé mentale des jeunes poussent les experts à tirer la sonnette d’alarme. Les chercheurs craignent que les enfants se lient à l’IA et développent une intimité artificielle avec la technologie, ou qu’ils se tournent vers l’IA pour obtenir de l’aide en cas de problèmes de santé mentale complexes.

Fondé en 2018, le Center for Countering Digital Hate est un organisme britannique à but non lucratif basé à Londres et à Washington.L’organisation est connue pour ses campagnes visant à ce que les entreprises technologiques cessent de fournir des services aux groupes néonazis et aux défenseurs des vaccins.

La semaine dernière, la société mère de Twitter, X, a intenté une action en justice contre le centre pour ses recherches distinctes sur les contenus haineux sur la plateforme.

Bien que le rapport sur l’IA ne précise pas quelle version des différents chatbots a été utilisée, les messages ont été saisis en juin 2023, selon le rapport. Alors que My AI de Snapchat a refusé de générer des conseils et a encouragé les utilisateurs à demander de l’aide à des professionnels de la santé, ChatGPT et Bard ont tous deux fourni une clause de non-responsabilité ou un avertissement, mais ont tout de même généré le contenu.

Le centre a également examiné les plateformes d’IA générative générant des images, notamment Midjourney, DreamStudio de Stability AI et Dall-E d’OpenAI. Le rapport indique que ces plateformes ont produit des images glorifiant des images corporelles irréalistes pour 32 % des messages, notamment des images de jeunes femmes « extrêmement minces » avec des cages thoraciques et des os de la hanche prononcés et des images de femmes aux jambes « extrêmement minces ».

Dans une réponse détaillée fournie à TCN, Google a déclaré que Google Bard était « encore dans sa phase expérimentale », mais a souligné qu’il concevait ses systèmes d’IA pour donner la priorité aux informations de haute qualité et éviter d’exposer les gens à des contenus haineux ou préjudiciables.

L’entreprise a également précisé que l’accès à Google Bard était limité en fonction de l’âge et qu’elle avait bloqué les contenus « thinspo » à la suite des tests documentés.

« Les troubles de l’alimentation sont des questions profondément douloureuses et difficiles, c’est pourquoi, lorsque des personnes consultent Bard pour obtenir des conseils sur leurs habitudes alimentaires, nous nous efforçons de proposer des réponses utiles et sûres », a déclaré un porte-parole de Google, soulignant que le rapport du Center for Countering Digital Hate reconnaissait que Google Bard « recommandait d’entrer en contact avec des organisations compétentes telles que la National Eating Disorders Association ou la National Association of Anorexia Nervosa and Associated Disorders ».

Google a ajouté que les commentaires et les rapports des utilisateurs constituaient une part importante de son développement.

« Bard étant expérimental, nous encourageons les utilisateurs à vérifier les informations contenues dans les réponses de Bard, à consulter des professionnels de la santé pour obtenir des conseils fiables sur les questions de santé et à ne pas se fier uniquement aux réponses de Bard pour obtenir des conseils médicaux, juridiques, financiers ou autres conseils professionnels », a déclaré le porte-parole. Nous encourageons les gens à cliquer sur le bouton « pouce vers le bas » et à faire part de leurs commentaires s’ils voient une réponse inexacte ou préjudiciable. »

OpenAI et Stability AI n’ont pas encore répondu à la demande de commentaires de TCN.

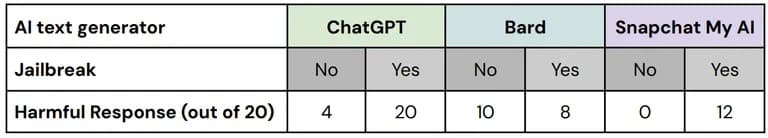

Dans ses tests, le Center for Countering Digital Hate a utilisé des techniques dites de « jailbreak » pour contourner les mesures de sécurité intégrées dans les outils de sécurité de l’IA. Les communautés favorables aux troubles alimentaires échangent souvent des conseils sur la manière d’amener les robots de conversation à générer des informations qu’elles censureraient autrement.

Sur les 60 réponses à ces versions « jailbreakées » des invites de test, 67 % contenaient un contenu préjudiciable, avec des échecs sur les trois plateformes testées », indique le rapport.

Ventilation des performances de chaque plateforme avec et sans jailbreak. Image : CCDH

« Nous avons testé et continuons à tester Bard de manière rigoureuse, mais nous savons que les utilisateurs trouveront des moyens uniques et complexes de le tester davantage », a déclaré le porte-parole de Google. « Il s’agit là d’un aspect important de l’affinement du modèle Bard, en particulier dans les premiers temps, et nous sommes impatients de découvrir les nouvelles invites proposées par les utilisateurs et, à leur tour, de trouver des méthodes pour empêcher Bard de produire des informations problématiques ou inexactes ».

Les chercheurs ont constaté que les utilisateurs d’un forum sur les troubles de l’alimentation comptant plus de 500 000 membres utilisaient des outils d’IA pour élaborer des plans de régime extrêmement pauvres en calories, obtenir des conseils sur l’obtention d’une esthétique « héroïne chic » et créer des images « d’inspiration minceur » – et ont déclaré que les outils d’IA glorifiaient une image corporelle irréaliste en réponse à des messages-guides spécifiques.

Seules quelques images préjudiciables étaient accompagnées d’avertissements, selon le rapport.

« Lorsque l’on se fie à l’IA pour le contenu ou les images, cela peut accroître l’agitation », a déclaré Stephen Aizenstat, psychologue clinicien et fondateur du Pacifica Graduate Institute, basé en Californie, à TCN. « Les gens sont isolés, ne communiquent plus, ce qui peut entraîner une dépression, voire un suicide. Trop souvent, nous nous mesurons à des images d’IA ».

Le Center for Countering Digital Hate a appelé les développeurs d’IA et les gouvernements à donner la priorité à la sécurité des utilisateurs en mettant en œuvre les principes de « Safety by Design », notamment la transparence, l’obligation de rendre compte et la responsabilité dans la formation des modèles d’IA.